IO.NET ist eine dezentrale AI -Computing -Plattform, die von IO Research entwickelt wurde und in seiner jüngsten Finanzierungsrunde 1 Milliarde US -Dollar an FDV -Bewertung erreicht hat.

IO.NET kündigte im März dieses Jahres an, eine Finanzierung von 30 Millionen US -Dollar unter der Leitung von Hack VC zu absolvieren, darunter Multicoin Capital, 6. Man Ventures, Solana Ventures, Aptos Labs, Delphi Digital, das Sandbo X und das Sebastian Borget des Sandboxs und andere Teilnahme.

IO.NET konzentriert sich darauf, GPU -Ressourcen für KI- und maschinelle Lernunternehmen zu aggregieren, und setzt sich für die Bereitstellung von Dienstleistungen zu geringeren Kosten und zu einer schnelleren Lieferzeit ein.Seit seiner Einführung im November letzten Jahres ist IO.net auf mehr als 25.000 GPUs angewachsen und hat mehr als 40.000 Berechnungszeiten für künstliche Intelligenz- und maschinelle Lernunternehmen behandelt.

Die Vision von IO.NET besteht darin, ein Ökosystem zwischen einem globalen De -Central -AI -Computernetzwerk für KI- und maschinelle Lernteams/-unternehmen und leistungsstarke GPU -Ressourcen auf der ganzen Welt aufzubauen.

In diesem Ökosystem werden AI Computing -Ressourcen kommerzialisiert, und die Angebots- und Nachfrageparteien werden sich aufgrund von Ressourcen nicht mehr stören.In Zukunft wird IO.NET auch Zugriff auf IO -Modellspeicher und erweiterte Argumentationsfunktionen wie kein Server -Argumentation, Cloud -Spiel und Pixelflow gewähren.

Geschäftlicher Hintergrund

Bevor wir die Geschäftslogik von IO.NET einführen, müssen wir zunächst die Spur der dezentralen Rechenleistung aus zwei Dimensionen verstehen: Einer ist der Entwicklungsprozess des AI -Computer . Fall.

Wir können die Entwicklungsbahn dieses KI -Computers aus mehreren kritischen Zeitpunkten darstellen:

1. Frühes Stadium des maschinellen Lernens (1980er Jahre -2000er Jahre)

In dieser Zeit konzentrieren sich maschinelle Lernmethoden hauptsächlich auf relativ einfache Modelle wie Entscheidungsbäume und Support Vector Machines (SVM).Die Computeranforderungen dieser Modelle sind relativ niedrig und können zu diesem Zeitpunkt auf PCs oder kleinen Servern betrieben werden.Der Datensatz ist relativ gering, und die Auswahl der Feature Engineering und der Modell sind wichtige Aufgaben.

Zeitpunkt: Von den 1980er bis Anfang 2000

Rechenleistung Anforderungen: Relativ niedrige, PCs oder kleine Server können den Anforderungen entsprechen.

Berechnen Sie Hardware: CPU dominiert die Rechenressourcen.

Zweitens der Aufstieg von Deep Learning (2006-Rezent)

Im Jahr 2006 wurde das Konzept des Deep -Lernens erneut eingeführt und diese Zeit durch die Forschung von Hinton et al.Anschließend markierten die erfolgreiche Anwendung von tiefen neuronalen Netzwerken, insbesondere des Faltungsnetzes (CNN) und des zirkulierenden neuronalen Netzwerks (RNN), den Durchbruch in diesem Bereich.Die Nachfrage nach Rechenressourcen in diesem Stadium hat sich erheblich zugenommen, insbesondere bei der Verarbeitung von Big -Data -Sets wie Bildern und Sprache.

Zeitpunkt:

Der Imagnet -Wettbewerb (2012): Der Sieg von Alexnet in diesem Wettbewerb ist ein ikonisches Ereignis in der Geschichte des Deep Learning.

Alphago (2016): Die Alphago von Google DeepMind besiegte den Weltmeister Li Shishi.

Rechenleistung Anforderungen: Um komplexe tiefe neuronale Netze zu schulen, sind erheblich erhöhte, leistungsstärkere Computerressourcen erforderlich.

Berechnungshardware: GPUs werden zu einer Schlüsselhardware für Deep Learning Training, da sie bei der parallelen Verarbeitung weitaus besser sind als CPUs.

Drittens die Ära der großen Sprachmodelle (2018 bis heute)

Mit der Entstehung von Bert (2018) und der GPT -Technologie (nach 2018) dominierten die großen Modelle die KI -Spur.Diese Modelle haben in der Regel Milliarden- bis Billionen -Dollar -Parameter, und die Nachfrage nach Rechenressourcen hat beispiellose Niveaus erreicht.Das Training dieser Modelle erfordert eine große Anzahl von GPUs oder professionelleren TPUs und eine große Menge an Strom- und Kühleinrichtungen.

Zeitpunkt: 2018 bis heute.

Rechenleistung Anforderungen: Extrem hoch, eine große Menge an GPU oder TPU ist erforderlich, um eine Skala zu bilden, und durch entsprechende Infrastrukturunterstützung ergänzt.

Berechnung der Hardware: Zusätzlich zu GPU und TPU gibt es auch spezielle Hardware für große maschinelle Lernmodelle wie die TPU -Serie von Google, die A- und H -Serie von NVIDIA usw.

Aus der Sicht des exponentiellen KI in den letzten 30 Jahren hat die Nachfrage nach Rechenleistung im frühen maschinellen Lernen eine geringere Nachfrage nach RechenleistungWir haben die signifikante Verbesserung der Berechnung der Hardware von der Menge zur Leistung erlebt.

Dieses Wachstum spiegelt sich nicht nur in der Expansion des Umfangs traditioneller Rechenzentren und der Verbesserung der Hardwareleistung wie der GPU wider, sondern spiegelt auch die hohe Investitionsschwelle und die großzügigen Rückgaberegeln wider, die ausreichen, um den Kampf zwischen Internetgiganten zu führen.

Das traditionelle zentrale GPU -Computer -Power Center benötigt eine teure Hardwarebeschaffung (wie die GPU selbst), die Bau- oder Leasingkosten des Rechenzentrums, des Kühlsystems und die Kosten für Wartungspersonal.

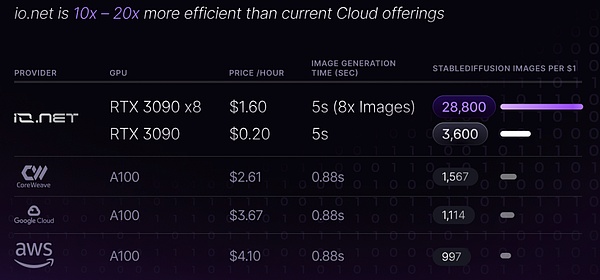

Im Gegensatz dazu hat das dezentrale Berechnungsplattformprojekt von IO.NET offensichtliche Vorteile der Baukosten, die die anfänglichen Investitionen und die Betriebskosten erheblich senken können.

Die Verwendung der vorhandenen verteilten Ressourcen des dezentralen GPU -Projekts muss nicht auf den Bau von Hardware und Infrastruktur konzentriert werden.Einzelpersonen und Unternehmen können zum Netzwerk von GPU -Ressourcen in Leerlauf beitragen, wodurch die Bedürfnisse zentraler Beschaffung und Bereitstellung von Ressourcen mit hoher Performance -Computing verringert werden.

Zweitens muss der traditionelle GPU -Cluster in Bezug auf die Betriebskosten kontinuierlich aufrechterhalten werden, Strom- und Kühlkosten.Das dezentrale GPU -Projekt kann diese Kosten an jedem Knoten mitteilen, indem sie verteilte Ressourcen verwenden, wodurch die Betriebsbelastung einer einzelnen Organisation verringert wird.

Laut IO.net -Dokumenten hat IO.net die Betriebskosten durch Aggregation von unabhängigen Rechenzentren, Kryptowährungsminen und anderen Hardware -Netzwerken wie Filecoin und Render stark gesenkt.In Verbindung mit der wirtschaftlichen Incentive -Strategie des Web3 hat IO.net große Vorteile bei der Preisgestaltung.

>

Im Rückblick auf die Geschichte erzielten in der Vergangenheit einige dezentrale Computerprojekte, ohne wirtschaftliche Anreize zu ermöglichen.Zum Beispiel:

Folding@Home: Dies ist ein Projekt, das von der Stanford University initiiert wird.Während der Covid-19-Epidemie sammelte das Folding@Home-Projekt eine große Menge an Rechenressourcen, um das neue Koronalvirus zu untersuchen.

BOINC (Berkeley Open Infrastic for Network Computing) **: Dies ist eine Open -Source -Softwareplattform, die verschiedene Arten von Freiwilligen und Raster -Computing -Elementen unterstützt, darunter Astronomie, Medizin, Klimawissenschaft und viele andere Bereiche.Benutzer können Idle -Computing -Ressourcen einbringen und an verschiedenen wissenschaftlichen Forschungsprojekten teilnehmen.

Diese Projekte beweisen nicht nur die Machbarkeit einer dezentralen Berechnung, sondern zeigen auch das enorme Entwicklungspotenzial dezentraler Berechnungen.

Durch die Mobilisierung von nicht verwendeten Computerressourcen aus allen Lebensbereichen kann es die Rechenleistung erheblich verbessern.Web3 -Erfahrung zeigt, dass von Benutzern ein angemessener Anreizmechanismus angezogen und gepflegt wird.

Durch die Einführung des Incentive -Modells kann es ein Gewinn -Win -Community -Umfeld aufbauen, in dem die Ausweitung der geschäftlichen Skala weiter fördern und den technologischen Fortschritt im Zyklus fördern kann.

Daher kann IO.NET die Teilnehmer durch die Einführung von Incentive -Mechanismen weit verbreitete Teilnehmer anziehen, das Computer gemeinsam beitragen und ein starkes dezentrales Computernetzwerk bilden.

Das Wirtschaftsmodell und das dezentrale Rechenleistungspotential von Web3 bieten IO.NET eine starke Wachstumsdynamik und erreichen eine effiziente Ressourcenauslastung und Kostenoptimierung.Dies fördert nicht nur die technologische Innovation, sondern bietet auch einen Mehrwert für die Teilnehmer, was IO.NET im Wettbewerb im KI -Bereich mit großem Entwicklungspotential und Marktraum hervorheben kann.

IO.NET -Technologie

Der GPU -Cluster bezieht sich auf komplexe Berechnungen, die mehrere GPUs über das Netzwerk verbinden, um einen kollaborativen Computing -Cluster zu bilden.

Cluster Computing beschleunigt nicht nur die Trainingsgeschwindigkeit des KI -Modells, sondern verbessert auch die Fähigkeit, große Datensätze zu verarbeiten, wodurch KI -Anwendungen flexibler und skalierbarer werden.

Während der traditionellen KI -Modelle für Internet -Trainings sind große GPU -Cluster erforderlich.Wenn wir jedoch in Betracht ziehen, diesen Cluster -Computermodus in die Dezentralisierung zu verwandeln, entstand eine Reihe technischer Herausforderungen.

Im Vergleich zum AI Computing -Cluster des herkömmlichen Internetunternehmens und des dezentralen GPU -Cluster -Computing werden weitere Probleme konfrontiert, z. Die Geschwindigkeit zwischen Knoten beeinflusst die Gesamtberechnungseffizienz.

Darüber hinaus ist die Aufrechterhaltung der Konsistenz und der realen Synchronisation von Daten zwischen jedem Knoten von wesentlicher Bedeutung, um die Genauigkeit der Berechnungsergebnisse sicherzustellen.Daher erfordert dies die dezentrale Computerplattform, um ein effizientes Datenmanagement- und Synchronisationsmechanismen zu entwickeln.

Und wie man dezentrale Computerressourcen verwaltet und verstreut kann, um sicherzustellen, dass Computeraufgaben effektiv abgeschlossen werden können. Es ist auch ein Problem, dass die dezentrale Clusterberechnung gelöst werden muss.

IO.net hat eine dezentrale Cluster -Computing -Plattform durch Integration von Ray und Kubernetes erstellt.

Als verteiltes Computerframework ist Ray direkt für die Durchführung von Computeraufgaben an mehreren Knoten verantwortlich.

Kubernetes spielt in diesem Prozess eine wichtige Verwaltungsrolle.

In diesem System realisiert die Kombination von Ray und Kubernetes eine dynamische und elastische Computerumgebung.Ray stellt sicher, dass die Computeraufgabe an geeigneten Knoten effizient ausgeführt werden kann, während Kubernetes die Stabilität und Skalierbarkeit des gesamten Systems garantiert und automatisch die Erhöhung oder Entfernung des Knotens behandelt.

Diese Synergie ermöglicht IO.NET, kohärente und zuverlässige Computerdienste in dezentralen Umgebungen anzubieten.

Auf diese Weise optimiert IO.NET nicht nur den Einsatz von Ressourcen, sondern verbessert auch die Flexibilität des Systems und die Kontrolle der Benutzer.Benutzer können Rechenaufgaben verschiedener Skala problemlos bereitstellen und verwalten, ohne sich über die spezifischen Allokations- und Verwaltungsdetails der zugrunde liegenden Ressourcen zu sorgen.

Dieser dezentrale Computermodus mit den leistungsstarken Funktionen von Ray und Kubernetes gewährleisten die Effizienz und Zuverlässigkeit der IO.NET -Plattform bei der Verarbeitung komplexer und großer Computeraufgaben.

Da die dezentrale Cluster -Task -Bereitstellungslogik viel komplizierter ist als die Cluster -Logik im Maschinenraum und angesichts der Übertragung von Daten und Rechenaufgaben im Netzwerk potenzielle Sicherheitsrisiken hinzufügen.

IO.NET verbessert die Sicherheit und Privatsphäre des Netzwerks, indem sie die Dezentralisierungseigenschaften des Mesh Private Network Channels nutzt.In einem solchen Netzwerk ist das Risiko von Einzelpoint -Fehlern, die dem Netzwerk ausgesetzt sind, erheblich verringert, wenn einige Knoten auf Probleme mit dem gesamten Netzwerk konfrontiert sind.

Die Daten werden entlang mehrerer Pfade im Netzwerknetzwerk übertragen.

Durch die Einführung von Technologien wie Datenpaketfüllung und Zeitverwirrung (Verkehrsverzeigerung) kann das Netzwerk -VPN -Netzwerk den Datenfluss weiter verwischen, was es für Trauungsdropper schwierig macht, den Verkehrsmodus zu analysieren oder bestimmte Benutzer oder Datenströme zu identifizieren.

Der Datenschutzmechanismus von IO.NET kann Datenschutzprobleme effektiv lösen, da sie gemeinsam eine komplexe und variable Datenübertragungsumgebung erstellen, was es für externe Beobachter schwierig macht, nützliche Informationen zu erfassen.

Gleichzeitig vermeidet die dezentrale Struktur das Risiko, dass alle Daten durch einen einzigen Punkt fließen.Gleichzeitig lieferte die Multi -Path -Übertragung und die Verwirrungsstrategie des Verkehrs gemeinsam eine zusätzliche Schutzschicht für die Datenübertragung des Benutzers, die die Gesamt Privatsphäre des IO.NET -Netzwerks verbesserte.

Wirtschaftsmodell

IO ist die native Kryptowährung und das Protokoll für das IO.NET -Netzwerk, das den Anforderungen der beiden Haupteinheiten im Ökosystem entsprechen kann: KI -Startups und -Entwickler sowie Computer -Leistungsanbieter.

Für KI -Startups und -Entätigkeiten vereinfacht IO den Zahlungsverfahren der Cluster -Bereitstellung, was bequemer ist.Jedes Modell, das auf IO.NET bereitgestellt wird, muss durch winzige IO -Währungstransaktionen abgeleitet werden.

Für Lieferanten, insbesondere die Anbieter von GPU -Ressourcen, stellen die IO -Münzen sicher, dass ihre Ressourcen ziemlich zurückgegeben wurden.Unabhängig von der direkten Rückgabe der GPU, wenn die GPU gemietet wird oder das passive Einkommen aus dem Netzwerkmodell in der Freizeit abgeleitet wird, bietet die IO -Münze eine Belohnung für jeden Beitrag der GPU.

Im IO.NET -Ökosystem ist die IO -Währung nicht nur ein Medium für Zahlung und Anreize, sondern auch der Schlüssel zur Regierungsführung.Dadurch wird jeder Verknüpfung von Modellentwicklung, Schulung, Bereitstellung und Anwendungsentwicklung transparenter und effizienter und gewährleistet die gegenseitige Nutzen und Gewinn -Gewinn -Situation zwischen den Teilnehmern.

Auf diese Weise inspirierten IO -Münzen nicht nur die Teilnahme und den Beitrag des Ökosystems, sondern bildeten auch eine umfassende Support -Plattform für KI -Startups und -ingenieure, die die Entwicklung und Anwendung der KI -Technologie fördert.

IO.NET hat hart an dem Incentive -Modell gearbeitet, um sicherzustellen, dass das gesamte Ökosystem weiter verbreitet werden kann.Das Ziel von IO.NET ist es, für jede GPU -Karte einen im US -Dollar ausgedrückten Direktstundensatz festzulegen.Dies erfordert einen klaren, fairen und dezentralen GPU/CPU -Ressourcenpreismechanismus.

Als bilateraler Markt besteht der Kernschlüssel für die Motivation von Modellen darin, die beiden Hauptherausforderungen zu lösen: Einerseits sind die hohen Kosten für die Reduzierung der Rechenleistung des Mietens von GPU/CPU der Schlüsselindikator für die Erweiterung der Anforderungen von AI und ML Computing Kraft;

Daher umfassen die Bedürfnisse der Nachfrage die Preisgestaltung und Verfügbarkeit von Wettbewerbern, um wettbewerbsfähige und attraktive Auswahlmöglichkeiten auf dem Markt zu gewährleisten und die Preisgestaltung während der Spitzenzeiten und der Ressourcenspannung anzupassen.

In Bezug auf das Computerversorgung konzentriert sich IO.NET auf zwei Schlüsselmärkte: Spieler und verschlüsselte GPU -Bergleute.Spieler haben eine hohe Hardware und schnelle Internetverbindungen, aber normalerweise nur eine GPU -Karte.

Rechenleistungspreismodelle umfassen daher mehrdimensionale Faktoren wie die Hardwareleistung, die Internetbandbreite, die Preisgestaltung der Wettbewerber, die Verfügbarkeit von Versorgungsverfügbarkeit, die Peak -Time -Anpassung, die Preisgestaltung für Verpflichtungen und die Unterschiede.Darüber hinaus ist es notwendig, die besten Hardwaregewinne für andere Arbeitsnachweise zu berücksichtigen.

In Zukunft wird IO.NET weiter eine Reihe vollständig dezentraler Preislösungen angeben und ein Benchmark -Test -Tool erstellen, das SpeedTest.net für die Hardware von Bergarbeitern ähnlich ist, um einen vollständig dezentralen, fairen und transparenten Markt zu erstellen.

Teilnahmemethode

IO.net hat das Zündereignis gestartet,Dies ist die erste Stufe des IO.NET Community Incentive -PlansZiel ist es, das Wachstum des IO -Netzwerks zu beschleunigen.

Insgesamt geplantDreiBelohnungspools, sie sind völlig unabhängig.

-

Belohnung der Arbeiter (GPU)

-

Galaxy Mission Belohnung

-

Belohnung der Zwietracht Charakter (Airdrop -Rolle)

DasDreiDie Belohnungspools sind völlig unabhängig.

Für zugängliche Knoten werden die Airdrop-Punkte vom 4. November 2023-April 25, 2024 berechnet.Am Ende der Zündaktivität werden die vom Benutzer erzielten Airdrop -Punkte in eine Airdrop -Belohnung umgewandelt.

Berücksichtigung von vier Aspekten von Airdrop -Stubs:

A. Verhältnis von Job House -RJD) vom 4. November 2023 bis zum Ende des Ereignisses war die Gesamtzeit der Einstellung.

B. Bandbreite -bw) Klassifizierung der Bandbreite des Knotens basierend auf dem Bereich des Bandbreitenbereichs:

Niedrige Geschwindigkeit: Download -Geschwindigkeit 100 MB/pro Sekunde, Upload -Geschwindigkeit 75 MB/pro Sekunde.

Mittlere Geschwindigkeit: Download -Geschwindigkeit 400 MB/pro Sekunde, Upload -Geschwindigkeit 300 MB/pro Sekunde.

Hoch -Geschwindigkeit: Download -Geschwindigkeit 800 MB/pro Sekunde.

Das GPU -Modell (GPU -Modell -GM) wird gemäß dem GPU -Modell bestimmt.

D. Die Zeit für einen erfolgreichen Betrieb (UTTERTIME -UT) vom 4. November 2023 bis zum Gesamtabbau des erfolgreichen Betriebs des Arbeitnehmers bis zum Ende der Veranstaltung.

Es ist erwähnenswert, dass die Luftinvestitionspunkte für Benutzer um den 1. April 2024 voraussichtlich verfügbar sein werden.

Galaxy Task -Verbindungsadresse https://galxe.com/io.net/campaign/gcd5ot4oxpat

Die Belohnung wird vom IO.NET Community Management -Team überwacht und verlangt von Benutzern, die richtige Solana -Wallet -Adresse in Discord einzureichen.

Es wird an anderen Aktivitäten gemäß dem Grad des Beitrags, der Aktivität, der Erstellung von Inhalten usw. teilnehmen, um das entsprechende Airdrop -Rollenniveau zu erhalten.

Zusammenfassen

Im Allgemeinen eröffnen IO.NET und ähnliche dezentrale AI -Computerplattformen ein neues Kapitel in AI Computing, obwohl sie auch mit technischen Komplexität, Netzwerkstabilität und Datensicherheitsproblemen konfrontiert sind.IO.net hat jedoch das Potenzial, das KI -Geschäftsmodell vollständig zu ändern.Es wird angenommen, dass mit der Reife dieser Technologien und der Expansion von Rechenkraftgemeinschaften eine dezentrale AI -Computermacht zu einer Schlüsselkraft zur Förderung der KI -Innovation und -Populärisierung werden kann.