Senden Sie 13 Tweets hintereinander!

OpenAI Super Alignment LeaderJan LeikeDas heißt, derjenige, der Ilya gerade befolgt hat, um das Unternehmen zu verlassen, enthüllte den wirklichen Grund für seinen Rücktritt und mehr Insiderinformationen.

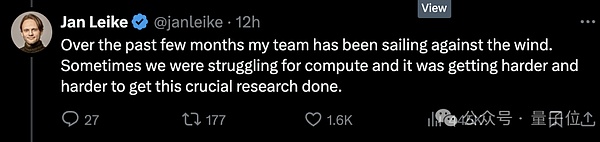

Erstens gibt es nicht genügend Rechenleistungversprach, einem supergerichteten Team einen Mangel von 20%zu geben, was das Team gegen die Strömung widerspricht, aber es wird immer schwieriger.

Zweitens wird die Sicherheit nicht ernst genommenDie Priorität der Sicherheitsregierungsfragen von AGI ist nicht so gut wie die Einführung eines „glänzenden Produkts“.

Unmittelbar danach wurde mehr Klatsch von anderen ausgegraben.

Zum Beispiel müssen alle Mitglieder von OpenAI eine Vereinbarung unterschreiben.Stellen Sie sicher, dass Sie nicht schlechte Dinge über Openai sagen, nachdem Sie Ihren Job verlassen habenWenn Sie nicht unterschreiben, werden Sie angesehen, dass Sie die Aktien des Unternehmens automatisch aufgeben.

Aber es gibt immer noch harte Knochen, die sich weigern, starke Nachrichten zu melden und zu veröffentlichen (lachen), und sagte, dass die Kernführung seit langem in Prioritäten von Sicherheitsproblemen aufgeteilt wurde.

Seit dem Schlacht des Palastes im letzten Jahr hat der Konflikt zwischen den beiden Fraktionen den kritischen Punkt erreicht, und dann scheint er ziemlich anständig zusammenzubrechen.

Obwohl Ultraman die Mitbegründer dazu gebracht hat, das Super-Alignment-Team zu übernehmen, wird es von der Außenwelt immer noch nicht bevorzugt.

Die Twitter -Internetnutzer, die an vorderster Front standen, dankten Jan, dass er den Mut hatte, diese erstaunliche Melone auszusprechen und seufzte:

Ich werde es einfach abholen, es scheint, dass Openai dieser Sicherheit wirklich nicht viel Aufmerksamkeit schenkt!

Rückblickend kann Ultraman, der jetzt für Openai verantwortlich ist, vorerst immer noch still sitzen.

Er stand auf, um Jan für seinen Beitrag zu Openais Super -Ausrichtung und Sicherheit zu danken, und sagte, er sei tatsächlich sehr traurig und zögerte, zu gehen.

Natürlich ist der Punkt tatsächlich dieser Satz:

Warten Sie, ich werde in zwei Tagen einen längeren Tweet veröffentlichen.

Die versprochene 20% Rechenleistung hat tatsächlich die Zutaten, große Kuchen zu malen

Von der Openai -Palastschlacht im letzten Jahr bis zur Gegenwart hat die Seelenfigur und der ehemalige Chefwissenschaftler Ilya fast nie öffentliche Auftritte oder öffentliche Stimmen gemacht.

Bevor er öffentlich zurückgetreten hatte, gab es viele verschiedene Meinungen.Viele Menschen denken, dass Ilya einige schreckliche Dinge gesehen hat, wie das KI -System, das Menschen zerstören kann.

△ NETIZEN: Das erste, was ich jeden Tag mache, wenn ich aufwache, ist, darüber nachzudenken, was Ilya sieht

Diesmal war Jan nur aus heiterem Himmel und der Grund war der Grund, dass die Priorität der technischen Parteien und der Sicherheit der Marktpartei unterschiedliche Meinungen aufwies.

Die Unterschiede sind sehr schwerwiegend und die Folgen sind derzeit … jeder hat sie auch gesehen.

Laut Vox enthüllte eine mit Openai vertraute Quelle dasMitarbeiter, die sich mehr auf die Sicherheit konzentrieren, haben das Vertrauen in Ultraman verloren„Dies ist ein Prozess des Vertrauens, der nach und nach zusammenbricht.“

Aber wie Sie sehen können, sind in öffentlichen Plattformen und Anlässen nicht viele Mitarbeiter bereit, öffentlich über diese Angelegenheit zu sprechen.

Ein Teil des Grundes ist, dass Openai immer warDie Tradition der Mitarbeiter unterzeichnet einen Rücktrittsvertrag mit Nicht-Department-Vereinbarungen.Wenn Sie sich weigern, zu unterschreiben, bedeutet dies, dass Sie die OpenAI -Option, die Sie zuvor erhalten haben, aufgegeben haben.Dies bedeutet, dass Mitarbeiter, die zum Sprechen kommen, eine große Geldsumme verlieren können.

Der Domino fiel jedoch immer noch um eins.

Der Rücktritt von Ilya hat die jüngste Rücktrittswelle von Openai verstärkt.

Auf die Ankündigung seines Rücktritts folgte mindestens fünf Mitglieder des Sicherheitsteams, mit Ausnahme von Jan, dem Leiter des Super -Alignment -Teams,.

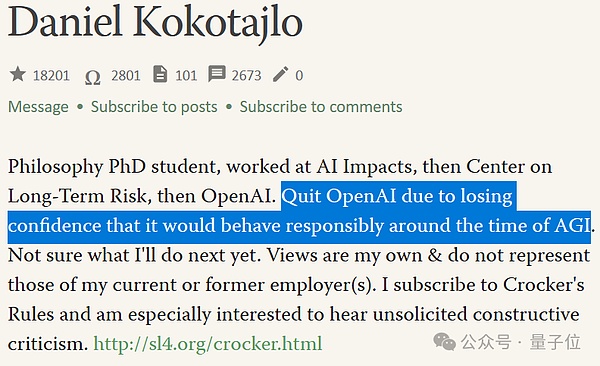

Unter ihnen gibt es einen weiteren harten Knochen, der kein Nicht-Depreciation-Abkommen unterzeichnet hat, Daniel Kokotajlo (im Folgenden als DK Brother bezeichnet).

△ Letztes Jahr schrieb DK, er glaube, dass die Möglichkeit einer Überlebenskatastrophe in AI 70% beträgt

Bruder DK kam im Jahr 2022 zu Openai und arbeitete im Governance -Team.

Aber er trat auch kürzlich zurück und wurde interviewt:

OpenAI trainiert leistungsstärkere KI -Systeme mit dem Ziel, die menschliche Intelligenz letztendlich zu übertreffen.

Dies mag das Beste sein, was der Menschheit jemals passiert ist, aber es mag das Schlimmste sein, wenn wir versehentlich handeln.

Bruder DK erklärte, als er sich Openai anschloss, sei er voller Rache und Hoffnung auf Sicherheit Governance, und hoffte, dass die engere Openai an Agi war, desto verantwortungsbewusster er sein konnte.Aber im TeamViele MenschenMir wurde allmählich klar, dass Openai nicht so sein wird.

„Ich habe allmählich das Vertrauen in die Openao -Führung und ihre Fähigkeit verloren, mit Agi verantwortungsbewusst umzugehen.“

Enttäuschung über die zukünftige AGI -Sicherheitsarbeit ist Teil des Grundes, warum alle in der verstärkten Welle der Abflüsse von Ilya zurückgelassen wurden.

Ein weiterer Teil des Grundes istDas überausgestattete Team ist wahrscheinlich nicht so in der Lage, Forschung mit reichlich Ressourcen durchzuführen, wie sich die Außenwelt vorstellt.

Selbst wenn das überausgestattete Team voll ausgestattet ist, kann das Team nur 20% der von OpenAI versprochenen Rechenleistung erhalten.

Und einige Anfragen des Teams werden oft abgelehnt.

Natürlich liegt es daran, dass Rechenressourcen für KI-Unternehmen äußerst wichtig sind und jeder Punkt vernünftig zugewiesen werden muss.

Mit anderen Worten, das Super -Alignment -Team entspricht den zukünftigen Sicherheitsproblemen, mit denen Openai ausgesetzt sein muss – die wichtigsten Punkte sind in Zukunft, und ich weiß nicht, ob es erscheinen wird.

Zum Zeitpunkt der Presse hat Ultraman seinen „längeren Tweet (als Jan’s Insider) nicht veröffentlicht.

Aber er erwähnte kurz, dass Jans Bedenken hinsichtlich Sicherheitsprobleme korrekt sind.„Wir haben viel zu tun;

In dieser Hinsicht kann jeder zuerst einen kleinen Hocker einrichten. Lassen Sie uns also so schnell wie möglich die Melonen zusammen essen.

Zusammenfassend lässt sich sagen, dass das Super -ausgerichtete Team viele Menschen, insbesondere den Rücktritt von Ilya und Jan, zurückgelassen hat, was dieses Team in eine schwierige Situation, in der es sich um einen Führer befindet, in den Sturm gebracht hat.

Die Follow-up-Anordnung istMitbegründer John Schulma übernimmt die Leitung, aber es gibt kein engagiertes Team mehr.

Das neue Super-Alignment-Team wird das lockerere Team mit Mitgliedern in den verschiedenen Abteilungen des Unternehmens sein. Ein OpenAI-Sprecher bezeichnete es als „mehr Integration“.

Dies wird auch von der Außenwelt in Frage gestellt, weilJohns ursprünglich Vollzeitjob bestand darin, die Sicherheit aktueller OpenAI-Produkte zu gewährleisten.

Ich frage mich, ob John beschäftigt sein kann, nachdem er plötzlich mehr Verantwortung hatte und die beiden Teams leiten kann, die auf die gegenwärtigen und zukünftigen Sicherheitsprobleme achten?

Der Kampf zwischen Ilya-Altman

Wenn die Zeitlinie verlängert wird, ist der heutige Fall von heute eine Fortsetzung des Kampfes zwischen Openais „Palace Fight“ Ilya-Altman.

Im November letzten Jahres, als Ilya noch dort war, arbeitete er mit dem OpenAI -Verwaltungsrat zusammen, um zu versuchen, Ultraman zu entlassen.

Der zu dieser Zeit angegebene Grund war, dass er in der Kommunikation nicht aufrichtig genug war.Mit anderen Worten, wir vertrauen ihm nicht.

Das Endergebnis ist jedoch offensichtlich.Ilya verlässt das Brett.Ultraman hingegen wählte Mitglieder aus, die für ihn vorteilhafter waren, um sich dem Verwaltungsrat anzuschließen.

Danach verschwand Ilya erneut von der sozialen Plattform, bis sie vor einigen Tagen ihren Rücktritt offiziell ankündigte.Und es wird gesagt, dass es seit ungefähr 6 Monaten nicht mehr im Büro in OpenAI aufgetreten ist.

Zu dieser Zeit hinterließ er einen faszinierenden Tweet, aber er wurde schnell gelöscht.

Ich habe im letzten Monat viele Lektionen gelernt.Eine der Lektionen ist, dass der Ausdruck „Schlagen fortgesetzt wird, bis sich die Moral verbessert“ häufiger als er sollte.

Nach Ansicht von Insidern, jedochIlya hat das Super-Ausrichtungsteam aus der Ferne mitgeleitet.

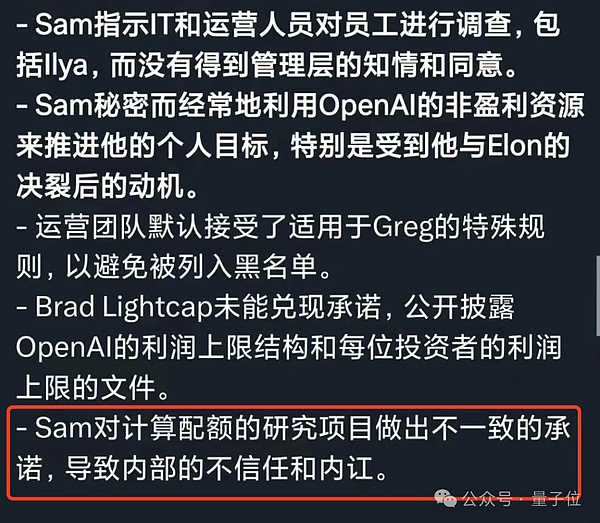

Auf Ultramans Seite war der größte Vorwurf der Mitarbeiter von ihm, dass er beispielsweise mit Worten und Taten einverstanden war.

Abgesehen von den ursprünglich versprochenen Rechenressourcen werden nicht angegeben.Es gibt auch Menschen, die Saudi -Arabien und andere gebeten haben, vor einiger Zeit Spenden für den Bau von Kernen zu sammeln.

Diese sicherheitsorientierten Mitarbeiter waren verwirrt.

Wenn er sich wirklich darum kümmert, künstliche Intelligenz so sicher wie möglich zu bauen und einsetzen, würde er dann nicht so verzweifelt Chips ansammeln, um die Entwicklung von Technologie zu beschleunigen?

Zuvor bestellte Openai auch Chips von einem von Ultraman investierten Startup.Der Betrag beträgt bis zu 51 Millionen US -Dollar (ungefähr 360 Mio. RMB).

In dem Berichtsbrief ehemaliger OpenAI -Mitarbeiter während des Palastkampfs schien die Beschreibung von Ultraman erneut bestätigt zu werden.

Das ist deshalbVon Anfang bis Ende „verschiedene Wörter und Taten“Der Betrieb hat nach und nach das Vertrauen in Openai und Ultraman verloren.

Ilya ist so, Jan Laike ist so, ebenso wie das Super -Align -Team.

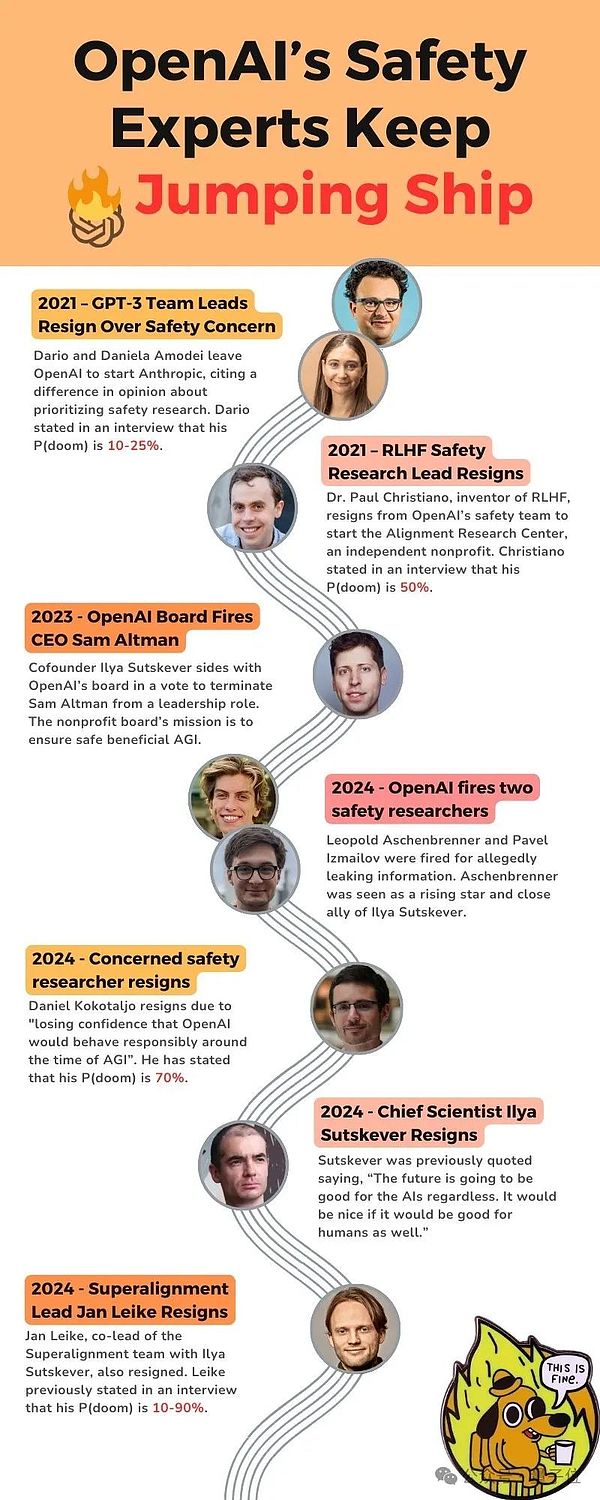

Einige rücksichtsvolle Internetnutzer haben wichtige Knoten mit verwandten Dingen, die in den letzten Jahren passiert sindP (Doom)bezieht sich auf die „Möglichkeit, KI ein Doomsday -Szenario auszulösen“.

Im Jahr 2021 verließ der Leiter des GPT-3-Teams aufgrund von „Sicherheitsgütern“ Openai und gründete anthropisch;

Im Jahr 2021 trat der Leiter der RLHF -Sicherheitsforschung zurück, wobei P (Doom) 50%betrug;

Im Jahr 2023 feuerte Openai’s Board of Directors Ultraman ab.

Im Jahr 2024 entließ Openai zwei Sicherheitsforscher;

Im Jahr 2024 ist ein OpenAI -Forscher, der besonders besorgt über Sicherheit ist, und glaubt, dass P (Doom) bereits bei 70%liegt.

Im Jahr 2024 traten Ilya und Jan Laike zurück.

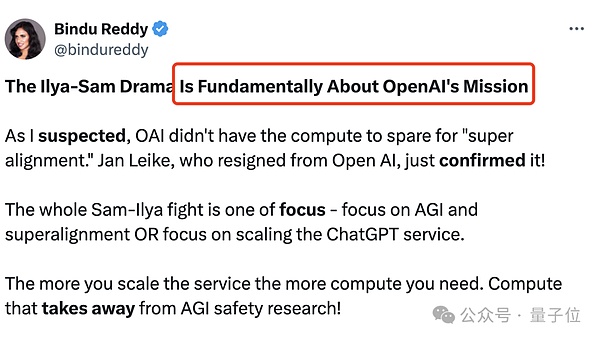

Technischer oder Markt?

Seit der Entwicklung des großen Modells kann „Wie man Agi implementiert?“

Technische SchuleIch hoffe, dass die Technologie reif und kontrollierbar und dann angewendet werden kann.MarktEs wird angenommen, dass die Anwendung von „allmählichen“ Ansätzen beim Öffnen das Ende erreicht hat.

Dies ist auch der grundlegende Unterschied zwischen dem Ilya-Altman-Streit, nämlich der Mission von OpenAI:

Konzentrieren Sie sich auf AGI und Super -Ausrichtung oder konzentrieren Sie sich auf die Erweiterung von ChatGPT -Diensten?

Je größer der Chatgpt -Service ist, desto größer ist die erforderliche Berechnung.

Wenn Openai eine gemeinnützige Organisation ist, die sich der Forschung widmet, sollten sie mehr Zeit für die Superausrichtung verbringen.

Nach einigen externen Maßnahmen durch OpenAI zu urteilen, ist das Ergebnis offensichtlich nicht.Sie wollen nur die Führung im großen Modellwettbewerb übernehmen und Unternehmen und Verbrauchern mehr Dienste anbieten.

Nach Ilyas Meinung ist dies eine sehr gefährliche Sache.Auch wenn wir nicht wissen, was passieren wird, wenn die Skala wächst,Nach Ilyas Meinung ist es am besten, zuerst sicher zu sein.

Offen und transparent, damit wir Menschen sicherstellen können, dass Agi sicher gebaut wird, nicht in gewisser Weise.

Aber unter Ultramans Führung scheint Openai weder Open Source noch Super -Ausrichtung zu verfolgen.Stattdessen ging es darum, auf die AGI zu rennen, während er versuchte, einen Wassergraben zu bauen.

Am Ende war die Wahl der KI -Wissenschaftlerin Ilya korrekt oder könnte Ultraman, ein Geschäftsmann von Silicon Valley, bis zum Ende gehen?

Es gibt keine Möglichkeit, jetzt zu wissen.Aber zumindest ist Openai jetzt vor einer wichtigen Wahl.

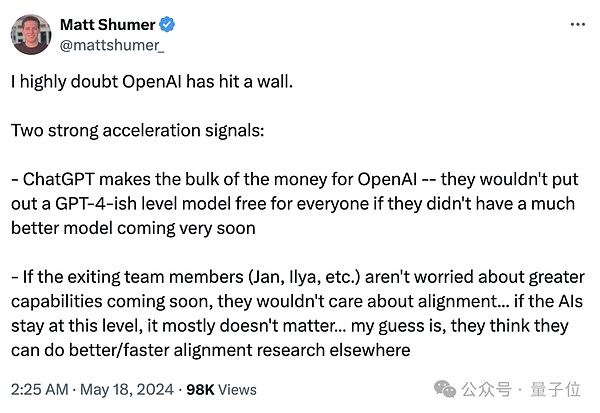

Einige Branchenkenner haben zwei wichtige Signale zusammengefasst.

einsEs ist Chatgpt, die Haupteinnahmen von OpenAI.

ein andererDas heißt, wenn die zurückgetretenen Teammitglieder (Jan, Ilya usw.) keine Sorgen über die Möglichkeit von stärkeren Merkmalen machen, werden sie sich nicht um die Ausrichtung kümmern … Wenn KI auf dieser Ebene bleibt, spielt es im Grunde keine Rolle, dass es keine Rolle spielt, dass es keine Rolle spielt, keine Rolle, dass es keine Rolle spielt, keine Rolle, dass es keine Rolle spielt, dass es keine Rolle spielt, keine Rolle spielt, spielt es keine Rolle, dass es keine Rolle spielt, dass KI im Grunde keine Rolle spielt .

Der grundlegende Widerspruch von OpenAI wurde jedoch nicht gelöst.

Die beiden Seiten sind nicht mehr unvereinbar, und die wissenschaftliche Fraktion ist vollständig aus OpenAI beseitigt, und die Außenwelt weiß immer noch nicht, wo GPT erreicht hat?

Die Leute, die die Antwort auf diese Frage kennen wollten, waren ein wenig müde.

Ein Gefühl der Ohnmacht stürmte in meinem Herzen, als Hinton, der Lehrer von Ilya und einer der drei Turing Awards, sagte:

Ich bin alt und mache mir Sorgen, aber ich kann nichts dagegen tun.

Referenzlink:

[1] https://www.vox.com/future-perfect/2024/5/17/24158403/openai-ressignations-ai-safety-yly-sutskever-jan-le-leike-telliNence

[2] https://x.com/janleke/status/1791498174659715494

[3] https://twitter.com/sama/status/1791543264090472660