¡Envía 13 tweets seguidos!

Líder de Super Alineación de OperaiJan Leike, es decir, el que acaba de seguir a Ilya para abandonar la compañía, reveló la verdadera razón de su renuncia y más información privilegiada.

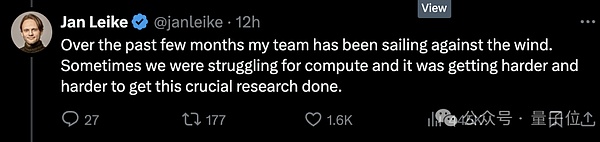

En primer lugar, no hay suficiente potencia informática, prometiendo darle a un equipo súper alineado una escasez del 20%, lo que hace que el equipo vaya en contra de la corriente, pero se está volviendo cada vez más difícil.

En segundo lugar, la seguridad no se toma en serio, la prioridad de los problemas de gobernanza de seguridad de AGI no es tan buena como lanzar un «producto brillante».

Inmediatamente después, otros excavaron más chismes.

Por ejemplo, todos los miembros de OpenAI tienen que firmar un acuerdo.Asegúrese de no decir cosas malas sobre Operai después de dejar su trabajo, si no firma, se considerará que renuncia automáticamente a las acciones de la compañía.

Pero todavía hay huesos duros que se niegan a firmar y apagar noticias pesadas (riéndose), diciendo que el liderazgo central se ha dividido durante mucho tiempo sobre las prioridades de los problemas de seguridad.

Desde la batalla del palacio el año pasado, el conflicto entre las dos facciones ha alcanzado el punto crítico, y luego parece colapsar con bastante decisión.

Por lo tanto, aunque Ultraman ha enviado a los cofundadores para hacerse cargo del equipo de súper alineación, todavía no es favorecido por el mundo exterior.

Los internautas de Twitter que estaban en la línea del frente agradecieron a Jan por tener el coraje de hablar este increíble melón y suspiraron:

¡Solo lo recogeré, parece que OpenAi realmente no presta mucha atención a esta seguridad!

Pero mirando hacia atrás, Ultraman, que ahora está a cargo de Operai, aún puede quedarse quieto por el momento.

Se puso de pie para agradecer a Jan por su contribución a la súper alineación y seguridad de Openii, y dijo que en realidad estaba muy triste y reacio a irse.

Por supuesto, el punto es en realidad esta oración:

Espera, publicaré un tweet más largo en dos días.

La potencia informática prometida del 20% en realidad tiene los ingredientes de pintar grandes pasteles

Desde la batalla del Palacio Operai el año pasado hasta el presente, la figura del alma y el ex jefe científico Ilya casi nunca han hecho apariciones públicas o han hecho voces públicas.

Antes de que él afirmara públicamente renunciar, había muchas opiniones diferentes.Muchas personas piensan que Ilya ha visto algunas cosas terribles, como el sistema AI que puede destruir a los humanos.

△ Netizen: Lo primero que hago todos los días cuando me despierto es pensar en lo que Ilya ve

Esta vez, Jan estaba fuera de la nada, y la razón principal era que los niveles prioritarios de los partidos técnicos y la seguridad del mercado tenían opiniones diferentes.

Las diferencias son muy graves, y las consecuencias son actualmente … Todos las han visto también.

Según Vox, una fuente familiarizada con OpenAi reveló queLos empleados que se centran más en la seguridad han perdido la confianza en Ultraman, «Este es un proceso de colapso de confianza poco a poco».

Pero como puede ver, en plataformas y ocasiones públicas, no muchos empleados están dispuestos a hablar públicamente sobre este asunto.

Parte de la razón es que Operai siempre ha sidoLa tradición de que los empleados firmen un acuerdo de renuncia con los acuerdos de no depresión.Si se niega a firmar, significa que ha renunciado a la opción OpenAI que ha obtenido antes.Esto significa que los empleados que salen a hablar pueden perder una gran suma de dinero.

Sin embargo, el dominó todavía cayó uno por uno

La renuncia de Ilya ha intensificado la reciente ola de renuncia de Openai.

El anuncio de su renuncia fue seguido por al menos cinco miembros del equipo de seguridad, a excepción de Jan, el jefe del equipo de súper alineación.

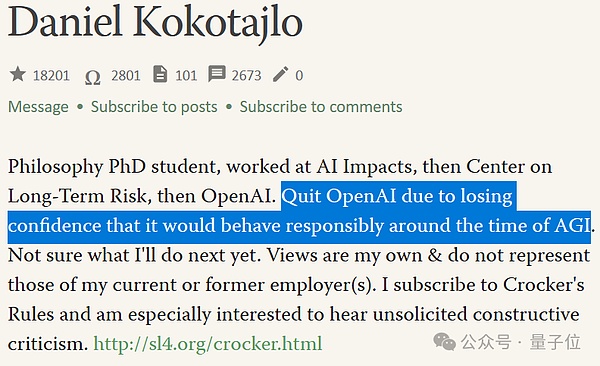

Entre ellos, hay otro hueso duro que no ha firmado un acuerdo de no depreciación, Daniel Kokotajlo (en adelante, el hermano DK).

△ El año pasado, DK escribió que cree que la posibilidad de desastre de supervivencia en IA es del 70%

El hermano DK se unió a Openai en 2022 y trabajó en el equipo de gobierno.

Pero también renunció recientemente y fue entrevistado:

Operai está entrenando sistemas de IA más poderosos con el objetivo de superar la inteligencia humana.

Esto puede ser lo mejor que le ha sucedido a la humanidad, pero puede ser lo peor si actuamos accidentalmente.

El hermano DK explicó que cuando se unió a Openai, estaba lleno de venganza y esperanza de gobernanza de seguridad, y esperaba que el Operai más cercano fuera para Agi, más responsable podría ser.Pero en el equipoMucha gentePoco a poco me di cuenta de que Operai no será así.

«Poco a poco perdí la confianza en el liderazgo de OpenAo y su capacidad para manejar AGI responsable». Es por eso que el hermano DK renunció.

La decepción con el futuro trabajo de seguridad AGI es parte de la razón por la cual todos se fueron en la intensificada ola de salidas por Ilya.

Otra parte de la razón esEl equipo súper alineado probablemente no sea tan capaz de realizar investigaciones con abundantes recursos como se imagina el mundo exterior.

Incluso si el equipo súper alineado funciona a plena capacidad, el equipo solo puede obtener el 20% de la potencia informática prometida por OpenAI.

Y a menudo se les niega algunas solicitudes del equipo.

Por supuesto, es porque los recursos informáticos son extremadamente importantes para las empresas de IA, y cada punto debe asignarse razonablemente;

En otras palabras, el equipo de súper alineación corresponde a los problemas de seguridad futuros que Operai necesita enfrentar: los puntos clave están en el futuro y no sé si aparecerá.

Al momento de la publicación, Ultraman no ha lanzado su «Tweet más largo (que la información privilegiada de Jan)».

Pero mencionó brevemente que las preocupaciones de Jan sobre los problemas de seguridad son correctas.«Tenemos mucho que hacer;

En este sentido, todos pueden establecer primero un pequeño taburete, así que comamos los melones juntos lo antes posible.

En resumen, el equipo súper alineado ha dejado a muchas personas, especialmente la renuncia de Ilya y Jan, lo que ha puesto a este equipo en la tormenta en una situación difícil de estar en un líder.

El acuerdo de seguimiento esEl cofundador John Schulma se hace cargo, pero ya no hay un equipo dedicado.

El nuevo equipo de súper alineación será el equipo conectado a más flexible con miembros repartidos en los diversos departamentos de la compañía, un portavoz de OpenAI lo describió como «más integración».

Esto también es cuestionado por el mundo exterior, porqueEl trabajo original de tiempo completo de John era garantizar la seguridad de los productos actuales de Operai.

Me pregunto si John puede estar ocupado después de tener más responsabilidades y liderar a los dos equipos que prestan atención a los problemas de seguridad presentes y futuros.

La batalla entre ILya-Altman

Si la línea de tiempo se alarga, la caída de hoy en día es en realidad una secuela de la batalla entre la «pelea de palacio» de OpenAi Ilya-Altman.

En noviembre del año pasado, cuando Ilya todavía estaba allí, trabajó con la junta directiva de Operai para tratar de despedir a Ultraman.

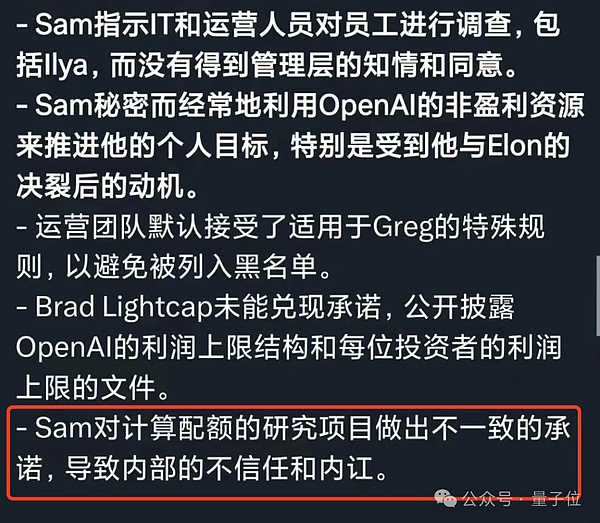

La razón dada en ese momento era que no era lo suficientemente sincero en la comunicación.En otras palabras, no confiamos en él.

Pero el resultado final es obvio.Ilya deja el tablero.Ultraman, por otro lado, eligió a los miembros que eran más beneficiosos con él para unirse a la junta directiva.

Después de eso, Ilya desapareció nuevamente de la plataforma social hasta que anunció oficialmente su renuncia hace unos días.Y se dice que no ha aparecido en la oficina de Operai durante unos 6 meses.

Dejó un tweet intrigante en ese momento, pero se eliminó rápidamente.

He aprendido muchas lecciones durante el mes pasado.Una de las lecciones es que la frase «la paliza continuará hasta que mejore la moral» se aplica con más frecuencia de lo que debería.

Sin embargo, según los expertos,Ilya ha sido co-líder del equipo de súper alineación de forma remota.

Por el lado de Ultraman, la mayor acusación de los empleados de él era que estaba en desacuerdo con palabras y hechos.

Excepto por los recursos informáticos prometidos originalmente no se dan.También hay algunas preguntas como pedirle a Arabia Saudita y a otros que recauden fondos para construir núcleos hace un tiempo.

Esos empleados orientados a la seguridad estaban confundidos.

Si realmente le importa construir y desplegar inteligencia artificial de una manera que sea lo más segura posible, ¿no acumularía los chips tan frenéticamente para acelerar el desarrollo de la tecnología?

Anteriormente, Operai también ordenó chips de una startup invertida por Ultraman.La cantidad es tan alta como US $ 51 millones (aproximadamente RMB 360 millones).

En la carta del informe de los ex empleados de Operai durante la lucha del palacio, la descripción de Ultraman parecía ser confirmada nuevamente.

Es precisamente por estoDe principio a fin, «diferentes palabras y hechos»La operación ha perdido gradualmente la confianza en Openai y Ultraman.

Ilya es así, Jan Laike es así, y también el equipo de Super Align.

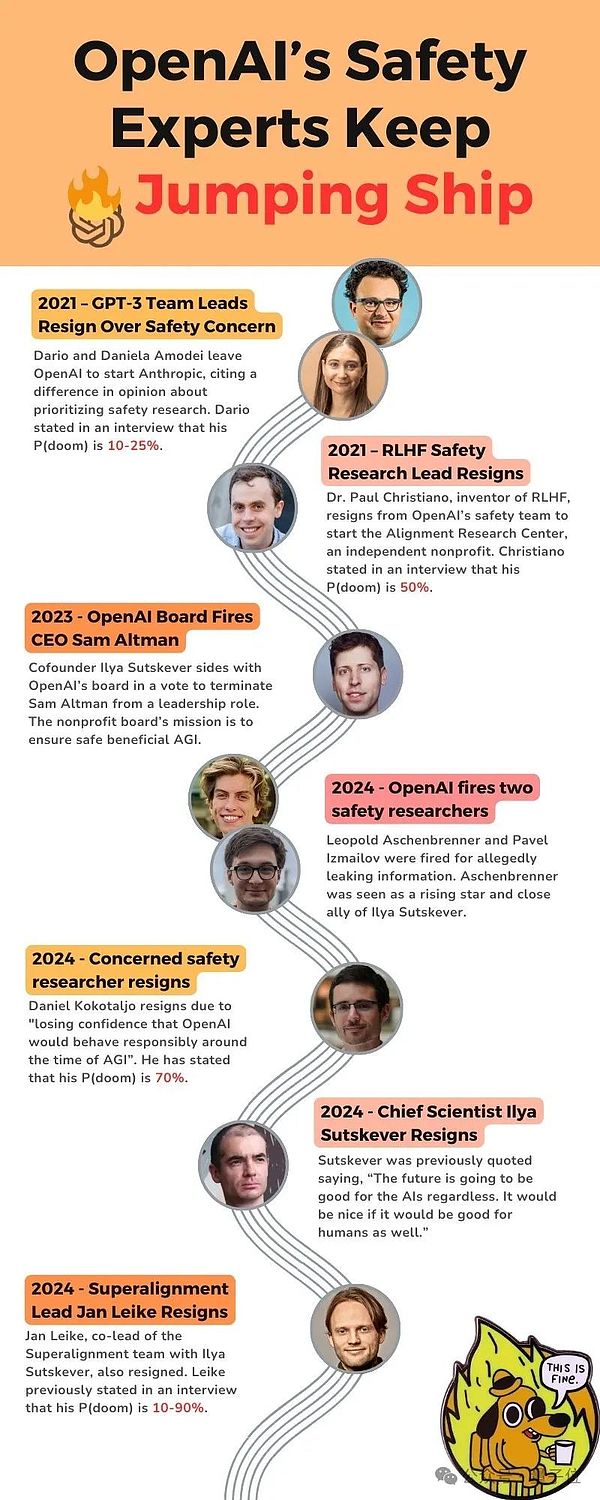

Algunos internautas considerados han resuelto nodos importantes de cosas relacionadas que han sucedido en los últimos años; primero dan un recordatorio reflexivo, como se menciona a continuaciónP (Doom), se refiere a la «posibilidad de que AI desencadene un escenario del día del juicio final».

En 2021, el jefe del equipo GPT-3 dejó OpenAi debido a problemas de «seguridad» y fundó Anthrope;

En 2021, el jefe de RLHF Security Research renunció, con P (DOOM) del 50%;

En 2023, la junta directiva de OpenAI disparó Ultraman;

En 2024, Openai despidió a dos investigadores de seguridad;

En 2024, un investigador de OpenAI que está particularmente preocupado por la seguridad que se queda, y cree que P (DOOM) ya está al 70%.

En 2024, Ilya y Jan Laike renunciaron.

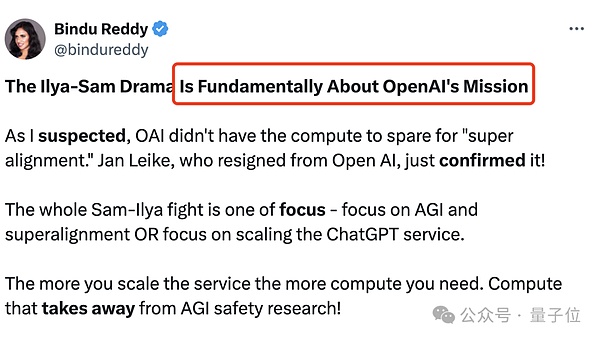

Técnico o mercado?

Desde el desarrollo del gran modelo, «¿Cómo implementar AGI?»

Escuela técnicaEspero que la tecnología pueda ser madura y controlable y luego aplicar;MercadoSe cree que mientras se abre, la aplicación de enfoques «graduales» ha llegado al final.

Esta es también la diferencia fundamental entre la disputa Ilya-Altman, a saber, la misión de OpenAi:

¿Centrarse en AGI y una súper alineación, o concéntrese en extender los servicios de CHATGPT?

Cuanto más grande sea el servicio CHATGPT, mayor es la cantidad de cálculo requerida;

Si Operai es una organización sin fines de lucro dedicada a la investigación, deberían pasar más tiempo en súper alineación.

A juzgar por algunas medidas externas por OpenAI, el resultado obviamente no lo es.Solo quieren tomar la delantera en la competencia de modelos grandes y proporcionar más servicios a las empresas y consumidores..

En opinión de Ilya, esto es algo muy peligroso.Incluso si no sabemos qué sucederá a medida que crezca la escala,En opinión de Ilya, la mejor manera es estar a salvo primero.

Abierto y transparente para que los humanos podamos asegurar que AGI se construya de manera segura, no de alguna manera secreta.

Pero bajo el liderazgo de Ultraman, OpenAi no parece perseguir ni código abierto ni súper alineación.En cambio, se trataba de correr hacia el AGI mientras intentaba construir un foso.

Entonces, al final, la elección del científico de IA Ilya era correcta, ¿o Ultraman, un empresario de Silicon Valley, podría ir al final?

No hay forma de saberlo ahora.Pero al menos Openai se enfrenta a una opción clave ahora.

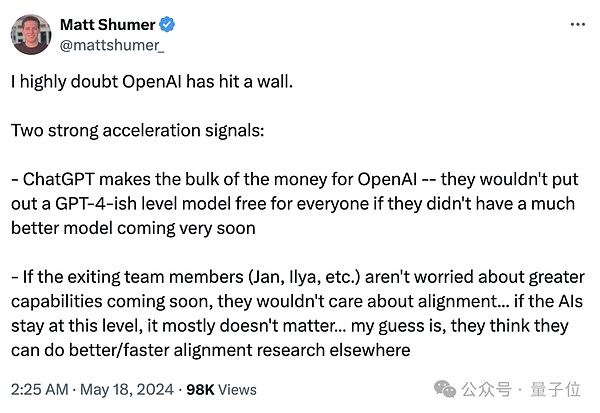

Algunos expertos de la industria han resumido dos señales clave.

unoEs ChatGPT, los principales ingresos de OpenAI.

otroEs decir, si los miembros del equipo renunciados (Jan, Ilya, etc.) no están preocupados por la posibilidad de características más poderosas pronto, no les importará la alineación … Si la IA permanece en este nivel, básicamente no importa .

Pero la contradicción fundamental de OpenAi no se ha resuelto.

Las dos partes ya no son irreconciliables, y la facción científica se elimina por completo de OpenAi, y el mundo exterior todavía no sabe a dónde ha llegado GPT.

Las personas que estaban ansiosas por saber la respuesta a esta pregunta estaban un poco cansadas.

Dijo una sensación de impotencia en mi corazón, como dijo Hinton, el maestro de Ilya y uno de los tres premios Turing:

Soy viejo y estoy preocupado, pero no puedo hacer nada al respecto.

Enlace de referencia:

[1] https://www.vox.com/future-perfect/2024/5/17/24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-intiLigence-inteligence

[2] https://x.com/janleike/status/1791498174659715494

[3] https://twitter.com/sama/status/1791543264090472660