Source: Informations sur les informations

Avant-propos

Depin + Ai + Sol Ecology = 2024 Wang Fried Combination.

IO.NET DISSEMPLIGNEMENT

On ne sait pas si 2024 inaugurera l’été de l’IA, mais il est certain que le récit de l’AIXCrypto deviendra plus clair.

En plus du projet d’IA qui a été considéré par Meme récemment, il y a des joueurs solides tels que le Bittersor, le rendu, Arkham, etc. sur le marché, comme le Bittersor, le rendu, Arkham, etc.

■ INTRODUCTION IO.NET

IO.NET est un réseau informatique décentralisé qui prend en charge le développement, l’exécution et l’expansion des applications ML sur la blockchain Solana, combinant 1 million de GPUS pour former le plus grand cluster GPU au monde et les GPU d’agrégation depin.io.net à partir des GPU de ressources non précédentes des ressources non précédentes (Comme des centres de données indépendants, des mineurs cryptés et des projets cryptés tels que FileCoin, rendu) pour résoudre ce problème. Beaucoup de capacités informatiques dans les systèmes qui accèdent, personnalisés, économiques et efficaces et faciles à mettre en œuvre.

IO.NET est un exemple classique de Depin: utilisez le mécanisme d’incitation au jeton pour réduire le coût d’acquisition et de conservation des ressources du fournisseur de la structure et, finalement, et finalement de réduire le coût des consommateurs terminaux.Le réseau rassemble d’énormes GPU hétérogènes dans un pool partagé pour les développeurs et les entreprises de l’intelligence artificielle.Aujourd’hui, le réseau est soutenu par des milliers de GPU des centres de données, des stations d’exploitation minière et des appareils de consommation.

+ Formation AWS décentralisée pour ML (apprentissage automatique) sur GPU

+ Instantané, pas besoin d’accéder à un réseau GPU et CPU mondial, il a été en ligne

+ Ils ont 25 000 nœuds

+ Technologie révolutionnaire, vous pouvez rassembler GPU ensemble

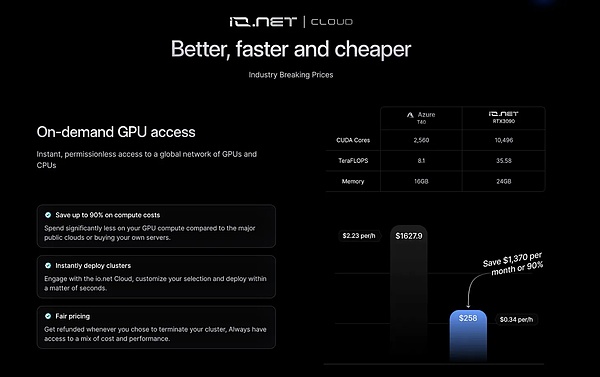

+ Peut économiser 90% du coût de calcul pour les startups AI à grande échelle

+ Rendu intégré et filecoin

+ Basé sur Solana

■ Agence io.net

■ Revue brève du projet

IO.NET est un réseau informatique décentralisé avancé, offrant aux ingénieurs d’apprentissage automatique un coût relativement faible d’accès aux rassemblements distribués à un coût relativement faible.Le lancement de cette plate-forme offre aux utilisateurs plus de choix afin qu’ils puissent calculer et le traitement des données de manière plus économique et efficace.

+ Les fonctions principales de la plate-forme comprennent

1. Réseau informatique de décentralisation: IO.NET utilise un mode informatique décentralisé pour distribuer des ressources informatiques dans le monde, améliorant ainsi l’efficacité et la stabilité du calcul.

2. Accès à faible coût: Par rapport aux services centralisés traditionnels, IO.NET Cloud fournit des coûts d’accès plus faibles, permettant à plus d’ingénieurs et de chercheurs d’apprentissage automatique pour obtenir des ressources informatiques.

3. Groupe de rassemblement distribué: La plate-forme fournit un cluster de rassemblement distribué.

4. Prise en charge des tâches d’apprentissage automatique: IO.NET Cloud se concentre sur la fourniture de ressources informatiques pour les ingénieurs d’apprentissage automatique, leur permettant de faciliter les tâches telles que la formation des modèles et le traitement des données.

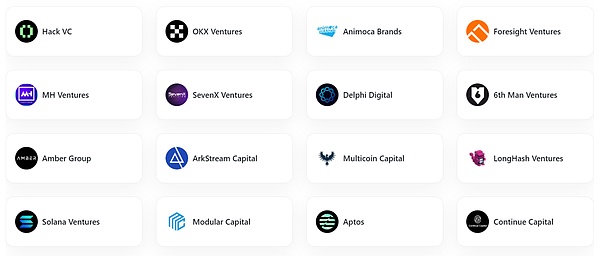

+ La force de l’institution est forte

Avec de nombreuses institutions principales qui participent, il y a aussi des leaders bien connus de l’industrie qui ont participé au Rongzi, notamment le fondateur de Solana, Anatoly Yakovenk, le fondateur d’Aptos Mo Shaikh et Avery Ching et le Yat Siu de Sandbox et Perlone d’Animoca, Sebastine B Orget et Perlone Animoca Jin Kang de Capital.

+ En termes de valeur zi

L’émergence de io.net comble l’écart dans le domaine de la décentralisation et du calcul, offrant aux utilisateurs une méthode de calcul nouvelle et potentielle.Avec le développement continu de l’intelligence artificielle et de l’apprentissage automatique, la demande de ressources informatiques augmente également, donc IO.NET a un potentiel et une valeur de marché élevés.

Dans l’ensemble, IO.NET résout ce problème en agrégeant les GPU de la source non utile (tels que des centres de données indépendants, des mineurs chiffrés et des projets cryptés tels que Filecoin, Render et d’autres projets de chiffrement.Ces ressources sont combinées dans le réseau d’infrastructure physique décentralisé (DEPIN), afin que les ingénieurs puissent obtenir de nombreuses capacités informatiques dans des systèmes accessibles, personnalisés, économiques et efficaces et faciles à mettre en œuvre.

■ io.net a l’intention de lancer le plan de récompense des points le 1er mars, et il est prévu que les jetons IO seront lancés fin avril

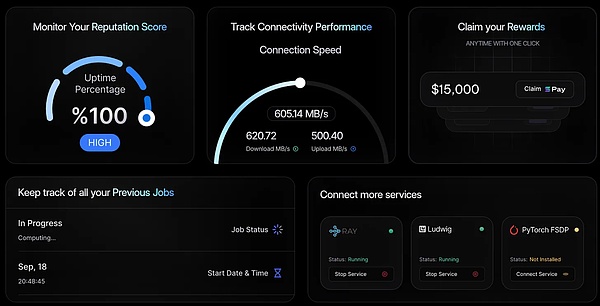

IO.NET commencera la première phase du plan de récompense des points le 1er mars.Le plan est appelé allumage, qui durera jusqu’au 28 avril.Le plan récompensera les points en fonction du GPU fourni par les utilisateurs au réseau.

Lorsqu’on lui a demandé si les points de récompense seraient convertis en monnaie native IO.NET IO, le fondateur et PDG d’IO.NET, Ahmad Shadid, a refusé de commenter, mais il a déclaré que le jeton devrait être lancé le 28 avril.

IO.NET a déclaré que le prochain programme de prix d’allumage est la première étape de la décentralisation et du transfert de gouvernance IO.NET à la communauté.

# ie.net windows tutoriel

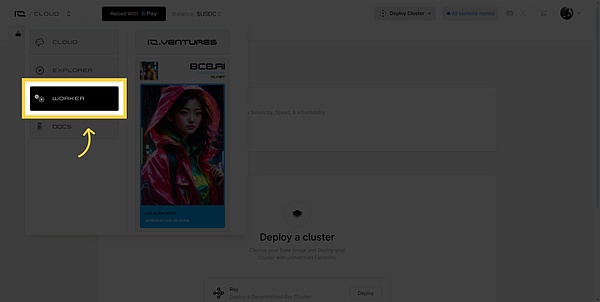

Aller d’abord sur cloud.io.net

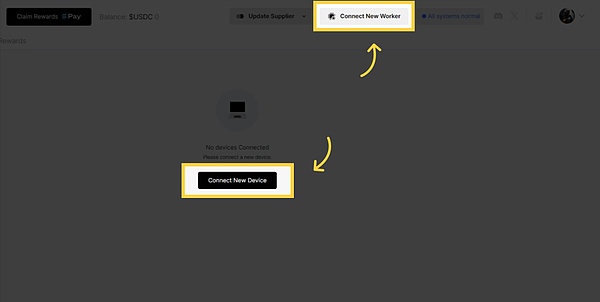

1. Navigation du menu Drop -Down au travailleur

Cliquez sur « Connectez-vous à un nouvel appareil »

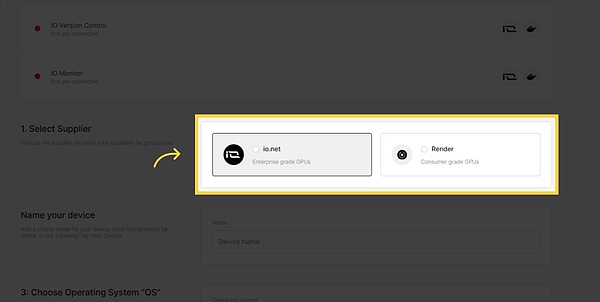

Choisissez le fournisseur que vous souhaitez regrouper du matériel

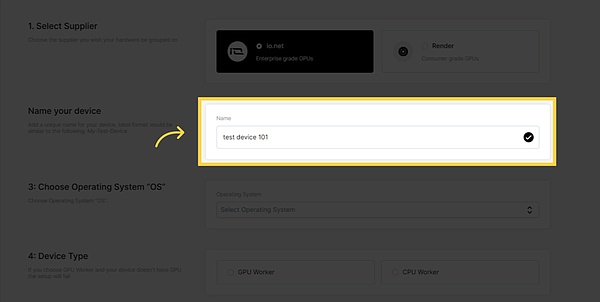

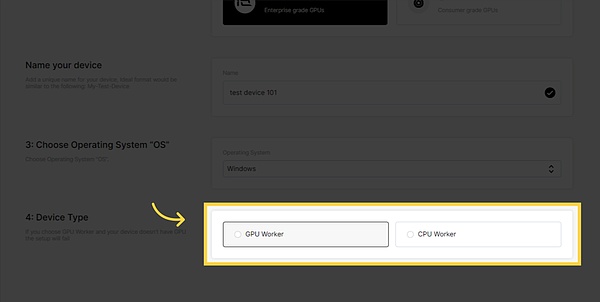

Ajoutez le nom unique à votre appareil, le format idéal est similaire à ce qui suit: My-Test-Device

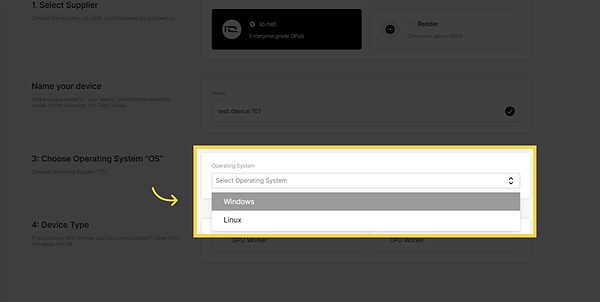

Cliquez sur le champ « Windows »

Si vous choisissez un travailleur GPU et que votre appareil n’a pas de GPU, le paramètre échouera

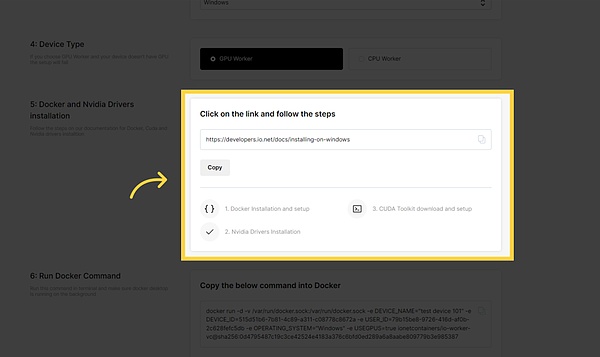

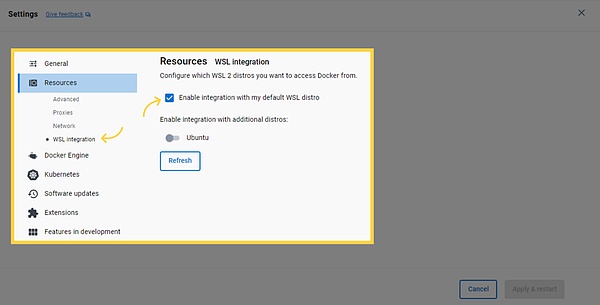

Opérez selon nos pilotes Docker, Cuda et Nvidia.

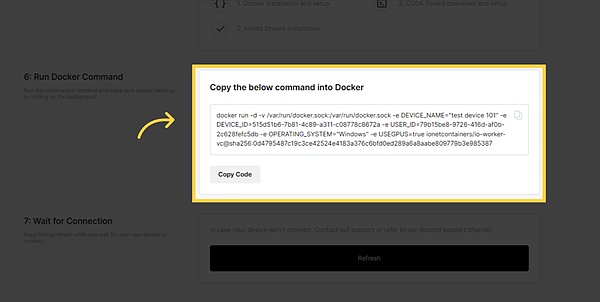

Exécutez cette commande dans le terminal et assurez-vous que le bureau Docker s’exécute en arrière-plan

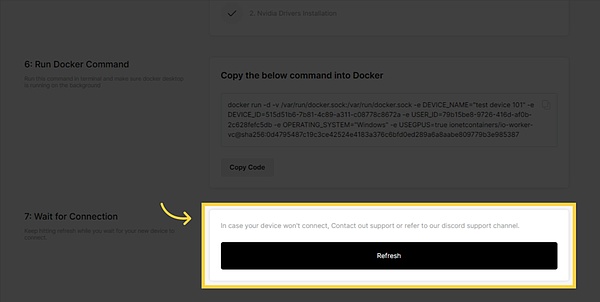

Lorsque vous attendez que le nouvel appareil se connecte, continuez à actualiser.

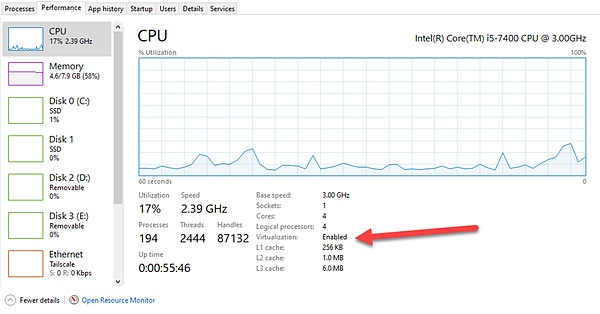

Tout d’abord, vous devez activer le BIOS de virtualisation.

Pour vérifier s’il a été activé, veuillez transférer aux performances du gestionnaire de tâches afin que vous puissiez voir ici:

Pour activer la technologie de virtualisation dans les paramètres du BIOS ou de l’UEFI, vous devez accéder au menu de configuration du BIOS ou UEFI de l’ordinateur pendant le processus de démarrage.Les étapes spécifiques peuvent être différentes, selon le fabricant et le modèle de l’ordinateur, mais ce qui suit est l’étape générale de l’activation de la virtualisation.

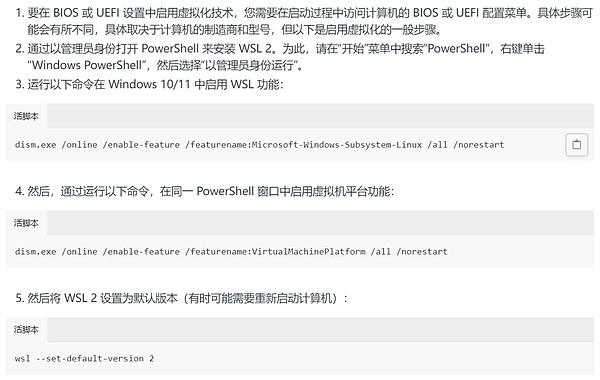

Installez WSL 2 en ouvrant PowerShell en tant qu’administrateur.Pour cette raison, veuillez rechercher « PowerShell » dans le menu « Démarrer », à droite -click « Windows PowerShell », puis sélectionnez « Exécuter en tant qu’administrateur ».

Exécutez les commandes suivantes dans Windows 10/11 pour activer la fonction WSL:

Visitez le site Web de Docker: https://www.docker.com/products/docker-desktop/ et cliquez sur « Télécharger pour Windows »:

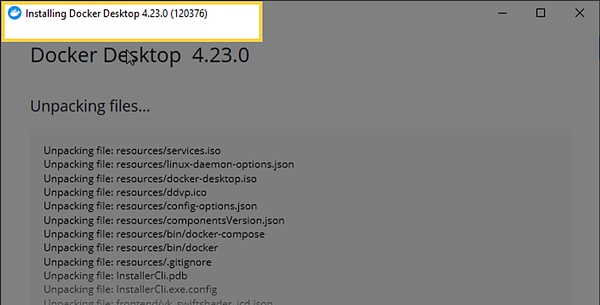

Version Docker

Ensuite, vous recevrez la sortie suivante:

Docker Version 24.0.6, construire ED223BC

C’est ça.Vous avez installé et préparé Docker.

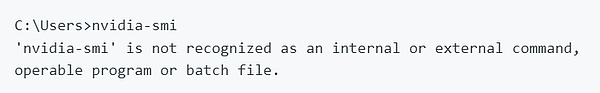

Installez le pilote Nvidia sur Windows

Pour vérifier si vous avez le bon pilote, ouvrez la ligne de commande (clé Windows + R, tapez CMD) sur PC Windows et entrez les éléments suivants: NVIDIA-SMI.Si vous rencontrez les informations d’erreur suivantes:

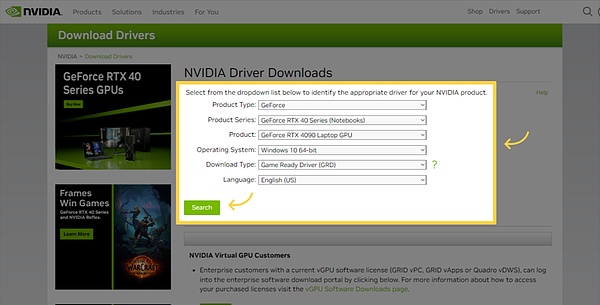

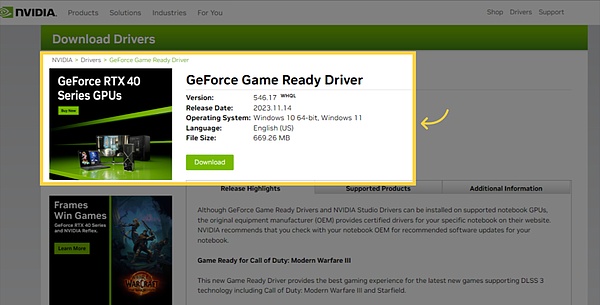

Visitez le site Web de Nvidia https://www.nvidia.com/download/index.aspx et entrez votre nom GPU, puis cliquez sur la recherche:

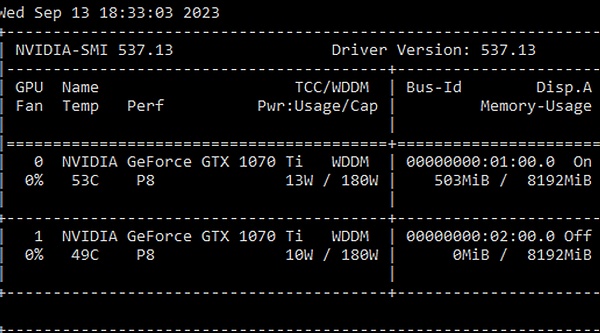

Une fois l’ordinateur redémarré, ouvrez l’invite de commande (clé Windows + R, tapez CMD) et saisissez la commande suivante:

nvidia-SMI

Vous devriez voir ce résultat:

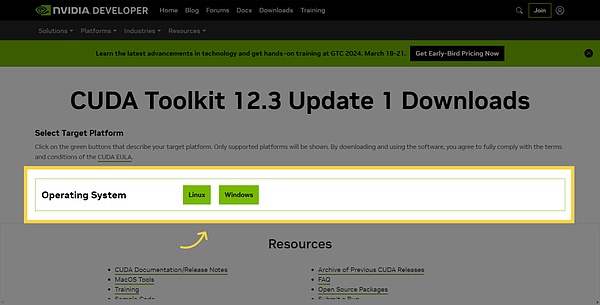

Télécharger le pack d’outils CUDA (facultatif)

Visitez la page de téléchargement de Nvidia Cuda Tool Pack: https://developer.nvidia.com/cuda-downloads

Sélectionnez votre architecture (pour 64 bit Windows, généralement x86_64).

Téléchargez le programme d’installation locale EXE.Après avoir téléchargé le fichier, exécutez le programme d’installation:

Ensuite, vérifiez le processus d’installation.Ouvrez l’invite de commande (clé Windows + R, tapez CMD) et saisissez la commande suivante:

Version NVCC

Vous devriez obtenir les réponses suivantes:

NVCC: NVIDIA (R) CUDA Compiler Driver Copyright (C) 2005-2022 Nvidia Corporation construite sur merde_sep_21_10: 10_pacight_time_2022 CUDA Compilati sur les outils, version 11.8, V11.8.89 Cuda_11.8 / Compiler.31833905_0_0

C’est ça.Vous avez installé et préparé la boîte à outils CUDA.

Récompense minière du GPU: Fournir un revenu GPU + Airdrop RNDR

■ Réponse de question

1. Quelles cartes graphiques peuvent exécuter la puissance de calcul:

1, 4080 ci-dessus

2. Mac M1 M2 M3, etc. (CPU est utilisé);

3. Tutoriel Ubuntu: https://developers.io.net/docs/installing- on- Ubuntu

4. Tutoriel Mac-In: https://developers.io.net/docs/installing- on-mac-in

Deuxièmement, les problèmes de location de puissance de calcul:

1. En fonction de votre taux de réseau / modèle GPU / Santé par ordinateur (essayez de ne pas exécuter de jeux ou de grands logiciels pendant la période) / Computing Power Exigences, etc.;

2. Différents modèles GPU ont un loyer différent;

3. Arrêt de l’équipement pendant la période de location, un petit loyer sera déduit;

4. IP domestique est rejetée et ne peut pas être enregistrée / loyer (suggérant VPN Global)

3. À propos du travailleur ne peut pas se connecter:

1. Docker en cours d’exécution (2 conteneurs), vous devez attendre 1 à 20 minutes (la rafraîchissement n’est pas efficace immédiatement)

2. Re -Connect: supprimez directement les conteneurs Docker 2, puis exécutez le sixième code lors de l’exécution du déploiement;

3. Certains Sevices sont en panne est la mise à niveau de la fête du projet, qui n’a rien à voir avec nous

4. Comment obtenir plus de récompenses

1. Complétez la tâche Galxe (besoin de terminer la certification passeport / humanité, au moins une au moins une)

2. Obtenez un niveau de rôle plus élevé / participer au programme de récompense communautaire (comme participer à l’AMA, aider à résoudre les problèmes, en utilisant la BC8, le concours de carte Meme, etc.)

3. Partagez votre puissance de calcul GPU sur le travailleur (il y a aussi une suspension vide);

4. Récompense Les bases n’ont pas encore été annoncées