المصدر: نمط الذكاء الاصطناعي

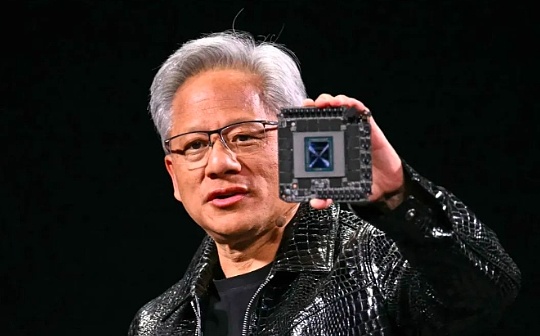

قال الرئيس التنفيذي لشركة Nvidia Jensen Huang إن أداء رقاقة AI التابع للشركة قد تحسن بشكل أسرع من قانون مور – وهو مبدأ سيطر على تطوير تكنولوجيا الحوسبة لعقود.

وقال هوانغ في مقابلة في الصباح بعد إلقاء خطاب رئيسي إلى 10000 مشاهد في مؤتمر CES في لاس فيجاس: “نظامنا يتطور بشكل أسرع بكثير من قانون مور”.

تم اقتراح قانون مور في عام 1965 من قبل المؤسس المشارك لشركة Intel Gordon Moore.من المتوقع أن يتضاعف عدد الترانزستورات على الشريحة كل عام ، وبالتالي مضاعفة أداء الرقاقة.تم تحقيق هذا التنبؤ بشكل أساسي في العقود التالية ، مما دفع إلى تحسين سريع في قوة الحوسبة وتراجع كبير في التكاليف.

على الرغم من أن زخم قانون مور قد تباطأ في السنوات الأخيرة ، إلا أن هوانغ رينكسون قال إن رقائق الذكاء الاصطناعى في NVIDIA تتطور بوتيرة أسرع.تقول الشركة إن أحدث رقائقها الفائقة في مركز البيانات هي أفضل أكثر من 30 مرة في أداء الاستدلال الذكاء الاصطناعي من الجيل السابق.

أوضح هوانغ رينكسون أنه من خلال الابتكار في وقت واحد على مستويات مختلفة مثل الهندسة المعمارية والرقائق والأنظمة ومكتبات البرامج والخوارزميات ، يمكن كسر حدود قانون مور.

قدم الرئيس التنفيذي لشركة NVIDIA هذا الادعاء الجريء في وقت تساءل فيه الكثيرون عما إذا كانت تطوير الذكاء الاصطناعي قد توقف.تستخدم مختبرات AI Top مثل Google و Openai و Anthropic كل رقائق AI من NVIDIA لتدريب وتشغيل نماذجها ، ومن المرجح أن يؤدي التحسن في أداء الرقاقة إلى المزيد من الاختراقات في قدرات الذكاء الاصطناعي.

ليست هذه هي المرة الأولى التي يظهر فيها Huang Renxun أن Nvidia يتجاوز قانون مور.وذكر في بودكاست في نوفمبر أن مجال الذكاء الاصطناعى يخضع لتطوير “قانون Supermoore”.

لقد دحض البيان القائل بأن تقدم الذكاء الاصطناعي قد تباطأ وأشار إلى أن هناك حاليًا ثلاثة قوانين لتطوير الذكاء الاصطناعي: التدريب المسبق (أنماط التعلم من البيانات الضخمة) ، وبعد التدريب (صقلها من خلال التعليقات البشرية ، وما إلى ذلك) واختبار حساب الوقت (إعطاء أكثر من “التفكير” من الذكاء الاصطناعي).

وقال هوانغ رينكسون إنه تمامًا مثل قانون مور قد شجع على تطوير تكنولوجيا الحوسبة عن طريق تقليل تكاليف الحوسبة ، فإن تحسين أداء استنتاج الذكاء الاصطناعي سيقلل أيضًا من تكاليف استخدامه.

على الرغم من أن H100 من NVIDIA كانت هي الشريحة المفضلة لشركات التكنولوجيا لتدريب نماذج الذكاء الاصطناعي ، حيث تحولت هذه الشركات إلى مرحلة الاستدلال ، بدأ البعض يتساءل عما إذا كانت رقائق NVIDIA باهظة الثمن يمكن أن تستمر في الحفاظ على مزاياها.

حاليًا ، يكون نموذج الذكاء الاصطناعي المحسوب أثناء الاختبار مكلفًا للغاية.خذ نموذج O3 من Openai على سبيل المثال ، وهو أداء على مستوى الإنسان في اختبار الذكاء العام ، ولكنه يكلف ما يقرب من 20 دولارًا لكل مهمة ، في حين أن رسوم الاشتراك ChatGPT Plus هي 20 دولارًا شهريًا.

في الكلمة الرئيسية يوم الاثنين ، قدم Huang Renxun أحدث مركز بيانات Super Center ، GB200 NVL72.حسنت هذه الشريحة أداء استنتاج الذكاء الاصطناعي بمقدار 30-40 مرة مقارنة بأفضل مبيع H100 السابق.وقال إن قفزة الأداء هذه ستقلل من تكلفة استخدام نماذج مثل Openai O3 التي تتطلب الكثير من الحوسبة الاستنتاجية.

أكد هوانغ رينكسون على أن تركيزها هو تحسين أداء الرقاقة ، لأنه على المدى الطويل ، يعني الأداء الأقوى انخفاض الأسعار.

وقال إن تحسين قوة الحوسبة هو حل مباشر لأداء وتكلفة مشاكل الحوسبة أثناء الاختبار.على المدى الطويل ، يمكن أن توفر نماذج استدلال الذكاء الاصطناعي أيضًا بيانات أفضل لكل من مراحل ما قبل التدريب وما بعد التدريب.

انخفض سعر نماذج الذكاء الاصطناعى بالفعل بشكل كبير على مدار العام الماضي بفضل حساب الاختراقات من شركات الأجهزة مثل Nvidia.على الرغم من أن نموذج الاستدلال الأخير من Openai مكلف ، إلا أن Huang Renxun يتوقع أن يستمر اتجاه خفض الأسعار هذا.

قال أيضا ،أداء رقاقة AI من NVIDIA أعلى 1000 مرة قبل 10 سنوات ، وهو ما يتجاوز بكثير سرعة تطوير قانون مور.علاوة على ذلك ، لا توجد علامة على التوقف في هذا الزخم السريع للتنمية.

<-style-type>