出典:AIスタイル

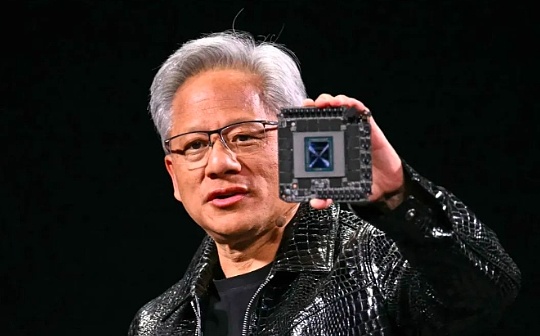

Nvidia CEOのJensen Huangは、同社のAIチップのパフォーマンスはムーアの法律よりも速く改善されたと述べました。これは、かつて数十年にわたってコンピューティングテクノロジーの開発を支配していた原則です。

「私たちのシステムはムーアの法律よりもはるかに速く発展しています」と、ハンは、ラスベガスで開催されたCES会議で10,000人の視聴者に基調講演を行った後のインタビューで語った。

ムーアの法律は、1965年にインテルの共同設立者ゴードンムーアによって提案されました。チップ上のトランジスタの数は毎年約2倍になると予測されるため、チップのパフォーマンスが2倍になります。この予測は基本的に次の数十年で実現され、コンピューティングパワーの急速な改善とコストの大幅な減少を促進しました。

ムーアの法律の勢いは近年遅くなっていますが、Huang Renxunは、NvidiaのAIチップがより速いペースで発展していると述べました。同社は、最新のデータセンターのスーパーチップは、AI推論のパフォーマンスが前世代の30倍以上優れていると述べています。

Huang Renxunは、アーキテクチャ、チップ、システム、プログラムライブラリ、アルゴリズムなどのさまざまなレベルで同時に革新することにより、ムーアの法則の制限が破られる可能性があると説明しました。

Nvidia CEOは、AIの開発が停滞しているかどうかを多くの人が疑問視したときに、この大胆な主張をしました。Google、Openai、AnthropicなどのトップAIラボはすべて、NVIDIAのAIチップを使用してモデルを訓練および実行しており、チップのパフォーマンスの改善はAI機能のさらなるブレークスルーにつながる可能性があります。

Huang RenxunがNvidiaがムーアの法律を上回ることを示したのはこれが初めてではありません。彼は11月のポッドキャストで、AIの分野は「スーパーモアの法律」開発を行っていると述べました。

彼は、AIの進捗が減速したという声明に反論し、現在AI開発の3つの法律があることを指摘しました:トレーニング前(大規模なデータからの学習パターン)、トレーニング後(人間のフィードバックによる微調整など)、テスト – 時間の計算(AIに「思考」時間を与える)。

Huang Renxunは、Mooreの法律がコンピューティングコストを削減することによりコンピューティングテクノロジーの開発を促進したように、AI推論のパフォーマンスを改善することで使用コストも削減すると述べました。

NvidiaのH100は、ハイテク企業がAIモデルをトレーニングするための選択のチップでしたが、これらの企業は推論段階に目を向けたため、Nvidiaの高価なチップが引き続き利点を維持できるかどうかを疑問視し始めました。

現在、テスト中に計算されたAIモデルは、実行するのに非常に費用がかかります。たとえば、OpenaiのO3モデルを考えてみましょう。これは、一般的なインテリジェンステストの人間レベルのパフォーマンスですが、タスクごとに20ドル近くかかりますが、ChatGPTとサブスクリプション料金は月額20ドルです。

月曜日の基調講演で、Huang Renxunは最新のデータセンターSuper Chip、GB200 NVL72を発表しました。このチップは、以前のベストセラーH100と比較して、AI推論のパフォーマンスを30〜40回改善しました。彼は、このパフォーマンスの跳躍は、多くの推論コンピューティングを必要とするOpenai O3のようなモデルを使用するコストを削減すると述べました。

Huang Renxunは、長期的にはパフォーマンスが強いと価格が低いことを意味するため、彼らの焦点はチップのパフォーマンスを改善することであると強調しました。

彼は、コンピューティングパワーを改善することは、テスト中のコンピューティングのパフォーマンスとコストの問題に対する直接的な解決策であると述べました。長期的には、AI推論モデルは、トレーニング前とトレーニング後の両方の段階の両方のより良いデータを提供することもできます。

AIモデルの価格は、Nvidiaなどのハードウェア企業からのブレークスルーを計算するために、過去1年間で実際に大幅に低下しました。Openaiの最新の推論モデルは高価ですが、Huang Renxunはこの価格削減の傾向が続くと予想しています。

彼は言った、NvidiaのAIチップパフォーマンスは10年前の1,000倍の高さであり、ムーアの法律の開発速度をはるかに超えています。さらに、この急速な発展の勢いに停止の兆候はありません。