Source: style AI

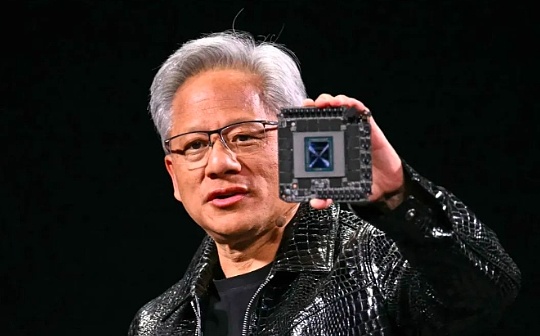

Le PDG de NVIDIA, Jensen Huang, a déclaré que les performances des puces AI de la société se sont améliorées plus rapidement que la loi de Moore – un principe qui a autrefois dominé le développement de la technologie informatique pendant des décennies.

« Notre système se développe beaucoup plus rapidement que la loi de Moore », a déclaré Huang dans une interview le matin après avoir prononcé un discours d’ouverture à 10 000 téléspectateurs lors de la conférence du CES à Las Vegas.

La loi de Moore a été proposée en 1965 par le co-fondateur d’Intel, Gordon Moore.Le nombre de transistors sur la puce devrait doubler environ chaque année, ce qui double les performances de la puce.Cette prévision a été essentiellement réalisée au cours des décennies suivantes, entraînant une augmentation rapide de la puissance de calcul et une baisse significative des coûts.

Bien que l’élan de la loi de Moore ait ralenti ces dernières années, Huang Renxun a déclaré que les puces d’IA de Nvidia se développent à un rythme plus rapide.La société affirme que son dernier centre de données Super Chips est plus de 30 fois meilleur dans les performances d’inférence de l’IA que la génération précédente.

Huang Renxun a expliqué qu’en innovant simultanément à différents niveaux tels que l’architecture, les puces, les systèmes, les bibliothèques de programmes et les algorithmes, les limites de la loi de Moore peuvent être rompues.

Le PDG de NVIDIA a fait cette affirmation audacieuse à un moment où beaucoup se sont demandé si le développement de l’IA s’était bloqué.Les meilleurs laboratoires d’IA tels que Google, OpenAI et anthropic utilisent tous les puces AI de NVIDIA pour former et gérer leurs modèles, et l’amélioration des performances des puces devrait entraîner de nouvelles percées dans les capacités d’IA.

Ce n’est pas la première fois que Huang Renxun montre que Nvidia dépasse la loi de Moore.Il a mentionné dans un podcast en novembre que le domaine de l’IA subit un développement de la « loi de Supermoore ».

Il a réfuté l’affirmation selon laquelle les progrès de l’IA ont ralenti et ont souligné qu’il existe actuellement trois lois du développement de l’IA: pré-formation (modèles d’apprentissage à partir de données massives), post-entraînement (réglage fin par la rétroaction humaine, etc.) et tester – Calcul du temps (donnant à l’IA plus de temps de «réflexion»).

Huang Renxun a déclaré que, tout comme la loi de Moore a favorisé le développement de la technologie informatique en réduisant les coûts informatiques, l’amélioration des performances d’inférence de l’IA réduira également ses coûts d’utilisation.

Alors que le H100 de NVIDIA était la puce de choix pour que les entreprises technologiques forment des modèles d’IA, alors que ces entreprises se tournaient vers la phase d’inférence, certains ont commencé à se demander si les puces coûteuses de Nvidia pouvaient continuer à maintenir leurs avantages.

Actuellement, le modèle d’IA calculé lors de l’utilisation de tests est très coûteux à exécuter.Prenez par exemple le modèle O3 d’Openai, qui est une performance au niveau de l’homme dans les tests d’intelligence générale, mais coûte près de 20 $ par tâche, tandis que les frais d’abonnement ChatGpt Plus sont de 20 $ par mois.

Dans le discours de lundi, Huang Renxun a présenté le dernier centre de données Super Chip, le GB200 NVL72.Cette puce a amélioré les performances d’inférence de l’IA de 30 à 40 fois par rapport au H100 le plus vendu précédent.Il a déclaré que ce saut de performance réduirait le coût de l’utilisation de modèles comme OpenAI O3 qui nécessitent beaucoup d’informations d’inférence.

Huang Renxun a souligné que leur objectif est d’améliorer les performances des puces, car à long terme, des performances plus fortes signifient des prix inférieurs.

Il a déclaré que l’amélioration de la puissance de calcul est une solution directe aux problèmes de performances et de coûts de l’informatique pendant les tests.À long terme, les modèles d’inférence IA peuvent également fournir de meilleures données pour les étapes pré-formation et post-formation.

Le prix des modèles d’IA a en effet considérablement baissé au cours de la dernière année grâce aux percées informatiques des sociétés matérielles telles que NVIDIA.Bien que le dernier modèle d’inférence d’Openai soit coûteux, Huang Renxun s’attend à ce que cette tendance baisse des prix se poursuive.

Il a également dit,Les performances des puces AI de Nvidia sont 1 000 fois supérieures à celle d’il y a 10 ans, ce qui est bien au-delà de la vitesse de développement de la loi de Moore.De plus, il n’y a aucun signe d’arrêt dans cette dynamique de développement rapide.