Autor: Cynic, Shigeru

Führung:Anhand der Leistung von Algorithmen, Rechenleistung und Daten definiert die Fortschritt der AI -Technologie die Grenze zwischen Datenverarbeitung und intelligenter Entscheidungsfindung.Gleichzeitig repräsentiert Depin das zentralisierte und blockchainbasierte Netzwerkparadigma auf der zentralisierten Infrastruktur.

Während sich die Welt in Richtung digitaler Transformation bewegt, sind KI und Depine (dezentrale physische Infrastruktur) zu den grundlegenden Technologien geworden, um die Reform aller Lebensbereiche zu fördern.Die Verschmelzung von KI und Depin kann nicht nur die schnelle Iteration und Anwendung von Technologie fördern, sondern auch ein sichereres, transparenteres und effizienteres Servicemodell eröffnen, um weitreichende Veränderungen in die Weltwirtschaft zu bringen.

Depin: Dezentralisierung und Mangel, die Hauptstütze der digitalen Wirtschaft

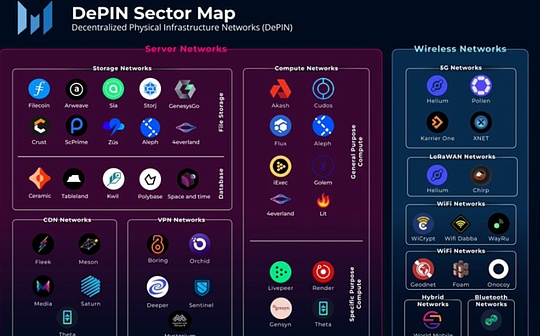

Depin ist eine Abkürzung der dezentralen physikalischen Infrastruktur.In enger Sinne bezieht sich Depin hauptsächlich auf das verteilte Netzwerk der herkömmlichen physischen Infrastruktur, die von verteilten Ledger -Technologien wie Power -Netzwerken, Kommunikationsnetzwerken und Positionierungsnetzwerken unterstützt wird.In einem breiten Sinne können alle verteilten Netzwerke, die von physischen Geräten unterstützt werden, als Depin bezeichnet werden, z. B. Speichernetzwerke und Computernetzwerke.

>

Von: Messari

Wenn Crypto auf finanzieller Ebene dezentrale Veränderungen gebracht hat, ist Depin eine dezentrale Lösung in der Realwirtschaft.Es kann gesagt werden, dass die POW -Mining -Maschine eine Depine ist.Ab dem ersten Tag ist Depin die Kernsäule von Web3.

AI Drei Elemente -Algorithmus, Rechenleistung, Daten, Depin monopolisieren sie

Die Entwicklung künstlicher Intelligenz hängt normalerweise von drei Schlüsselelementen ab: Algorithmen, Rechenleistung und Daten.Der Algorithmus bezieht sich auf das mathematische Modell und die Programmlogik des Laufwerks -AI -Systems.

>

Welches der drei Elemente ist am wichtigsten?Vor dem Erscheinen von ChatGPT denken die Leute normalerweise, dass es sich um einen Algorithmus handelt, ansonsten werden akademische Konferenzen und Journalpapiere nicht mit feinem Tuning durch Algorithmen gefüllt.Nach dem Erscheinen von Chatgpt und LLM, das seine intelligente LLM unterstützt, erkannten die Menschen die Bedeutung der letzten beiden.Massive Rechenleistung ist die Voraussetzung für die Produktion des Modells.

In der Zeit großer Modelle hat sich die KI von der feinen Schnitzerei zu kräftig fliegenden Ziegeln verändert.Die Token sind inspiriert, den langen Markt für den langen Verbraucher zu nutzen.

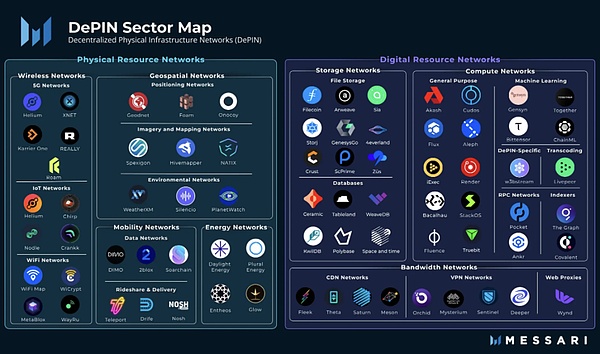

Die Dezentralisierung von AI ist keine Option, sondern eine obligatorische Option

Natürlich werden einige Leute in AWS -Computerräumen fragen, und sie sind in Bezug auf Stabilität und Erfahrung besser als Depin als Depin.

Diese Aussage ist schließlich Sinn.Warum?Da nur große Internetunternehmen über genügend hochwertige Daten und die Rechenleistung verfügen, die durch starke finanzielle Ressourcen unterstützt werden.Aber das ist falsch, die Leute wollen nicht mehr von Internetgiganten manipuliert werden.

Einerseits verfügt die zentrale KI über Datenschutz- und Sicherheitsrisiken, die überprüft und kontrolliert werden können.

>

Von: https://www.gensyn.ai///

Menschen sollten kein KI -Alter Martin Luther brauchen, und die Menschen sollten das Recht haben, direkt mit Gott zu sprechen.

Schauen Sie sich Depin an: Kostenreduzierung und Effizienz sind der Schlüssel

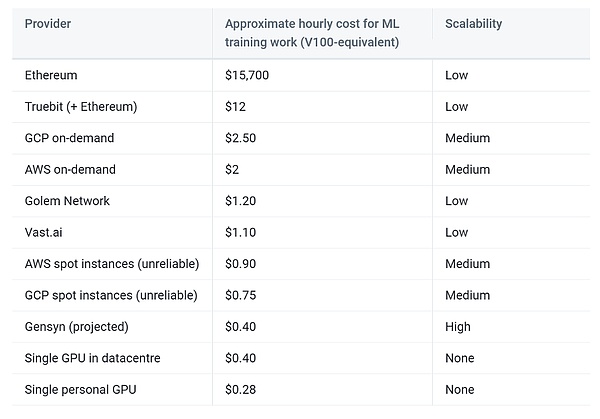

Selbst wenn Sie den Streit zwischen Dezentralisierung und zentralisierten Werten aus geschäftlicher Sicht beiseite legen, ist die Verwendung von Depin für KI immer noch wünschenswert.

Zunächst müssen wir klar erkennen, dass die Kombination von Verbrauchergrafikkarten, die in die Personen verstreut sind, auch ein sehr beträchtliches Computer -Leistungsnetzwerk darstellen kann. Der lange Effekt der Rechenleistung.Diese Art von Verbrauchergrafikkarte ist tatsächlich sehr hoch.Solange die von Depin gegebenen Anreize die Stromrechnung überschreiten können, hat der Benutzer die Motivation, zum Netzwerk beizutragen.Gleichzeitig werden alle physischen Einrichtungen vom Benutzer selbst verwaltet.

Für Daten kann das Depin -Netzwerk die Verfügbarkeit potenzieller Daten über Edge Computing und andere Methoden freigeben und die Übertragungskosten senken.Gleichzeitig haben die meisten verteilten Speichernetzwerke automatisch Funktionen für die Heizung, was die Arbeit der Reinigung von AI -Trainingsdaten verringert.

Schließlich verbessert die Krypto -Ökonomie, die Depin mitgebracht hat, den Verwerfungs -Toleranzraum des Systems, der voraussichtlich eine Gewinn -Win -Situation von Anbietern, Verbrauchern und Plattformen erzielt.

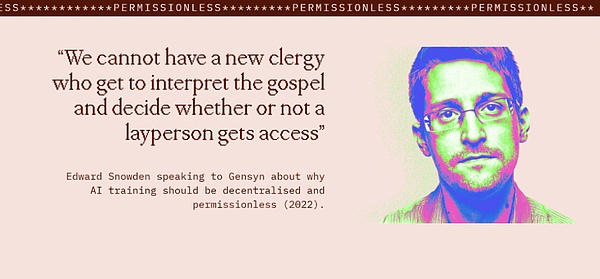

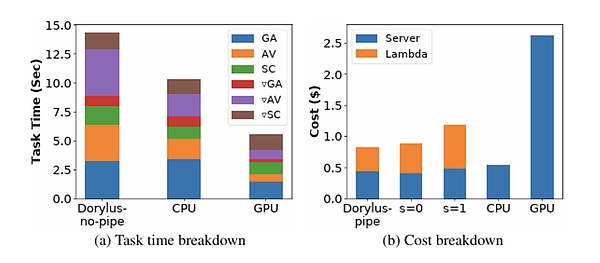

>

Von: UCLA

Falls Sie nicht glauben, dass die neueste Untersuchung von UCLA im Vergleich zum herkömmlichen GPU -Cluster die Verwendung dezentraler Berechnungen unter den gleichen Kosten erreicht hat.

Welche Herausforderungen wird Aixdepin begegnen?

Wir gehen in diesem Jahrzehnt zum Mond und tun die andere Sache, nicht weil sie einfach sind, sondern weil sie Hart sind.

—— John Fitzgerald Kennedy

Die Verwendung von Depin -verteilten Speicher und verteiltem Computing zum Aufbau eines künstlichen Intelligenzmodells ohne Vertrauen hat immer noch viele Herausforderungen.

Arbeitsüberprüfung

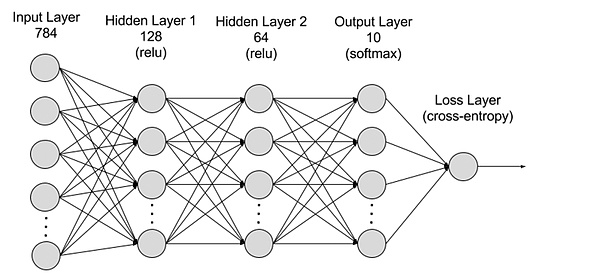

Im Wesentlichen werden im Wesentlichen tiefe Lernmodelle und das POW -Mining berechnet, und die untere Schicht ist Signalwechsel zwischen den Türschaltungen.In Makro handelt es sich um eine „nutzlose Berechnung“ und umgekehrte Ableitung berechnen die Parameterwerte jeder Schicht im tiefen Lernen und bauen so ein effizientes AI -Modell auf.

Tatsache ist, dass „nutzloses Computer“ wie POW -Mining Hash -Funktionen verwendet. Die Ausgabe jeder Schicht wird als Eingang der letzteren Schicht verwendet.

>

Von: AWS

Die Arbeitsüberprüfung ist sehr kritisch.

Eine Ideenart besteht darin, verschiedenen Servern die gleiche Rechenaufgabe auszuführen und die Wirksamkeit der Arbeit zu überprüfen, indem es wiederholt und testet, ob dieselbe ist.Die meisten Modellberechnungen sind jedoch nicht sicher, und die gleichen Ergebnisse können nicht selbst in einer genau derselben Berechnungsumgebung reproduziert werden, und sie können nur statistisch nur ähnlich sein.Darüber hinaus führen wiederholte Berechnungen zu einem raschen Anstieg der Kosten, was nicht mit den wichtigsten Zielen der Depinkostenreduzierung und -Effizienz widerspricht.

Eine andere Art von Idee ist der optimistische Mechanismus.

Parallelisierung

Wie bereits erwähnt, ist Depin’s Prezing hauptsächlich der Computingmarkt von Long -Schwanz -Verbrauchern, der bestimmt ist, dass die Rechenleistung, die ein einzelnes Gerät bereitstellen kann, relativ begrenzt ist.Für große KI -Modelle ist die Trainingszeit auf einem einzigen Gerät sehr lang.

Die Hauptschwierigkeit der Parallelisierung des Tiefkulissens ist die Abhängigkeit zwischen den Aufgaben von vorne und hinten kann es schwierig machen, eine Parallelisierung zu erreichen.

Gegenwärtig ist die Parallelisierung des Tiefenlerntrainings hauptsächlich in paralleles und Modellparallel unterteilt.

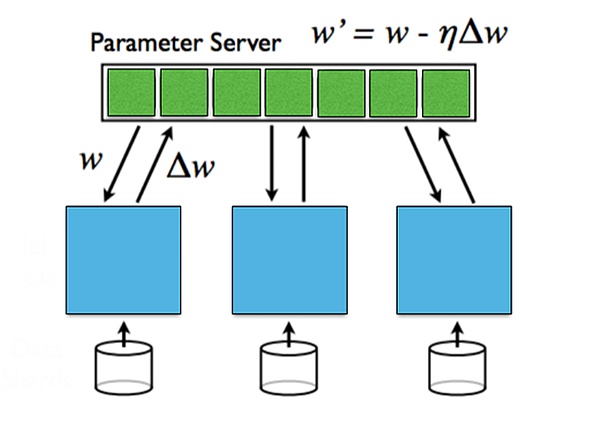

Daten parallel beziehen sich auf die Verteilung von Daten auf mehreren Maschinen.Datenparallel sind effektiv, wenn die Datenmenge groß ist, sie muss jedoch mit aggregierten Parametern synchronisiert werden.

Das Modellparallel ist, wenn die Modellgröße nicht in eine einzelne Maschine eingebracht werden kann und das Modell auf mehreren Maschinen unterteilt werden kann und jede Maschine einen Teil der Parameter des Modells speichert.Es sind verschiedene Maschinen erforderlich, um zwischen Vorwärts- und Rückwärtskommunikation zu kommunizieren.Das Modellparallel hat einen Vorteil, wenn das Modell groß ist, aber der Kommunikationsaufwand, wenn es sich ausbreitet, ist groß.

Für Gradienteninformationen zwischen verschiedenen Ebenen kann sie in synchrone Updates und asynchrone Updates unterteilt werden.Synchrones Update ist einfach und direkt, aber es wird die Wartezeit erhöhen.

>

Von: Stanford University, parallel und verteilt Deep Learning

Privatsphäre

Die Welt legt die Welle des Schutzes der Privatsphäre aus, und die Regierungen verschiedener Länder stärken den Schutz der Privatsphäre und Sicherheit personenbezogener Daten.Obwohl AI eine große Anzahl öffentlicher Datensätze verwendet, handelt es sich auch um proprietäre Benutzerdaten verschiedener KI -Modelle.

Wie kann man die Vorteile von proprietären Daten während des Schulungsprozesses erhalten, ohne die Privatsphäre aufzudecken?Wie kann man sicherstellen, dass die konstruierten KI -Modellparameter nicht durchgesickert sind?

Dies sind zwei Aspekte der Privatsphäre, Datenschutz- und Modell -Privatsphäre.Datenschutz wird von Benutzern geschützt, und der Schutz des Modells des Modells besteht darin, eine Modellorganisation zu erstellen.In aktuellen Fällen ist Datenschutz viel wichtiger als die Datenschutzmodell.

Eine Vielzahl von Lösungen versuchen, das Problem der Privatsphäre zu lösen.Das Lernen des Bundes wird nach Datenquelle geschult, und die Daten werden lokal gelassen, und Modellparameter werden übertragen, um die Datenschutz zu gewährleisten.

Fallanalyse: Was sind die hochwertigen Projekte auf dem Markt?

Geneyn

Gensyn ist ein verteiltes Computernetzwerk für Schulungs -KI -Modelle.Das Netzwerk verwendet eine Blockchain -Ebene, die auf Polkadot basiert, um zu überprüfen, ob die Deep -Learning -Aufgabe korrekt ausgeführt wurde und die Zahlung durch den Befehl auslöst.Im Jahr 2020 wurde im Juni 2023 eine Finanzierung von 43 Millionen US -Dollar gegründet, und A16Z LED.

Gensyn verwendet Gradienten -basierte Metadaten basierend auf dem Gradienten -Basis -Optimierungsprozess, um das Zertifikat der Ausführungsarbeiten zu konstruieren, und wird durch Multi -Korn-, Grafik -basierte genaue Protokoll- und Querversicherungsvorrichtung implementiert, um die Re -Operation und Überprüfung der Arbeit und Konsistenz zu ermöglichen Am Ende wird die Kette bestätigt, um die Wirksamkeit der Berechnung zu gewährleisten.Um die Zuverlässigkeit der Arbeitsüberprüfung weiter zu stärken, führte Gensyn die Verpflichtung ein, Anreize zu schaffen.

Es gibt vier Arten von Teilnehmern im System: Einreicher, Lösung, Überprüfungen und Reporter.

• Die Einreicher sind das System des Systems, das die Berechnung der Aufgaben zur Verfügung stellt und die ausgefüllte Arbeitseinheit bezahlen kann.

• Das Lösungsgerät ist der Hauptarbeiter des Systems.

• Überprüfungsgerät ist der Schlüssel zum nicht bestätigten Trainingsprozess mit der linearen Berechnung.

• Der Reporter ist die letzte Verteidigungslinie.

Die Lösungsperson muss sich verpflichten, der Reporter inspiziert die Arbeit der Lösung.

Laut Gensyns Prognose wird der Plan voraussichtlich die Schulungskosten auf 1/5 des zentralisierten Lieferanten senken.

>

Von: Genyn

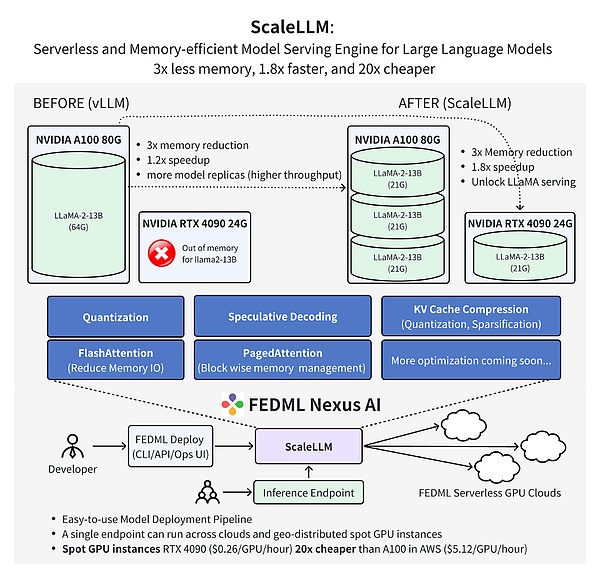

Fedml

FEDML ist eine dezentrale Kooperation für maschinelles Lernen für die Dezentralisierung und die kollaborative KI in jeder Skala überall.Insbesondere bietet FEDML ein MLOPS -Ökosystem, mit dem Modelle für maschinelles Lernen geschult, bereitgestellt, überwacht und kontinuierlich verbessert werden können.Fedml wurde im Jahr 2022 gegründet und gab im März 2023 eine Saatgut -Finanzierung von 6 Millionen US -Dollar bekannt.

FEDML besteht aus zwei Schlüsselkomponenten: FEDML-API bzw. FEDML-CORE, die High-End-APIs bzw. zugrunde liegende APIs darstellen.

FEDML-CORE enthält zwei unabhängige Module für verteilte Kommunikation und Modelltraining.Das Kommunikationsmodul ist für die zugrunde liegende Kommunikation zwischen verschiedenen Arbeitnehmern/Kunden verantwortlich, basierend auf MPI.

Fedml-api basiert auf Fedml-Core.Mit FEDML-CORE können neue verteilte Algorithmen einfach mithilfe einer Client-Programmierschnittstelle erreicht werden.

Die neueste Arbeit des FEDML -Teams beweist, dass die Verwendung von Fedml Nexus AI zur Durchführung von KI -Modellarten für die Verbraucher -GPU RTX 4090, die 20 -mal billiger ist als die A100 und 1,88 -mal schneller.

>

Von: Fedml

Zukünftige Aussichten: Depin bringt die AI -Demokratie mit

Eines Tages entwickelte sich die KI weiter zu AGI.

Die Verschmelzung von AI und Depin hat einen neuen technologischen Wachstumspunkt eröffnet und bietet große Möglichkeiten für die Entwicklung künstlicher Intelligenz.Depin bietet KI eine große Menge an verteilten Rechenleistung und -daten, die dazu beiträgt, ein größeres Modell zu trainieren und eine stärkere Intelligenz zu erreichen.Gleichzeitig hat Depin auch die KI in einer offeneren, sichereren und zuverlässigeren Richtung entwickelt, um die Abhängigkeit von der Infrastruktur eines einzelnen Zentrums zu verringern.

AI und Depin freuen sich auf die Zukunft und werden sich weiterentwickeln.Das verteilte Netzwerk wird eine starke Grundlage für Schulungen übergroßer Modelle bieten, und diese Modelle spielen eine wichtige Rolle bei Depin -Anwendungen.Während des Schutzes von Privatsphäre und Sicherheit hilft KI auch dem Depin -Netzwerkprotokoll und der Algorithmusoptimierung.Wir freuen uns auf KI und Depin bringt effizientere, fairere und glaubwürdigere digitale Welten.