résumé

La concurrence des produits à l’ère AI est inséparable à partir de l’extrémité des ressources (puissance de calcul, données, etc.), en particulier la fin de ressource stable pour prendre en charge.

La formation / itération du modèle nécessite également un énorme utilisateur (IP) pour aider à alimenter les données pour produire des modifications qualitatives à l’efficacité du modèle.

La combinaison avec WEB3 peut aider les équipes de démarrage de l’IA de petite et moyenne taille pour réaliser des dépassements de courbe aux géants traditionnels de l’IA.

Pour l’écologie Depin, la fin des ressources de la puissance de calcul, de la bande passante et d’autres ressources déterminent la limite inférieure (la simple intégration de puissance de calcul ne protège pas la ville); et l’utilisation efficace des données déterminent les dimensions des dimensions déterminez la limite du projet.

Dans le contexte de l’AI + Depin, du raisonnement du modèle & amp;

Analyse du marché de l’IA & AMP;

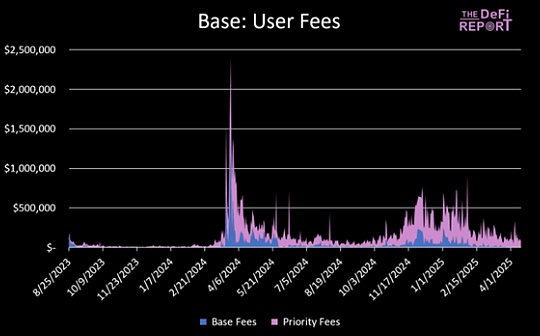

Selon les statistiques, de la naissance de Chatgpt en septembre 2022 à août 2023, les produits mondiaux des 50 meilleurs produits d’IA ont généré plus de 24 milliards de visites, avec une croissance mensuelle moyenne de 236,3 millions.

La prospérité des produits d’IA est exacerbée à la dépendance de la puissance de calcul.

>

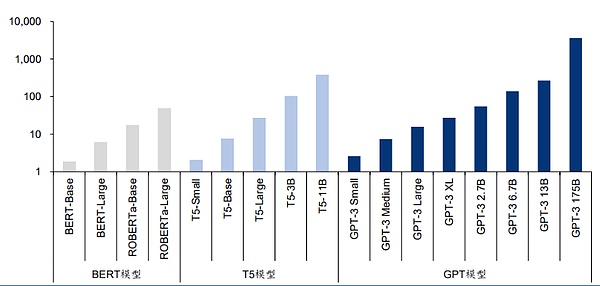

Source: « Les modèles de langue sont des apprenants à quelques coups » «

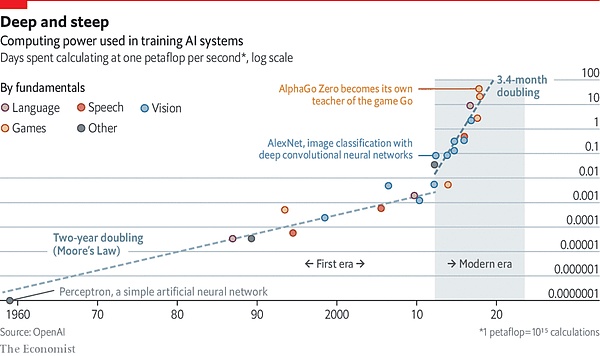

Un article de l’Université du Massachusetts à l’Université d’Amoster déclare que « la formation d’un modèle d’intelligence artificielle, l’émission de carbone émise dans sa vie est équivalente aux émissions de carbone de cinq voitures ». Cependant, cette analyse implique une seule formation.Lorsque le modèle est amélioré par une formation répétée, l’utilisation de l’énergie sera considérablement augmentée.

Le dernier modèle de langue contient des milliards, voire des milliards de poids.Un modèle populaire GPT-3 a 175 milliards de paramètres d’apprentissage automatique.Si vous utilisez A100 pour utiliser 1024 GPU, 34 jours et 4,6 millions de dollars américains pour former le modèle.

La compétition à l’ère de l’IA s’est progressivement étendue à une guerre axée sur les ressources en puissance de calcul.

>

Source: L’IA nuise à notre planète: aborder le coût énergétique stupéfiant de l’IA

Cela étend trois questions:Premièrement, si un produit IA a une fin de ressource suffisante (puissance de calcul, bande passante, etc.), en particulier la fin de ressource stable pour prendre en charge.Cette fiabilité nécessite une décentralisation avec une puissance de calcul suffisante.Dans le domaine traditionnel, en raison de l’écart au côté de la demande des puces, couplé au mur mondial en fonction des politiques et de l’idéologie, le fabricant de puces est naturellement dans une position avantageuse, et il peut augmenter considérablement les prix.Par exemple, le modèle NVIDIA H100 est passé de 36 000 dollars américains en avril 2023 à 50 000 $, ce qui a encore augmenté le coût de l’équipe de formation des modèles d’IA.

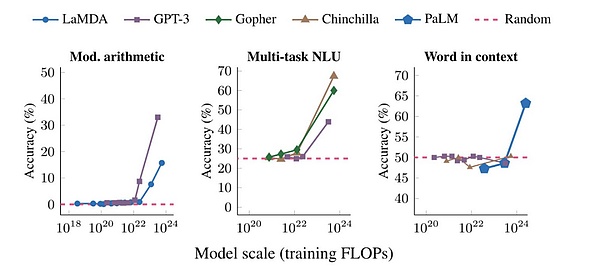

Le deuxième problème est que la satisfaction de la condition latérale des ressources aide le projet d’IA à résoudre le matériel, mais la formation / itération du modèle nécessite également une énorme norme (IP) pour aider à nourrir les données.Une fois que la taille du modèle dépasse un certain seuil, les performances sur différentes tâches montrent une croissance révolutionnaire.

La troisième question est la suivante: il est difficile pour l’IA de petites et moyennes de créer une équipe.Le monopole de la puissance traditionnelle du marché financier a également conduit au monopole du schéma de modèle d’IA.Les équipes de l’IA de petite et moyenne taille doivent rechercher une compétition plus différenciée.

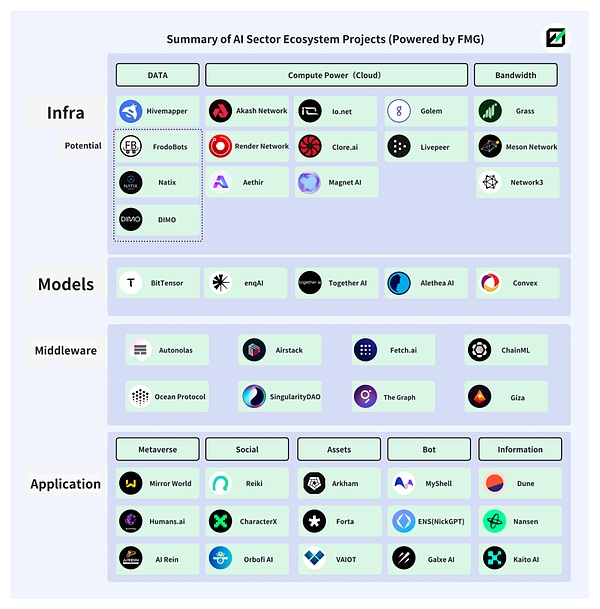

Les trois questions ci-dessus peuvent être trouvées sur le Web3.En fait, la combinaison de l’IA et du Web3 a une longue histoire et l’écologie est plus prospère.

L’image ci-dessous est quelques-uns des écosystèmes AI + Web3 en groupe futur.

>

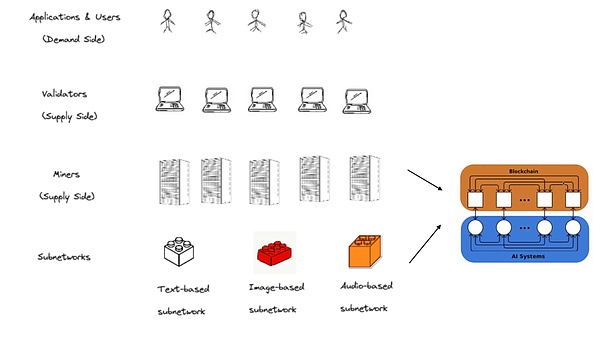

Ai + Depin

1. Solution Depin

Depin est une abréviation de réseaux d’infrastructures physiques décentralisés, et il s’agit également d’une collection de relations de production entre personnes et équipements. Dans le même temps, le fonctionnement ordonné du modèle économique est atteint.

Par rapport à une définition plus large WEB3, car Depin a naturellement une relation plus profonde avec les équipements matériels et les entreprises traditionnelles, Depin a des avantages naturels à attirer des équipes d’IA de site et des fonds connexes.

La poursuite par DePin Ecology of Distributed Computing Power et les incitations des contributions ne résout que les besoins des produits d’IA pour la puissance de calcul et l’IP.

-

DePin a utilisé des jetons pour promouvoir l’entrée de la puissance mondiale de calcul (calcul de la puissance de la puissance et ampli), réduisant le risque centralisé de calcul et réduisant le coût d’appel de la puissance de calcul par l’équipe de l’IA.

-

La composition IP énorme et diversifiée de l’écosystème Depin aide les modèles AI peut réaliser la diversité et l’objectivité des canaux d’acquisition de données.

-

Le chevauchement des utilisateurs écologiques Depin et des utilisateurs de Web3 sur le portrait de personnage peut aider les projets AI à régler dans le règlement pour développer davantage de modèles d’IA avec des caractéristiques Web3 pour former une concurrence différenciée.

Dans le domaine de WEB2, la collecte des données du modèle AI provient généralement de l’ensemble de données publiques ou du producteur de modèle. sortir.La méthode traditionnelle de collecte de données est limitée à l’efficacité et au coût de la collecte, et il est difficile d’obtenir une plus grande échelle de modèle (nombre de paramètres, temps de formation et qualité des données).Pour le modèle d’IA, plus la taille du modèle est grande, plus les performances du modèle provoquent des changements qualitatifs.

>

Source: Capacités émerures des modèles de grande langue: comment ils résolvent les proplems qu’ils sont trop pour ne pas aborder?

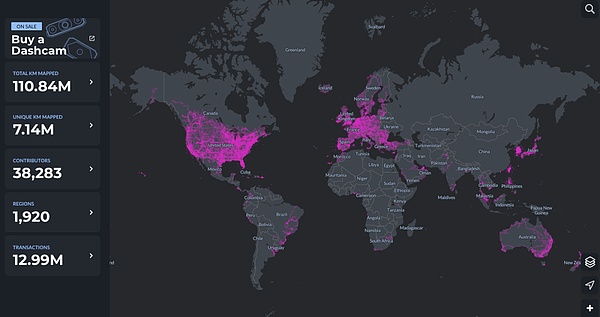

Depin a des avantages naturels dans ce domaine.Prenant l’exemple de Hivemapper, il est distribué dans les régions de 1920 du monde entier, et près de 40 000 contributeurs fournissent des données pour MAP AI (MAP AI Model).

>

La combinaison de l’IA et de DePin signifie également que la fusion de l’IA et du Web3 a augmenté une nouvelle hauteur.Le projet AI actuel dans WEB3 est une épidémie largement à la fin de l’application et a à peine ri en fonction de la dépendance directe de l’infrastructure Web2. impliqué.

L’élément Web3 a été en aval de la chaîne alimentaire et ne peut pas obtenir un véritable rendement excédentaire.C’est également le cas pour la plate-forme de puissance de calcul distribuée. Il est impossible de promouvoir le fonctionnement du volant à travers l’économie symbolique.

Cependant, le concept d’Ai + Depin brise cette relation inhérente et transfère l’attention de WEB3 à un modèle IA plus large.

2. Résumé du projet AI + Depin

DePin a un équipement interne (puissance de calcul, une bande passante, un algorithme, des données), des utilisateurs (fournisseurs de données de formation de modèles) et des mécanismes d’incitation écologiques (économie de jetons).

Nous pouvons le définir hardiment: fournir à l’IA des conditions d’objectif complètes (alimentation informatique / bande passante / données / IP), fournir des scénarios de modèle AI (formation / raisonnement / fin de fin Pour Ai + Depin.

Future Money Group énumérera les paradigmes classiques de Ai + Depin.

>

Nous sommes divisés en puissance informatique, bande passante, données et autres sections en fonction des différentes catégories de ressources, et essayons de régler les projets de différents secteurs.

2.1 Power de calcul

Le côté de la puissance de calcul est la composition principale du secteur AI + DEPIN, et il est également la plus grande partie de la composition du projet.Pour le projet de puissance de calcul, la composition principale de la puissance de calcul est GPU (processeur graphique), CPU (processeur central) et TPU (puce d’apprentissage automatique professionnelle).Parmi eux, les TPU sont principalement créés par Google en raison de la difficulté de fabrication, et seuls les services de location de cloud-to -algorithme sont effectués.Le GPU est un composant matériel similaire à un CPU, mais plus professionnel.Par rapport aux CPU ordinaires, il peut gérer des opérations mathématiques complexes qui exécutent plus efficacement les opérations parallèles.Le GPU initial a été consacré à la gestion des tâches de rendu graphique dans les jeux et les animations, mais maintenant leur objectif dépasse de loin cela.Par conséquent, le GPU est la principale source du marché actuel de la puissance de calcul.

Par conséquent, bon nombre des projets AI + Depin que nous pouvons voir, dont beaucoup sont spécialisés dans les graphiques et le rendu vidéo, ou des jeux connexes, qui sont causés par les caractéristiques du GPU.

D’un point de vue global, la catégorie de puissance de calcul AI + Depin Produits, le principal fournisseur de sa puissance de calcul se compose de trois parties: les fournisseurs de services de calcul du cloud traditionnels;Parmi eux, les fournisseurs de services de puissance de cloud computing ont pris en compte relativement important, inactif pour la puissance de calcul personnel.Cela signifie que ces produits sont plus souvent joués comme des agents informatiques.Le côté de la demande est une variété d’équipes de développement de modèles d’IA.

À l’heure actuelle, dans cette catégorie, la puissance de calcul peut difficilement être utilisée à 100% dans la réalité, et plus souvent dans un état d’inactivité.Par exemple, Akash Network, actuellement dans l’état d’utilisation, est d’environ 35%, et la puissance de calcul restante est inactive.Io.net est également similaire.

Cela peut être causé par le nombre actuel d’exigences de formation des modèles d’IA, et c’est aussi pourquoi AI + DePin peut fournir des coûts de puissance de calcul bon marché.Avec l’expansion du marché de l’IA, cette situation s’améliorera.

Réseau Akash: marché des services cloud décentralisés de ponctuels

Le réseau Akash est un marché de services cloud à point décentralisé, qui est généralement appelé Airbnb, qui est appelé service cloud.Akash Network permet aux utilisateurs de différentes tailles d’utiliser leurs services rapidement, stables et économiquement.

Semblable à Render, Akash fournit également aux utilisateurs un déploiement GPU, une location et une formation sur les modèles d’IA.

En août 2023, Akash a lancé Supercloud, permettant aux développeurs de fixer le prix qu’ils sont prêts à payer pour déployer leurs modèles d’IA et les fournisseurs avec une puissance de calcul supplémentaire aux utilisateurs d’hébergement.Cette fonction est très similaire à Airbnb, permettant aux fournisseurs de louer une capacité inutilisée.

En offrant des enchères publiques, le fournisseur du fournisseur de ressources ouvre ses ressources informatiques inactives dans son réseau.

>

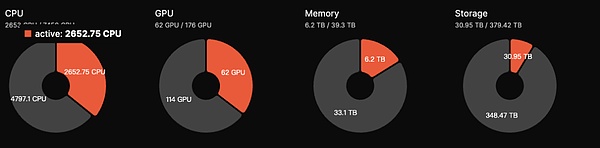

À l’heure actuelle, la quantité totale de GPU écologique Akash est de 176 GPU, mais le nombre d’activités est de 62, avec un degré d’activité de 35%, ce qui est inférieur à 50% en septembre 2023.Le revenu quotidien estimé est d’environ 5 000 $.Les jetons AKT ont une fonction de gage.

Akash a des données plus élevées dans le secteur actuel AI + DePin, et le FDV de 700 millions de dollars a une grande place pour l’augmentation de Rener et Bittensor.

Akash accède également au sous-réseau de Bittersor pour étendre son propre espace de développement.Dans l’ensemble, les projets Akash, en tant que l’un des nombreux projets de haute qualité de la piste AI + Depin, ont d’excellents principes fondamentaux.

IO.NET: AI + DEPIN avec le plus grand nombre de GPU

IO.NET est un réseau informatique décentralisé qui prend en charge le développement, l’exécution et l’expansion des applications ML (Machine Learning) sur la blockchain Solana, et utilise le plus grand cluster GPU du monde pour permettre aux ingénieurs d’apprentissage automatique une petite partie du coût pour louer et accéder au monde La puissance de calcul du service cloud distribué.

Selon les données officielles, IO.NET compte plus d’un million de GPU en veille.De plus, la coopération entre IO.NET et Render a également étendu les ressources GPU disponibles pour le déploiement.

L’écologie IO.NET a plus de GPU, mais presque tous proviennent de la coopération avec divers fabricants de cloud computing et l’accès aux nœuds personnels, et le taux d’inactivité est élevé. Il n’y a que des GPU.Cependant, un avantage majeur des produits IO.NET actuels est que le prix est bon marché.

>

IO.NET ultérieure considère également que les fournisseurs de GPU permettant aux écosystèmes IO d’améliorer leurs chances d’être utilisés par les actifs indigènes hypothéqués.Plus les actifs sont investis, plus l’opportunité sélectionnée est grande.Dans le même temps, les ingénieurs d’IA qui engagent les actifs natifs peuvent également utiliser des GPU à haute performance.

En termes d’échelle d’accès GPU, IO.NET est le plus grand des 10 projets répertoriés dans cet article.En plus du taux d’inactivité, le nombre de GPU dans l’état d’utilisation est également le premier.En termes d’économie de jetons, IO.NET Native Token and ACTRACT TOKEN IO sera lancé au premier trimestre de 2024, avec une offre maximale de 22 300 000.L’utilisateur facturera des frais de 5% lors de l’utilisation du réseau, qui sera utilisé pour Burn Io Tokens ou fournit des incitations aux nouveaux utilisateurs de l’offre et de la demande.Le modèle de jeton a des caractéristiques de levage évidentes.

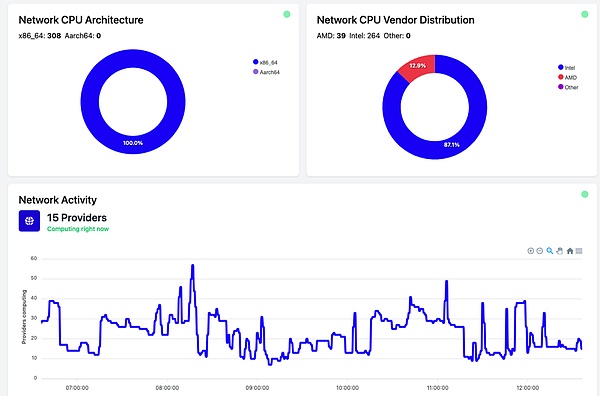

Golem: le marché de la puissance de calcul principalement CPU

Golem est un marché de la puissance informatique décentralisée qui soutient quiconque partage et agrége les ressources informatiques en créant un réseau de ressources partagées.Golem fournit aux utilisateurs la scène de la location de puissance informatique.

Le marché du golem se compose d’un marché à trois parties, qui sont des fournisseurs d’énergie informatique, des exigences de puissance de calcul et des développeurs de logiciels.La partie de la demande de puissance de calcul soumet la tâche informatique et le réseau Golem alloue la tâche informatique au fournisseur de puissance de calcul approprié (fournir une RAM, un espace disque dur et des numéros nucléaires CPU, etc.). Deux parties paieront le règlement par le biais du jeton.

>

Golem utilise principalement un processeur pour calculer l’empilement d’alimentation.Mais le CPU ne peut pas effectuer de hautes opérations de concurrence et la consommation d’énergie est plus élevée.Par conséquent, le CPU pour les baux de puissance de calcul peut être légèrement plus faible que le projet GPU.

Aimant AI: AI modèle Asset-basé

Magnet AI fournit des services de formation de modèles pour différents développeurs de modèles d’IA en intégrant les fournisseurs d’alimentation informatique GPU.Contrairement aux autres produits AI + Depin, Magent AI permet à différentes équipes d’IA de publier des jetons ERC-20 en fonction de leurs propres modèles.

Au Q2, 2024, Magent AI lancera Polygon Zkevm & amp;

Il est un peu similaire à IO.NET.

La différence est que IO.NET se concentre sur l’intégration des ressources GPU, encourageant différents clusters GPU, entreprises et contributions personnelles aux GPU, et en même temps, c’est un pilote d’alimentation informatique.

L’IA magent semble plus concentrée sur le modèle AI.

Résumé simple: Magnet est équivalent à la construction d’un marché avec GPU.

Rendu: joueur professionnel du modèle de type AI graphique

Render Network est un fournisseur de solutions de rendu GPU décentralisé.

Selon le contenu du Livre blanc de Render, basé sur le rendu, les artistes, les ingénieurs et les développeurs peuvent créer une série d’applications d’IA, telles que la génération de contenu 3D auxiliaire AI, le rendu AI Accélération All -Series et l’utilisation de données de diagramme de scène 3D de Render pour la connexion pour connex Formation du modèle AI.

Render fournit aux développeurs AI un SDK du réseau de rendu.

Selon Global Market Insights, la taille du marché mondial du rendu 3D devrait atteindre 6 milliards de dollars.Et 2,2 milliards de dollars américains de FDV ont une place au développement.

À l’heure actuelle, il n’est pas disponible pour les données spécifiques de Render basées sur le GPU, mais parce que la société Otoy derrière Render montre la corrélation avec Apple à plusieurs reprises; Concevez toutes les industries dans les domaines de la vision architecturale et des zones de simulation, y compris le support natif pour les moteurs Unity3D et Unreal.

Et Google et Microsoft ont ajouté le réseau RNDR.Le rendu a traité près de 250 000 demandes de rendu en 2021 et les artistes de l’écologie ont généré environ 5 milliards de dollars de ventes via NFT.

Par conséquent, l’évaluation de référence du rendu devrait être un potentiel de marché (environ 30 milliards de dollars américains).Couplé avec le modèle économique de BME (balance brûlante et coulée), le rendu a encore une certaine place pour Rener en termes de prix de jeton simple ou de FDV.

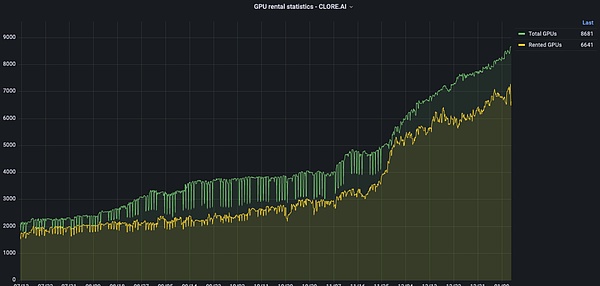

Clore.ai: rendu vidéo

Clore.ai est une plate-forme qui fournit des services de location de puissance de calcul GPU basés sur POW.Les utilisateurs peuvent louer leurs propres GPU pour la formation de l’IA, le rendu vidéo et l’extraction de la crypto-monnaie.

L’étendue des affaires comprend: une formation en intelligence artificielle, un rendu de film, un VPN, une mine de crypto-monnaie, etc.Lorsqu’il existe une demande spécifique de service de calcul, complétez la tâche de la distribution du réseau;

>

Au cours des six derniers mois, le nombre de GPU est passé de 2000 à environ 9 000, mais du point de vue de GPU intégré, Clore.ai dépasse Akash.Mais son FDV du marché secondaire ne représente qu’environ 20% d’Akash.

Sur le modèle de jeton, la CLORE utilise le mode d’extraction de POW sans pré-mine et ICO.

Le montant total des jetons était de 1,3 milliard de yuan.À la fin de 2023, le volume de circulation était d’environ 250 millions, représentant 20% du total des jetons.Par conséquent, le FDV actuel est de 31 millions de dollars. dans les prix de la monnaie est important.

LivePeer: rendu vidéo, raisonnement

LivePeer est basé sur le protocole vidéo décentralisé d’Ethereum pour émettre des récompenses à toutes les parties pour gérer le contenu vidéo en toute sécurité à des prix raisonnables.

Selon le responsable, Livepeer possède des milliers de ressources GPU par semaine pour des millions de transcodage vidéo.

LivePeer peut utiliser la méthode « réseau principal » + « sous-réseau » pour permettre à différents opérateurs de nœuds de générer des sous-réseaux et d’effectuer ces tâches en remplissant le paiement sur le réseau principal de LivePeer.Par exemple, l’introduction de modèles d’IA pour les sous-réseaux vidéo AI pour la formation du modèle AI spécifiquement pour le rendu vidéo.

LivePeer a depuis élargi les pièces liées à l’IA de la formation de modèle simple au raisonnement & ampli;

Aethir: Concentrez-vous sur les jeux cloud et l’IA

Aethir est une plate-forme de jeu cloud qui est une infrastructure cloud décentralisée (DCI) conçue pour les sociétés de jeu et d’intelligence artificielle.Il aide à fournir une charge informatique de GPU lourde au lieu des joueurs pour s’assurer que les joueurs peuvent obtenir une expérience retardée ultra-standard n’importe où et tout équipement.

Dans le même temps, Aethir fournit des services de déploiement, notamment le GPU, le CPU, le disque et d’autres éléments.Le 27 septembre 2023, Aethir a officiellement fourni aux clients mondiaux des services commerciaux pour les jeux cloud et la puissance de calcul de l’IA, et a fourni un support de puissance de calcul pour leurs propres plateformes et modèles d’IA par l’informatique décentralisée intégrée.

En transférant les exigences de puissance de calcul du rendu informatique vers le cloud, le jeu cloud élimine les limites du matériel et du système d’exploitation de l’équipement terminal, qui étend considérablement l’échelle de base du joueur potentiel.

2.2 Bande passante

La bande passante est l’une des ressources fournies par DePin à AI.

En raison des modèles d’IA de plus en plus compliqués, la formation des modèles adopte généralement une variété de stratégies informatiques parallèles, telles que les données parallèles, parallèles au pipeline et parallèles du tenseur.Selon ces modes de calcul parallèles, l’importance des opérations de communication collective entre plusieurs dispositifs informatiques est de plus en plus importante.Par conséquent, lors de la construction d’un grand groupe d’entraînement à l’échelle de grands modèles d’IA, le rôle de la bande passante du réseau est mis en évidence.

Plus important encore, une ressource de bande passante stable et fiable peut garantir que les différents nœuds sont en conséquence évité en conséquence de l’émergence du contrôle à point unique (comme Falcon adopte un mode de réseau de relais à largeur à largeur faible à faible latence pour rechercher le retard et le retard et l’équilibre entre les entretiens entre Bande passante), finalement assurer la confiance et l’anti-révision de l’ensemble du réseau.

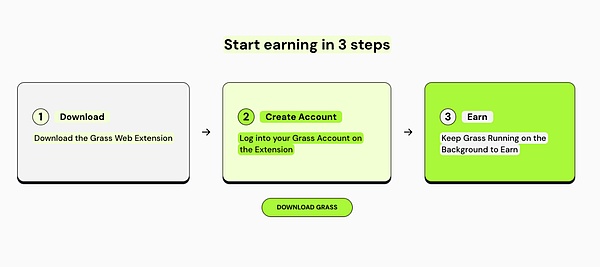

Grass: Band -ie-Mining Products sur le terminal mobile

Grass est le produit phare de Wynnd Network.L’herbe permet aux ménages d’obtenir des têtards passifs par la connexion de l’interconnexion ⽹ en vendant des ressources de marionnettes sans méfiance.

Les utilisateurs peuvent vendre une bande passante sur Internet sur l’herbe pour fournir des services de bande passante à l’équipe de développement de l’IA dans le besoin pour aider à la formation de modèle d’IA pour obtenir des retours de jetons.

À l’heure actuelle, l’herbe est sur le point de lancer une version mobile. En conséquence.

À l’heure actuelle, l’herbe a deux adresses IP à fournir: PC télécharge le programme d’extension et le téléchargement de l’application mobile.(Les terminaux PC et mobiles doivent être dans différents réseaux)

>

Au 29 novembre 2023, la plate-forme Grass a été téléchargée 103 000 fois et 1 450 000 adresses IP uniques.

La demande d’IA sur le mobile et les PC est différente, donc la catégorie de formation du modèle AI applicable est différente.

Par exemple, le terminal mobile propose de nombreuses données sur l’optimisation des images, la reconnaissance du visage, la traduction en temps réel, l’assistant vocal et l’optimisation des performances de l’équipement.Celles-ci sont difficiles à fournir pour le PC.

À l’heure actuelle, l’herbe est dans une position relativement avancée dans la formation du modèle AI mobile.Compte tenu de l’énorme potentiel du marché mobile, les perspectives d’herbe méritent l’attention.

Cependant, l’herbe n’a pas encore fourni d’informations plus efficaces dans le modèle d’IA.

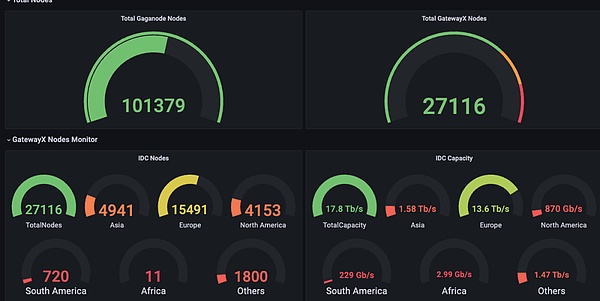

Meson Network: Terminaux mobiles compatibles de la couche 2

Meson Network est le réseau d’accélération de stockage à génération suivante basée sur la couche Blockchain 2. Il agrége les serveurs inactifs via la forme de l’exploitation minière, planifie des ressources de bande passante et les sert avec des fichiers et des supports de streaming pour accélérer le marché, y compris les sites Web traditionnelles, les vidéos, en direct diffusion et bloque le schéma de stockage de la chaîne.

Nous pouvons comprendre Meson Network comme un pool de ressources de bande passante, et les deux côtés du pool peuvent être considérés à la fois comme l’offre et la demande.Le premier contribue à la bande passante et le second utilise la bande passante.

Parmi les structures de produits spécifiques de Meson, il existe deux produits (Gatewayx et Gaganode) sont responsables de la réception de la bande passante contribuant à différents nœuds dans le monde, et un produit (Ipcola) est responsable de la monétisation de ces ressources de bande passante convergentes.

GATEWAYX: Il est principalement intégré de la bande passante d’inactivité commerciale, visant principalement le centre IDC.

À partir de la carte de données de Meson, on peut constater que l’IDC accédent actuellement à plus de 20 000 nœuds dans le monde et que la capacité de transmission de données de 12,5tib / s est formée.

Gaganode: Il intègre principalement la bande passante inactive de l’équipement résidentiel et personnel et fournit une assistance informatique Edge.

IPCOLA: canaux de monétisation Meson et autres tâches telles que la distribution IP et la bande passante.

>

À l’heure actuelle, Meson a révélé qu’un demi-année de revenus représente plus d’un million de dollars américains.Selon les statistiques officielles du site Web, Meson a 27116 nœuds IDC et la capacité IDC est de 17,7 To / s.

>

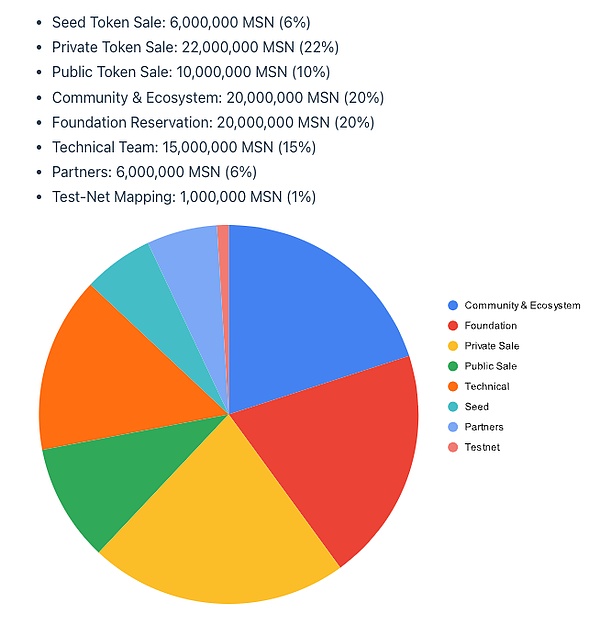

À l’heure actuelle, Meson devrait émettre des jetons de mars à avril 2024, mais l’économie de jetons est annoncée.

Nom des jetons: MSN, l’offre initiale de 100 millions de pièces, le taux d’inflation de l’exploitation minière au cours de la première année était de 5%, soit une diminution de 0,5% par an.

Réseau 3: intégré à l’intégration du réseau SEI

Network3 est une entreprise d’IA qui a construit une couche AI spéciale 2 et intégrée à SEI.Optimiser et comprimer l’algorithme du modèle AI, l’informatique marginale et l’informatique de confidentialité pour fournir des services aux développeurs d’IA dans le monde entier pour aider les développeurs à former et à vérifier le modèle rapidement, facilement et à haute efficacité.

Selon les données officielles du site Web, il existe actuellement plus de 58 000 nœuds actifs de Network3, fournissant des services de bande passante 2PB.Coopérez avec 10 écosystèmes de blockchain tels que Alchemy Pay, Ethsign, Iotex.

2.3 Données

Différente de la puissance de calcul et de la bande passante, l’offre de marché actuelle est relativement niche.Et avec un professionnalisme distinctif.Le groupe de demande est généralement l’équipe de développement de modèles d’IA du projet lui-même ou des catégories connexes.Par exemple, Hivemapper.

En formation de votre propre modèle de carte à travers vos propres données, ce paradigme n’est pas logiquement difficile, nous pouvons donc essayer de détendre le domaine de vision aux projets Depin similaires à Hivemapper, comme DiMo, Natix et Frodobots.

HIVEMPEPER: Concentrez-vous sur sa propre carte AI, l’autonomisation des produits

Hivemapper est l’un des concepts de Depin sur Solana et s’engage à créer un « Google Map » décentralisé.L’utilisateur peut obtenir des jetons de miel en achetant l’enregistreur de conduite lancé par HiveMapper pour utiliser et partager des images réelles avec HiveMapper.

En ce qui concerne Hivemapper, Future Money Group a été décrit en détail dans le « Rapport de recherche FMG: trente-jour en hausse 19 fois, comprenant le format de dépin automobile représenté par Hivemapper », qui n’est pas élargi ici.La raison pour laquelle Hivemapper est inclus dans le secteur AI + DePin est que HiveMapper a lancé MAP AI.

MAP AI joue un nouveau rôle, Trainer AI.Le précédent contributeur des données de l’enregistreur de conduite et le formateur du modèle MAP AI.

>

Les exigences de Hivemapper pour les formateurs du modèle IA ne se sont pas délibérément spécialisées.Plus les ressources IP du projet Depin sont riches, plus l’efficacité de l’IA obtenait des données.Et les utilisateurs participant à la formation d’IA peuvent également obtenir la récompense du jeton de miel.

Les scénarios d’application de l’AI dans HiveMapper sont relativement niche, et HiveMapper ne prend pas en charge la formation de modèle de troisième partie.Par conséquent, la logique d’investissement de Hivemapper ne changera pas.

POTENTIEL

DIMO: collectez les données internes de la voiture

DIMO est une plate-forme IoT basée sur le polygone, permettant aux conducteurs de collecter et de partager les données de leur véhicule.

En analysant les données des véhicules, la plate-forme DiMo peut prédire quand maintenir et rappeler les utilisateurs à temps.Le conducteur peut non seulement comprendre son propre véhicule, mais également contribuer des données à l’écosystème de Dimo, afin d’obtenir les jetons dimo en récompense.En tant que consommateur de données, les données peuvent être extraites du protocole pour comprendre les performances de composants tels que les batteries, les systèmes de conduite autonomes et les commandes.

Natix: Collection de données de la carte de l’autonomisation de la confidentialité

Natix est un réseau décentralisé construit avec des brevets de confidentialité de l’IA.L’objectif est basé sur les brevets de confidentialité de l’IA, combine des caméras mondiales (smartphones, drones, voitures), crée un réseau de caméras d’assurance en Chine et recueille des données sous la prémisse de la conformité à la confidentialité, et sur les cartes dynamiques décentralisées (DDMAP) remplissant le contenu.

Les utilisateurs participant à des données peuvent obtenir des jetons et NFT pour la motivation.

Frodobots: application de réseau décentralisée de robots en tant que transporteur

Frodobots est un jeu Depin avec un robot mobile en tant que transporteur qui affecte les données dans les caméras et a un certain attribut social.

Les utilisateurs pour participer au jeu en achetant des robots et interagir avec les acteurs mondiaux.Dans le même temps, la caméra qui est livrée avec le robot collectera et résumera également les routes et les données de cartographie.

Les trois projets ci-dessus ont deux éléments avec la collecte de données et la propriété intellectuelle.Ces projets incluent Hivemapper, qui nécessite de collecter des données via l’appareil photo et de former une carte complète.Par conséquent, les modèles AI adaptés sont également limités au champ de construction de la carte.L’autonomisation du modèle d’IA aidera le projet à construire un fossé plus élevé.

Il convient de noter que grâce à la collection de caméras, les violations de la confidentialité à deux voies sont souvent rencontrées: telles que la définition des images externes pour collecter des images externes pour les passants; et les utilisateurs attachent leur propre confidentialité.Par exemple, Natix exploite l’IA pour la protection de la vie privée.

2.4 Algorithme

La puissance de calcul, la bande passante et les données se concentrent sur la distinction de l’extrémité des ressources, et l’algorithme se concentre sur le modèle AI.Prenant un exemple d’imertesseur, Bittersor ne contribue pas seulement aux données ou ne contribue pas directement aux calculs.

Semblable à OpenAI, le passagers est le but de maintenir les caractéristiques de décentralisation du modèle pour atteindre les performances de raisonnement qui correspondent aux géants traditionnels du modèle.

La piste d’algorithme a un certain progrès et les éléments similaires sont rares.Lorsque les modèles d’IA, en particulier l’émergence de modèles d’IA basés sur WEB3, la concurrence entre les modèles deviendra normale.

Dans le même temps, la concurrence entre les modèles fera également de l’industrie en aval de l’industrie du modèle d’IA: l’importance du raisonnement et de la fin de l’études fins augmentera.La formation sur le modèle d’IA est uniquement en amont de l’industrie de l’IA. ).Ces processus nécessitent une architecture écologique plus complexe et un support de puissance de calcul.Cela signifie également que le potentiel de développement est énorme.

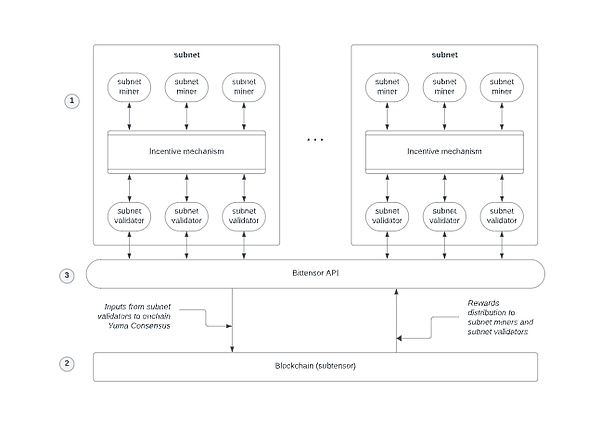

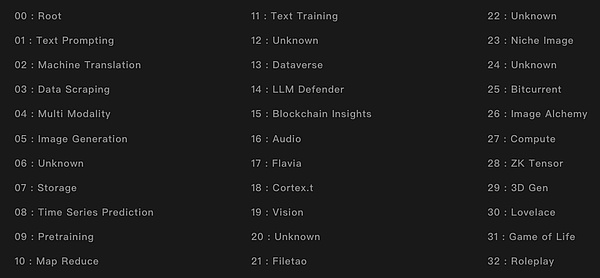

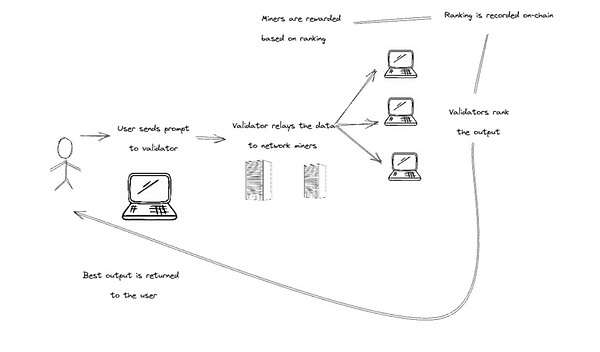

Bittensor: Machine de prophétie du modèle AI

Bittensor est une écologie d’apprentissage automatique décentralisée similaire au réseau principal de Polkadot + sous-réseau.

Logique de travail: Ziwang transmet les informations d’activité à l’API Bittensor (le caractère similaire au Prophète), puis l’API passera les informations utiles au réseau principal, et le réseau principal distribuera des récompenses.

>

>

Bittersor 32 sous-nets

Bittensor Ecological Internal Caractor:

Mineurs: Il peut être compris comme des fournisseurs de divers algorithmes AI et des modèles à travers le monde.

>

Vérification: évaluateur dans le réseau d’imerterre.Évaluez la qualité et l’efficacité du modèle d’IA et classez le modèle d’IA en fonction des performances de tâches spécifiques pour aider les consommateurs à trouver la meilleure solution.

Utilisateur: Le modèle AI fourni par Bittensor est enfin utilisé.Il peut s’agir d’un individu ou des développeurs qui recherchent des modèles d’IA à appliquer.

Nominé: contestez les jetons à des authentificants spécifiques pour exprimer un soutien, ou ils peuvent également modifier différents authentificants à contester.

>

Chaîne d’offre et de demande d’IA ouverte: certaines personnes fournissent des modèles différents, certaines personnes évaluent différents modèles et certaines personnes utilisent les résultats des meilleurs modèles.

Contrairement à Akash et Render, qui est similaire aux «agences de puissance de calcul», Bittensor ressemble plus à un «marché du travail», en utilisant des modèles existants pour absorber plus de données pour rendre le modèle plus raisonnable.Les mineurs et les vérifications ressemblent davantage au rôle du « parti de construction » et du « superviseur ».L’utilisateur soulève des questions, les mineurs publient la réponse, les vérifications évalueront la qualité de la réponse et reviendront enfin à l’utilisateur.

Le jeton d’icher est le token est tao.La valeur marchande du TAO est actuellement en deuxième position après RNDR, mais en raison du mécanisme de libération à long terme de 4 ans, le rapport de la valeur marchande de la valeur complètement diluée est le plus bas de plusieurs projets, ce qui signifie également que la circulation globale de Tao est relativement élevé.Par conséquent, la valeur réelle du TAO est sous-évaluée.

À l’heure actuelle, il est plus difficile de trouver la norme d’évaluation appropriée.

Si vous commencez selon l’attribut « Machine de prédiction », ChainLink (14 milliards de dollars) est l’objet de référence, Tao a près de 9 fois l’augmentation.

Si vous commencez par des similitudes commerciales, Openai (obtenez environ 30 milliards de dollars américains de Microsoft) pour référence, le haut du dur de Tao peut être environ 20 fois.

en conclusion

Dans l’ensemble, AI + Depin a promu le transfert de paradigme de la piste AI dans le contexte WEB3, permettant au marché de sauter de la réflexion inhérente à « AI peut faire dans web3? »

Si le PDG de Nvidia, Huang Renxun, publiera la sortie d’un grand modèle à l’échelle comme « iPhone », alors la combinaison de l’IA et de DePin signifie que le Web3 a vraiment inauguré le moment « iPhone ».

Depin, en tant que cas d’utilisation le plus facilement accepté et mature dans le monde réel, rend Web3 plus acceptable.

En raison de la coïncidence partielle des nœuds IP dans le projet AI + Depin, la combinaison des deux est également la combinaison des deux, et en même temps, il aide également l’industrie à engendrer le modèle et les produits d’IA qui appartiennent à le web3 est propre.Cela aidera le développement global de l’industrie Web3 et ouvrira de nouvelles pistes pour l’industrie, telles que le raisonnement et le tas fin des modèles d’IA, et le développement de modèles d’IA mobiles.

Un point intéressant est que les produits AI + Depin énumérés dans le texte semblent être en mesure d’aller sur le chemin de développement de la chaîne publique imbriquée.Au cours du cycle précédent, diverses nouvelles chaînes publiques ont émergé, en utilisant leurs propres TPS et méthodes de gouvernance pour attirer l’entrée de divers développeurs.

Le produit AI + Depin actuel est le même.Par conséquent, nous constatons actuellement que les produits AI + Depin ont tendance à biaiser la concurrence homogène.

La clé n’est pas la quantité de puissance de calcul (bien qu’il s’agisse d’une condition préalable très importante), mais comment utiliser cette puissance de calcul.La piste AI + DePin actuelle est encore au début de la « croissance barbare », nous pouvons donc avoir des attentes en ce qui concerne le modèle et la forme future et le produit futurs d’Ai + DePin.

Référence

1.https: //www.techopedia.com/decentralized-physical-infraster-networks-depin-brings-nd-crypto-together

2.https: //medium.com/meson-network/with-increing-ai-ndepin-tr 9bd

3.https: //medium.com/cudos/the-rise-as-defin-unveiling-the-obout-of-ai-andaverse-compute-requiments-213f7b5b117171

4.https: //www.numenta.com/blog/2022/05/24/ai-timing-er-planet/

5.https: //www.techflowpost.com/article/detail_15398.html

6.https: //www.numenta.com/blog/2022/05/24/ai-hrming-er-planet/

7.https: //mirror.xyz/livepeer.eth/7yjb5osz28aj9xva54bz4t2hupnm5o9rrpv-zmgwdz44444444444444444