Envoyez 13 tweets d’affilée!

Leader d’Openai Super AlignementJan LeikeC’est-à-dire celui qui vient de suivre Ilya pour quitter l’entreprise, a révélé la vraie raison de sa démission et plus d’informations intérieures.

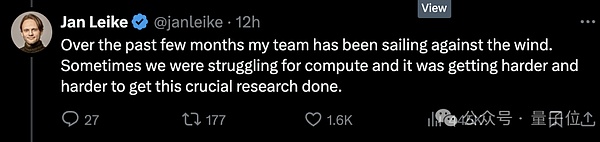

Tout d’abord, il n’y a pas assez de puissance de calcul, promettant de donner à une équipe super alignée une pénurie de 20%, ce qui fait que l’équipe va à l’encontre du courant, mais cela devient de plus en plus difficile.

Deuxièmement, la sécurité n’est pas prise au sérieux, la priorité des problèmes de gouvernance de sécurité d’AGI n’est pas aussi bonne que de lancer un « produit brillant ».

Immédiatement après, plus de ragots ont été déterrés par d’autres.

Par exemple, tous les membres d’OpenAI doivent signer un accord.Assurez-vous de ne pas dire de mauvaises choses à propos d’Openai après avoir quitté votre travail, si vous ne signalez pas, vous serez considéré comme abandonné automatiquement les actions de la société.

Mais il y a encore des os durs qui refusent de se déconnecter et de publier de lourdes nouvelles (en riant à mort), disant que le leadership principal a longtemps été divisé sur les priorités des problèmes de sécurité.

Depuis la bataille du palais l’année dernière, le conflit entre les deux factions a atteint le point critique, puis il semble s’effondrer assez décemment.

Par conséquent, bien que Ultraman ait envoyé des co-fondateurs pour reprendre l’équipe de super alignement, il n’est toujours pas favorisé par le monde extérieur.

Les internautes Twitter qui étaient en première ligne ont remercié Jan d’avoir eu le courage de parler ce melon incroyable et de soupirer:

Je vais juste le ramasser, il semble qu’Openai ne prête vraiment pas beaucoup d’attention à cette sécurité!

Mais en regardant en arrière, Ultraman, qui est maintenant en charge d’Openai, peut toujours s’asseoir pour le moment.

Il s’est levé pour remercier Jan pour sa contribution au super alignement et à la sécurité d’Openai, et a dit qu’il était en fait très triste et réticent à partir.

Bien sûr, le point est en fait cette phrase:

Attends, je publierai un tweet plus long dans deux jours.

La puissance de calcul promise à 20% a en fait les ingrédients de la peinture de gros gâteaux

De la bataille du palais d’Openai l’année dernière à nos jours, la figure d’âme et l’ancien scientifique en chef Ilya n’a presque jamais fait d’apparition publique ni fait des voix publiques.

Avant de prétendre publiquement à démissionner, il y avait de nombreuses opinions différentes.Beaucoup de gens pensent qu’Ilya a vu des choses terribles, comme le système d’IA qui peut détruire les humains.

△ INTÉRIEU

Cette fois, Jan était juste à l’extérieur du bleu, et la raison fondamentale était que les niveaux de priorité des parties techniques et de la sécurité des partis de marché avaient des opinions différentes.

Les différences sont très graves, et les conséquences sont actuellement … tout le monde les a également vus.

Selon Vox, une source familière avec OpenAI a révélé queLes employés qui se concentrent davantage sur la sécurité ont perdu confiance en Ultraman, « Il s’agit d’un processus de confiance qui s’effondre petit à petit. »

Mais comme vous pouvez le voir, sur les plateformes publiques et les occasions, peu d’employés sont prêts à parler publiquement de cette question.

Une partie de la raison est qu’Openai a toujours étéLa tradition d’avoir des employés signer un accord de démission avec les accords de non-dépréciation.Si vous refusez de signer, cela signifie que vous avez abandonné l’option Openai que vous avez obtenue auparavant.Cela signifie que les employés qui sortent pour parler peuvent perdre une énorme somme d’argent.

Cependant, le domino est toujours tombé un par un-

La démission d’Ilya a intensifié la récente vague de démission d’Openai.

L’annonce de sa démission a été suivie par au moins cinq membres de l’équipe de sécurité, à l’exception de Jan, le chef de l’équipe de super alignement.

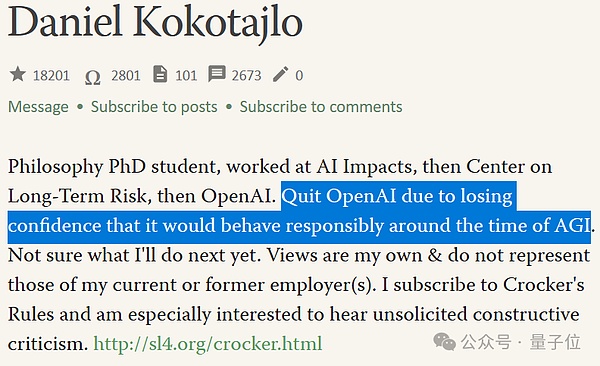

Parmi eux, il y a un autre os dur qui n’a pas signé d’accord de non-dépréciation, Daniel Kokotajlo (ci-après dénommé frère DK).

△ L’année dernière, DK a écrit qu’il pensait que la possibilité d’une catastrophe de survie dans l’IA est de 70%

Le frère DK a rejoint Openai en 2022 et a travaillé dans l’équipe de gouvernance.

Mais il a également démissionné récemment et a été interviewé:

OpenAI entraîne des systèmes d’IA plus puissants dans le but de dépasser finalement l’intelligence humaine.

C’est peut-être la meilleure chose qui soit jamais arrivée à l’humanité, mais c’est peut-être le pire si nous agissons accidentellement.

Frère Dk a expliqué que lorsqu’il a rejoint Openai, il était plein de vengeance et d’espoir pour la gouvernance de la sécurité, et espérait que l’Openai était plus proche de Agi, plus il pouvait être responsable.Mais dans l’équipeBeaucoup de gensJ’ai progressivement réalisé qu’Openai ne sera pas comme ça.

« J’ai progressivement perdu confiance dans la direction d’Openao et leur capacité à gérer AGI de manière responsable. » C’est pourquoi Brother DK a démissionné.

La déception avec les futurs travaux de sécurité AGI fait partie de la raison pour laquelle tout le monde est parti dans la vague intensifiée des départs par Ilya.

Une autre partie de la raison estL’équipe super alignée n’est probablement pas aussi capable de mener des recherches avec des ressources abondantes que le monde extérieur l’imagine.

Même si l’équipe super alignée fonctionne à pleine capacité, l’équipe ne peut obtenir que 20% de la puissance de calcul promise par OpenAI.

Et certaines demandes de l’équipe sont souvent refusées.

Bien sûr, c’est parce que les ressources informatiques sont extrêmement importantes pour les entreprises de l’IA, et chaque point doit être alloué raisonnable;

En d’autres termes, l’équipe de super alignement correspond aux futurs problèmes de sécurité auxquels OpenAI doit faire face – les points clés sont à l’avenir, et je ne sais pas si cela apparaîtra.

Au moment de la presse, Ultraman n’a pas publié son « tweet plus long (que l’initié de Jan) ».

Mais il a brièvement mentionné que les préoccupations de Jan concernant les problèmes de sécurité sont correctes.«Nous avons beaucoup à faire; nous sommes déterminés à faire cela.»

À cet égard, tout le monde peut d’abord installer un petit tabouret, alors mangeons les melons ensemble dès que possible.

En résumé, l’équipe super alignée a laissé de nombreuses personnes, en particulier la démission d’Ilya et Jan, qui a mis cette équipe dans la tempête dans une situation difficile d’être dans un leader.

L’arrangement de suivi estLe co-fondateur John Schulma prend le relais, mais il n’y a plus une équipe dédiée.

La nouvelle équipe de super alignement sera l’équipe liée à la liaison avec des membres répartis dans les différents départements de l’entreprise, un porte-parole d’OpenAI l’a décrit comme «plus d’intégration».

Ceci est également remis en question par le monde extérieur, carLe travail original à temps plein de John était d’assurer la sécurité des produits OpenAI actuels.

Je me demande si John peut être occupé après avoir soudainement eu plus de responsabilités et dirigé les deux équipes qui font attention aux problèmes de sécurité actuels et futurs?

La bataille entre Ilya-Altman

Si le calendrier est allongé, la chute d’aujourd’hui est en fait une suite de la bataille entre le « Palace Fight » d’Openai Ilya-Altman.

En novembre de l’année dernière, alors qu’Ilya était toujours là, il a travaillé avec le conseil d’administration d’Openai pour essayer de licencier Ultraman.

La raison donnée à ce moment-là était qu’il n’était pas suffisamment sincère dans la communication.En d’autres termes, nous ne lui faisons pas confiance.

Mais le résultat final est évident.Ilya quitte la planche.Ultraman, en revanche, a choisi des membres qui lui étaient plus bénéfiques pour rejoindre le conseil d’administration.

Après cela, Ilya a de nouveau disparu de la plate-forme sociale jusqu’à ce qu’elle annonce officiellement sa démission il y a quelques jours.Et on dit qu’il n’est pas apparu dans le bureau d’Openai depuis environ 6 mois.

Il a laissé un tweet intrigant à l’époque, mais il a été rapidement supprimé.

J’ai appris beaucoup de leçons au cours du dernier mois.L’une des leçons est que l’expression «battre se poursuivra jusqu’à ce que le moral s’améliore» s’applique plus souvent qu’il ne le devrait.

Cependant, selon les initiés,Ilya a co-dirigé l’équipe de super alignement à distance.

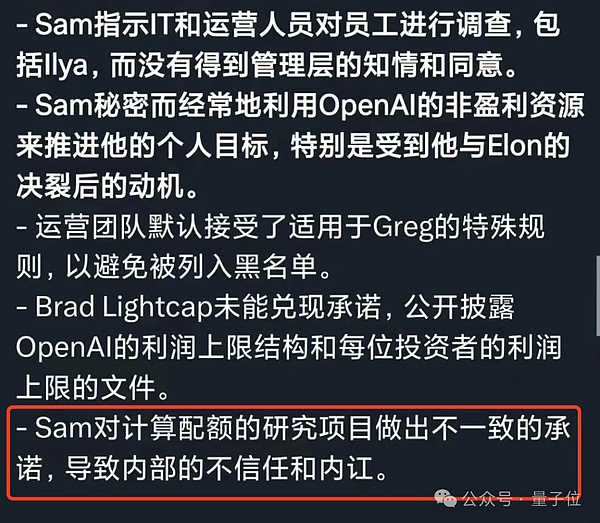

Du côté d’Ultraman, la plus grande accusation des employés de lui était qu’il était en désaccord avec les mots et les actes.

À l’exception des ressources informatiques promises à l’origine ne sont pas données.Il y a aussi des gens qui ont demandé à l’Arabie saoudite et à d’autres de collecter des fonds pour construire des noyaux il y a quelque temps.

Ces employés axés sur la sécurité étaient confus.

S’il se soucie vraiment de construire et de déployer l’intelligence artificielle d’une manière aussi sûre que possible, alors n’accumulerait-il pas des puces si frénétiquement pour accélérer le développement de la technologie?

Plus tôt, OpenAI a également commandé des puces à une startup investie par Ultraman.Le montant est aussi élevé que 51 millions de dollars US (environ 360 millions de RMB).

Dans la lettre de rapport d’anciens employés d’Openai lors des combats du palais, la description d’Ultraman semblait à nouveau confirmée.

C’est à cause de çaDu début à la fin, « différents mots et actes »L’opération a progressivement perdu confiance dans Openai et Ultraman.

Ilya est comme ça, Jan Laike est comme ça, tout comme l’équipe Super Align.

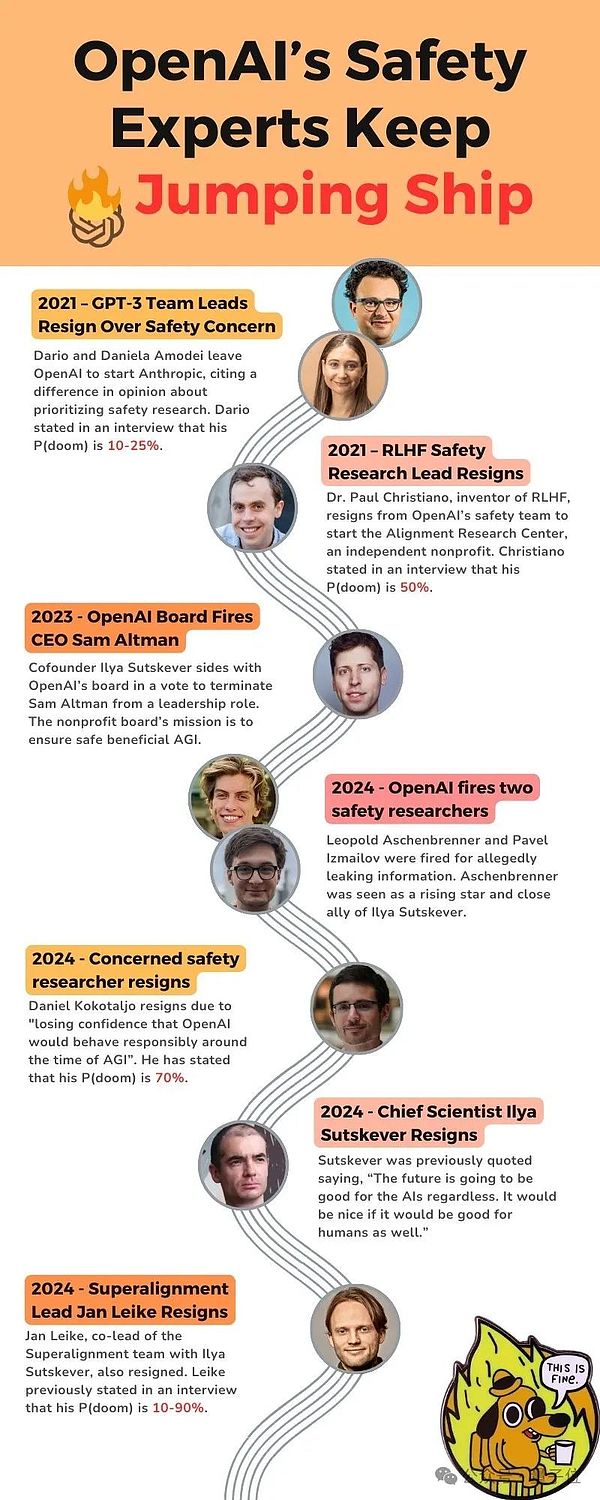

Certains internautes prévenants ont trié des nœuds importants de choses connexes qui se sont produites au cours des dernières années – donnez d’abord un rappel réfléchi, comme mentionné ci-dessousP (DOOM), fait référence à la « possibilité d’IA déclenchant un scénario apocalyptique ».

En 2021, le chef de l’équipe GPT-3 a quitté Openai en raison de problèmes de «sécurité» et a fondé anthropic;

En 2021, le chef de la recherche sur la sécurité du RLHF a démissionné, P (Doom) étant de 50%;

En 2023, le conseil d’administration d’Openai a licencié Ultraman;

En 2024, Openai a licencié deux chercheurs en sécurité;

En 2024, un chercheur OpenAI qui est particulièrement préoccupé par la sécurité de la sécurité, et il pense que P (Doom) est déjà à 70%.

En 2024, Ilya et Jan Laike ont démissionné.

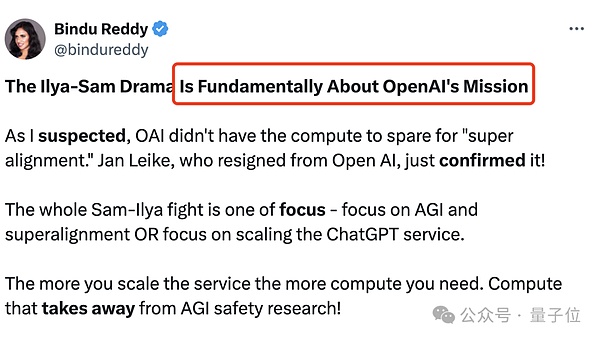

Technique ou marché?

Depuis le développement du grand modèle, « Comment mettre en œuvre AGI? »

École techniqueJ’espère que la technologie peut être mature et contrôlable puis appliquée;MarchéOn pense que lors de l’ouverture, l’application d’approches « progressives » a atteint la fin.

C’est également la différence fondamentale entre le différend Ilya-Altman, à savoir la mission d’Openai:

Concentrez-vous sur l’AGI et le super alignement, ou concentrez-vous sur l’extension des services Chatgpt?

Plus le service Chatgpt est important, plus la quantité de calcul est nécessaire;

Si OpenAI est un organisme à but non lucratif dédié à la recherche, ils devraient passer plus de temps sur un super alignement.

À en juger par certaines mesures externes d’OpenAI, le résultat n’est évidemment pas.Ils veulent juste prendre les devants dans la concurrence des grands modèles et fournir plus de services aux entreprises et aux consommateurs.

De l’avis d’Ilya, c’est une chose très dangereuse.Même si nous ne savons pas ce qui se passera à mesure que l’échelle se développe,De l’avis d’Ilya, la meilleure façon est d’être en sécurité d’abord.

Ouvert et transparent afin que nous, les humains, pouvons nous assurer que l’AGI est construite en toute sécurité, pas d’une manière secrète.

Mais sous le leadership d’Ultraman, Openai semble poursuivre ni open source ni super alignement.Au lieu de cela, il s’agissait de courir vers l’AGI tout en essayant de construire un fossé.

Donc, en fin de compte, le choix du scientifique de l’IAI était correct, ou Ultraman, un homme d’affaires de la Silicon Valley, pourrait-il aller à la fin?

Il n’y a aucun moyen de savoir maintenant.Mais au moins Openai fait face à un choix clé maintenant.

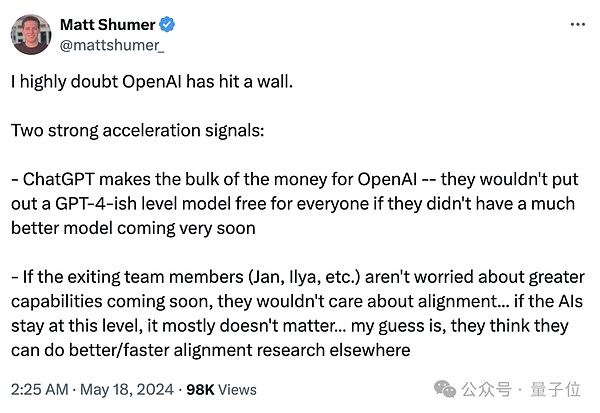

Certains initiés de l’industrie ont résumé deux signaux clés.

unIl s’agit de Chatgpt, les principaux revenus d’Openai.

un autreAutrement dit, si les membres de l’équipe résignés (Jan, Ilya, etc.) ne s’inquiètent pas bientôt de la possibilité de fonctionnalités plus puissantes, ils ne se soucieront pas de l’alignement … si l’IA reste à ce niveau, cela n’a pas importante .

Mais la contradiction fondamentale de l’Openai n’a pas été résolue.

Les deux parties ne sont plus inconciliables, et la faction scientifique est complètement éliminée d’Openai, et le monde extérieur ne sait toujours pas où GPT a atteint?

Les gens qui étaient impatients de connaître la réponse à cette question étaient un peu fatigués.

Un sentiment d’impuissance a monté dans mon cœur, alors que Hinton, le professeur d’Ilya et l’un des trois prix Turing, a déclaré:

Je suis vieux et je suis inquiet, mais je ne peux rien y faire.

Lien de référence:

[1] https://www.vox.com/future-perfect/2024/5/17/24158403/openai-wisignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2] https://x.com/janleike/status/1791498174659715494

[3] https://twitter.com/sama/status/1791543264090472660