Autor: Kyle_13, Quelle: Autor Twitter @kylewmi

Vielen Dank für Ihre Ankunft heute.Wir haben eine Reihe super aufregender Entwicklungen über AO -Technologie, die Sie mit Ihnen teilen können.Wir werden zuerst eine Demo durchführen, und dann werden Nick und ich versuchen, hier einen AI -Agenten zu erstellen, der ein großes Sprachmodell in einem intelligenten Vertrag verwendet, der auf der Grundlage der Chat -Stimmung kauft und verkauft wird, die Sie im System hören möchten .Heute werden wir es vor Ort von Grund auf neu bauen und hoffen, dass alles gut läuft.

Ja, Sie werden sehen, wie Sie alles alleine machen können.

Die technologischen Fortschritte hier machen AO wirklich andere intelligente Vertragssysteme.Dies war bereits vorhanden, und jetzt wird es immer mehr zu einem dezentralen Supercomputer als ein herkömmliches Smart Contract -Netzwerk.Es verfügt jedoch über alle Funktionen eines intelligenten Vertragsnetzwerks.Daher freuen wir uns sehr, dies alles mit Ihnen zu teilen.Lassen Sie uns ohne weiteres die Demo beginnen, und wir werden eine Diskussion führen, und wir werden gemeinsam etwas vor Ort bauen.

Hallo allerseits, vielen Dank für Ihre Ankunft heute.Wir freuen uns sehr, drei wichtige technische Updates für die AO -Vereinbarung bekannt zu geben.Gemeinsam erreichen sie ein großes Ziel, Großsprachmodelle zu unterstützen, die in dezentralen Umgebungen im Rahmen von intelligenten Verträgen betrieben werden.Dies sind nicht nur Spielzeugmodelle, kleine Modelle oder Modelle, die in ihre eigenen Binärdateien zusammengestellt wurden.

Dies ist ein komplettes System, mit dem Sie fast alle wichtigsten Modelle ausführen können, die derzeit Open Source und verfügbar sind.Zum Beispiel läuft LLAMA 3 in Smart Contracts in der Kette, dasselbe gilt auch für GPT sowie die Modelle von Apple usw.Dies ist das Ergebnis der gemeinsamen Bemühungen des gesamten Ökosystems, und drei wichtige technologische Fortschritte sind ebenfalls Teil dieses Systems.Daher freue ich mich sehr, Ihnen das alles vorzustellen.

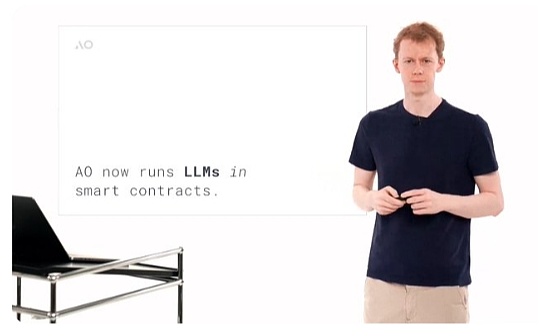

Die allgemeine Situation ist, dass LLM (großes Sprachmodell) jetzt in intelligenten Verträgen ausgeführt werden kann.Sie haben vielleicht viele Male von dezentralen KI- und AI -Kryptowährungen gehört.Mit Ausnahme eines Systems, das wir heute diskutieren werden, sind fast alle diese Systeme AIS als Orakel, dh die KI abseits der Kette und dann die Ausführungsergebnisse für einige nachgelagerte Zwecke.

Wir sprechen nicht darüber.Wir sprechen von großer Sprachmodell -Argumentation als Teil der Ausführung von Smart Contract State.All dies ist der AO -Festplatte und dem hyperparallelen Verarbeitungsmechanismus von AO zu verdanken, was bedeutet, dass Sie viele Berechnungen durchführen können, ohne die verschiedenen Prozesse zu beeinflussen, die ich verwende.Wir glauben, dass wir dies ermöglichen werden, ein sehr reiches, dezentrales autonomes Finanzsystem zu schaffen.

Bisher konnten wir in dezentralen Finanzen (DEFI) im Grunde genommen die Ausführung ursprünglicher Transaktionen vertrauenslos machen.Interaktionen in verschiedenen Wirtschaftsspielen wie Kreditaufnahme und Austausch erfordern kein Vertrauen.Dies ist nur ein Aspekt des Problems.Wenn Sie globale Finanzmärkte berücksichtigen.

Ja, es gibt eine Vielzahl verschiedener wirtschaftlicher Originale, die auf unterschiedliche Weise funktionieren.Es gibt Anleihen, Aktien, Rohstoffe und Derivate usw.Aber wenn wir wirklich über den Markt sprechen, ist es nicht nur das, es ist eigentlich die intelligente Ebene.Es ist die Person, die beschließt, verschiedene Finanzspiele zu kaufen, zu verkaufen, auszuleihen oder an der Hand zu nehmen.

Bisher haben wir im dezentralen Finanzökosystem alle diese Originale erfolgreich in einen vertrauenslosen Staat übertragen.Daher können Sie UNISWAP austauschen, ohne den Betreibern von Uniswap zu vertrauen.Grundsätzlich gibt es keine Betreiber.Die intelligente Schicht des Marktes bleibt zurück.Wenn Sie also an Kryptowährungsinvestitionen teilnehmen möchten und nicht all Ihre Forschung und Ihr Engagement selbst durchführen möchten, müssen Sie einen Fonds finden.

Sie können ihren Mitteln vertrauen, und dann treffen sie kluge Entscheidungen und verabschieden sie stromabwärts an die grundlegende ursprüngliche Ausführung des Netzwerks selbst.Wir glauben, dass wir in AO tatsächlich die Fähigkeit haben, den intelligenten Teil des Marktes, dh die Intelligenz, die zur Entscheidungsfindung führt, zum Netzwerk selbst zu übertragen.Ein einfacher Weg, um es zu verstehen, könnte sein, es sich vorzustellen.

Eine Hedgefonds- oder Portfoliomanagementanwendung, von der Sie vertrauen können, kann eine Reihe von Smart-Anweisungen innerhalb des Netzwerks ausführen und so die Vertrauenslosigkeit des Netzwerks in den Entscheidungsprozess übertragen.Dies bedeutet, dass ein anonymer Konto wie der YOLO 420 Trader Nummer eins (ein mutiger, lässiger Trader) eine neue und interessante Strategie erstellen und sie im Netzwerk bereitstellen kann, in dem Sie Kapital ohne echtes Vertrauen einsetzen können.

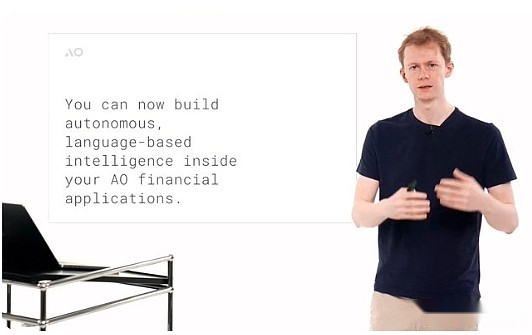

Sie können jetzt autonome Wirkstoffe bauen, die mit großen statistischen Modellen interagieren.Das häufigste große statistische Modell ist das große Sprachmodell, das Text verarbeiten und generieren kann.Dies bedeutet, dass Sie diese Modelle als Teil einer Strategie, die von jemandem mit neuartigen Ideen entwickelt und intelligent im Netzwerk ausführt, in intelligente Verträge einbringen können.

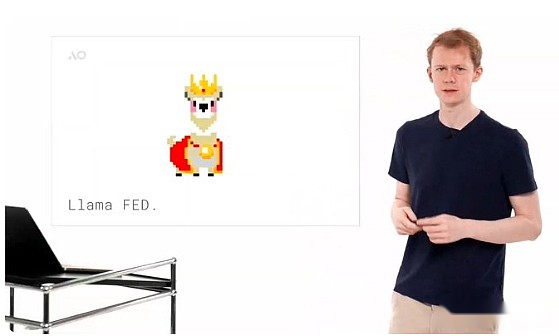

Sie können sich vorstellen, eine grundlegende Stimmungsanalyse durchzuführen.Wenn Sie beispielsweise die Nachrichten lesen, entscheiden Sie, dass dies ein guter Zeitpunkt ist, um dieses Derivat zu kaufen und zu verkaufen.Dies ist ein guter Zeitpunkt, um das eine oder andere zu tun.Sie können Entscheidungen treffen, die den Menschen auf vertrauenslose Weise ähneln.Dies ist nicht nur eine Theorie.Wir haben eine interessante Memmünze namens Lama Fed erstellt.Grundsätzlich ist die Idee, dass es sich um einen Fiat -Währungssimulator handelt, bei dem ein Haufen Lamas (Alpakas) durch das Lama 3 -Modell dargestellt wird.

Sie sind wie eine Kombination aus Lama und dem Fed -Vorsitzenden. Sie können sie finden und sie bitten, einige Token auszugeben, und sie werden Ihre Anfrage bewerten.Großsprachige Modelle selbst betreiben Geldpolitik, völlig autonom und ohne Vertrauen.Wir haben es gebaut, aber wir konnten es nicht kontrollieren.Sie betreiben Geldpolitik und bestimmen, wer die Token bekommen und wer nicht.Dies ist eine sehr interessante kleine Anwendung dieser Technologie und inspiriert hoffentlich alle anderen möglichen Anwendungen im Ökosystem.

Um dies zu erreichen, müssen wir drei neue grundlegende Funktionen für AO erstellen, einige an der Basisprotokollschicht und andere auf der Anwendungsschicht.Dies ist nicht nur nützlich für die Ausführung großer Sprachmodelle, sondern auch umfangreicher und aufregender für AO -Entwickler.Ich bin also froh, diese Ihnen heute vorzustellen.

Die erste dieser neuen Technologien ist die 64-Bit-Unterstützung von Web-Assembly.Es klingt ein bisschen wie ein technischer Begriff, aber ich habe die Möglichkeit, jeden zu verstehen, was es bedeutet.Grundsätzlich ermöglicht die Unterstützung von Web Assembly 64 Entwicklern, Anwendungen zu erstellen, die mehr als 4 GB Speicher verwenden.Wir werden später die neuen Beschränkungen vorstellen, sie sind ziemlich erstaunlich.

Wenn Sie kein Entwickler sind, können Sie es so verstehen: Jemand hat Sie gebeten, ein Buch zu schreiben, und Sie freuen sich über die Idee, aber er sagt, Sie können nur 100 Seiten schreiben.Nicht mehr oder weniger.Sie können die Ideen im Buch ausdrücken, aber es kann nicht auf natürliche und normale Weise durchgeführt werden, da es externe Einschränkungen gibt und Sie sich darauf einsetzen und die Art und Weise ändern müssen, wie Sie es schreiben, um es anzupassen.

Wenn Sie kein Entwickler sind, können Sie es so verstehen: Jemand hat Sie gebeten, ein Buch zu schreiben, und Sie freuen sich über die Idee, aber er sagt, Sie können nur 100 Seiten schreiben.Nicht mehr oder weniger.Sie können die Ideen im Buch ausdrücken, aber es kann nicht auf natürliche und normale Weise durchgeführt werden, da es externe Einschränkungen gibt und Sie sich darauf einsetzen und die Art und Weise ändern müssen, wie Sie es schreiben, um es anzupassen.

Im Smart Contract-Ökosystem ist dies mehr als nur eine 100-seitige Grenze.Ich würde sagen, es ist ein bisschen, als würde man in früheren Versionen von AO bauen.Ethereum hat eine 48 -KB -Speichergrenze, genau wie jemand Sie gebeten hat, ein Buch zu schreiben, das nur einen Satz lang ist, und Sie können nur die 200 beliebtesten englischen Wörter verwenden.Es ist äußerst schwierig, eine wirklich aufregende Anwendung in diesem System zu erstellen.

Dann gibt es Solana, in der Sie auf 10 MB Arbeitsspeicher zugreifen können.Dies ist offensichtlich eine Verbesserung, aber im Grunde sprechen wir über eine Seite.ICP, Internet Computer Protocol, ermöglicht die Unterstützung von 3 GB Speicher.Es ist theoretisch vollständig, aber sie mussten es auf 3 GB senken.Mit 3 GB Speicher können Sie jetzt viele verschiedene Anwendungen ausführen, aber Sie können mit Sicherheit keine großen KI -Anwendungen ausführen.Sie erfordern das Laden großer Datenmengen in den Hauptspeicher, um einen schnellen Zugriff zu erhalten.Dies kann nicht effektiv in 3 GB Speicher implementiert werden.

Als wir im Februar dieses Jahres AO veröffentlichten, hatten wir auch eine 4 -GB -Speichergrenze, die tatsächlich aus der Web -Assembly 32 stammte.Jetzt ist diese Speichergrenze auf Protokollebene vollständig verschwunden.Stattdessen beträgt die Speichergrenze auf Protokollebene 18EB (Exabyte).Dies ist eine große Menge an Speicher.

Es wird eine Weile dauern, bis dies im Speicher für Berechnungen und nicht für Langzeitspeichermedien verwendet wird.Auf der Implementierungsebene hat die Computereinheit im AO -Netzwerk nun Zugriff auf 16 GB Speicher, aber in Zukunft wird es relativ einfach sein, es durch einen höheren Kapazitätsspeicher zu ersetzen, ohne das Protokoll zu ändern.16 GB reicht aus, um Großsprachmodellberechnungen durchzuführen, was bedeutet, dass Sie heute 16 GB -Modelle auf AO herunterladen und ausführen können.Zum Beispiel die unquantitative Version von Falcon 3 von Lama 3 und vielen anderen Modellen.

Dies ist eine Kernkomponente, die erforderlich ist, um ein grundlegendes Computersystem für intelligente Sprachen zu erstellen.Jetzt, da es im Rahmen eines intelligenten Vertrags vollständig unterstützt wird, ist es sehr, sehr aufregend.

Dadurch wird eine wichtige rechnerische Einschränkung von AO- und nachfolgenden Smart Contract -Systemen beseitigt.Wenn wir im Februar dieses Jahres AO veröffentlicht haben, stellen Sie vielleicht fest, dass wir in dem Video viele Male erwähnt haben, dass Sie unbegrenzte Rechenleistung haben, aber es gibt eine Grenze, dh Sie können 4 GB Speicher nicht überschreiten.Dies ist das Heben dieser Einschränkung.Wir glauben, dass dies ein sehr aufregender Fortschritt ist, und 16 GB reicht aus, um fast jedes Modell auszuführen, das Sie im aktuellen KI -Feld ausführen möchten.

Wir konnten die 16 -GB -Grenze erhöhen, ohne das Protokoll zu ändern, was in Zukunft relativ einfach sein wird, ein großer Schritt im Vergleich zu zunächst ausführender Web -Montage 64.Daher ist dies selbst eine enorme Verbesserung der Systemfähigkeiten.Die zweite Haupttechnologie, mit der große Sprachmodelle auf AO betrieben werden können, ist Webedrive.

Mit WeavedRive können Sie wie eine lokale Festplatte auf Arweave -Daten in AO zugreifen.Dies bedeutet, dass Sie jede Transaktions -ID in der AO öffnen können, die von der Planungseinheit authentifiziert und in das Netzwerk hochgeladen wird.Natürlich können Sie auf diese Daten zugreifen und sie in Ihr Programm lesen, genau wie eine Datei auf Ihrer lokalen Festplatte.

Wir alle wissen, dass derzeit etwa 6 Milliarden Transaktionsdaten auf Arweave gespeichert sind. Dies ist also ein großer Datensatz -Ausgangspunkt.Dies bedeutet auch, dass in Zukunft die Motivation, Daten auf Arweave hochzuladen, in Zukunft zunimmt, da diese Daten auch in AO -Programmen verwendet werden können.Wenn wir beispielsweise ein großes Sprachmodell auf Arweave erhalten, laden wir ein Modell im Wert von etwa 1.000 US -Dollar in das Netzwerk hoch.Aber das ist nur der Anfang.

Mit einem intelligenten Vertragsnetzwerk mit einem lokalen Dateisystem ist die Anzahl der Anwendungen, die Sie erstellen können, enorm.Es ist also sehr aufregend.Noch besser ist, dass wir ein System erstellt haben, mit dem Sie Daten in die Ausführungsumgebung streamen können.Es ist eine technische Nuance, aber Sie können sich vorstellen, zur Analogie des Buches zurückzukehren.

Jemand hat Ihnen gesagt, dass ich auf eine der Daten in Ihrem Buch zugreifen möchte.Ich möchte ein Diagramm aus diesem Buch erhalten.In einem einfachen System wäre dies selbst im aktuellen Smart Contract -Netzwerk eine enorme Verbesserung und Sie würden das gesamte Buch geben.Dies ist jedoch offensichtlich ineffizient, insbesondere wenn dieses Buch ein großes statistisches Modell mit Tausenden von Seiten ist.

Dies ist äußerst ineffizient.Stattdessen tun wir in AO, dass Sie Bytes direkt lesen können.Sie gehen direkt in die Tabellenposition im Buch. Kopieren Sie das Diagramm einfach in Ihre Anwendung und führen sie aus.Dies verbessert die Effizienz des Systems erheblich.Dies ist nicht nur ein minimal lebensfähiges Produkt (MVP), sondern auch ein voll funktionsfähiger und gut gebauter Datenzugriffsmechanismus.Sie haben also ein unendliches Computersystem und eine unendliche Festplatte, kombinieren Sie sie zusammen und Sie haben einen Supercomputer.

Dies wurde noch nie zuvor gebaut und jetzt ist es allen zu den niedrigsten Kosten zur Verfügung.Hier ist AO und wir sind sehr aufgeregt darüber.Die Implementierung dieses Systems befindet sich ebenfalls auf Betriebssystemebene.Deshalb verwandten wir Weavedrive in ein Subprotokoll von AO, eine Erweiterung der Computereinheit, die jeder laden kann.Dies ist interessant, da dies die erste Erweiterung dieser Art ist.

AO hatte schon immer die Möglichkeit, Ihre Ausführungsumgebung zu skalieren.Genau wie Sie einen Computer haben, möchten Sie mehr Speicher einfügen oder eine Grafikkarte einfügen. Sie stellen ein Gerät physisch in das System ein.Sie können dies auf der Recheneinheit der AO tun, und das tun wir hier.Auf Betriebssystemebene haben Sie jetzt eine Festplatte, die nur das Dateisystem für die Datenspeicherung darstellt.

Dies bedeutet, dass Sie nicht nur auf diese Daten in AO zugreifen können, sondern die Anwendung auf die übliche Weise erstellen, sondern Sie auch aus jeder im Netzwerk mitgelieferten Anwendung darauf zugreifen können.Daher ist dies eine weit verbreitete Fähigkeit, auf die alle im System eingebauten Personen zugegriffen werden können, unabhängig von der Sprache, in der sie geschrieben sind, Rost, C, Lure, Solidity usw., als ob es native Merkmale des Systems wäre.Beim Aufbau dieses Systems zwingt es uns auch, SubproTocol -Protokolle zu erstellen und Methoden für andere Recheneinheitenverlängerungen zu erstellen, damit andere in Zukunft aufregende Dinge aufbauen können.

Jetzt können wir Berechnungen in einem zentralisierten Speicher jeder Größe ausführen und Daten aus dem Netzwerk in Prozesse innerhalb von AO laden.

Da wir uns dafür entschieden haben, AO in der Webbaugruppe als primäre virtuelle Maschine zu erstellen, ist es relativ einfach zu kompilieren und vorhandene Code in dieser Umgebung auszuführen.Da wir Weavedrive erstellt haben, um es einem Dateisystem auf Betriebssystemebene auszusetzen, ist es tatsächlich relativ einfach, LLAMA.CPP (eine Open-Source-Großsprachenmodell-Inferenz-Engine) auf dem System auszuführen.

Dies ist sehr aufregend, da es bedeutet, dass Sie nicht nur diese Argumentationsmotor, sondern auch viele andere leicht ausführen können.Daher ist die letzte Komponente, die ein großes Sprachmodell innerhalb von AO läuft, die große Sprachmodell -Inferenz -Engine selbst.Wir haben ein System namens llama.cpp portiert, was ein bisschen mysteriös klingt, aber derzeit die führende Open -Source -Modellausführungsumgebung ist.

Wenn Sie direkt im AO -Smart -Vertrag ausgeführt werden, ist es tatsächlich relativ einfach, wenn wir so viele Daten wie im System haben und dann so viele Daten aus Arweave laden.

Um dies zu erreichen, arbeiten wir auch mit einer Computererweiterung namens SIMD (Einzelanlagen-Multi-Daten), mit der Sie diese Modelle schneller ausführen können.So haben wir diese Funktion auch aktiviert.Dies bedeutet, dass diese Modelle derzeit auf der CPU laufen, aber ziemlich schnell sind.Wenn Sie asynchrone Berechnungen haben, sollte dies für Ihr Anwendungsszenario geeignet sein.Wie das Lesen eines Nachrichtensignals und die Entscheidung, welche Transaktionen auszuführen sind, funktioniert es unter dem aktuellen System gut.Wir haben aber auch einige aufregende Upgrades, die in Kürze über andere Beschleunigungsmechanismen diskutiert werden, z.

Mit LLAMA.CPP können Sie nicht nur das führende Modell von Meta Lama 3, sondern auch viele andere Modelle laden, die tatsächlich etwa 90% oder mehr der Modelle aus der Open -Source -Modell -Website herunterladen können, die sich umarmen kann, kann innerhalb des Systems aus dem System ausgeführt werden, von GPT-2, wenn Sie möchten, bis 253 und Monet, das eigene große Sprachmodellsystem von Apple und viele andere Modelle.Wir haben jetzt das Framework, um ein Modell von Arweave hochzuladen, und verwenden Sie die Festplatte, um das Modell, das ich im System ausführen möchte, hochzuladen.Sie laden sie hoch, sie sind nur normale Daten, und dann können Sie sie in den AO -Prozess laden und ausführen, die Ergebnisse erzielen und so arbeiten, wie Sie möchten.Wir denken Auf dem Bild.Um Ihnen dies zu zeigen und es real und verständlich zu machen, haben wir einen Emulator erstellt, Lama Fed.Die Grundidee ist, dass wir ein Fed -Mitgliedskomitee bekommen, sie sind Lama, sowohl als Meta Llama 3 -Modell als auch als Vorsitzender des Fed.

Wir sagen ihnen auch, dass sie Lamas sind, wie Alan Greenspan oder der Fed -Vorsitzende.Sie können diese kleine Umgebung betreten.

Einige Menschen werden mit dieser Umgebung vertraut sein, und es ist tatsächlich wie bei der Versammlung, die wir heute arbeiten. Sie können mit Lama sprechen und sie bitten, Ihnen einige Token für ein sehr interessant Ihre Anfrage.Sie verbrennen also einige Arweave -Token, Kriegs -Token (zur Verfügung gestellt vom AOX -Team) und sie geben Ihnen Token, basierend darauf, ob Ihr Vorschlag als gut angesehen wird.Daher ist dies eine Meme -Währung, und die Geldpolitik ist völlig autonom und intelligent.Während dies eine einfache Form der Intelligenz ist, macht es immer noch Spaß.Es wird Ihre Vorschläge und die Vorschläge anderer bewerten und die Geldpolitik durchführen.All dies kann nun innerhalb eines intelligenten Vertrags erreicht werden, indem Nachrichtenüberschriften analysiert und intelligente Entscheidungen treffen oder mit dem Kundensupport und dem Rückgabewert interagieren.Elliot wird es dir jetzt zeigen.

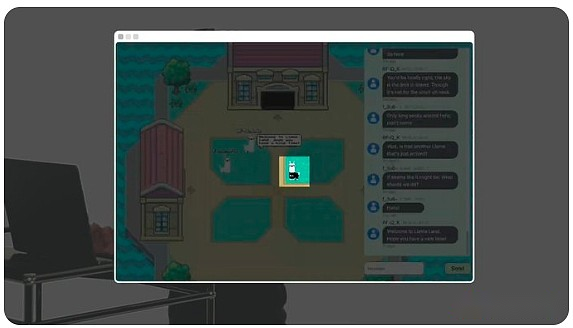

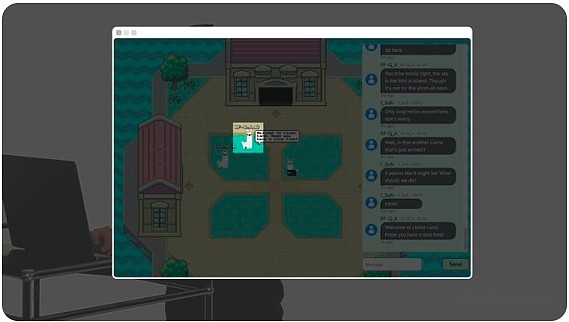

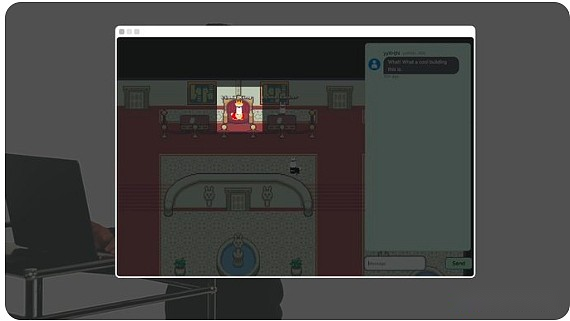

Hallo allerseits, ich bin Elliot, und heute werde ich Ihnen Lama Land zeigen, eine autonome Welt, die in AO läuft, die vom Open-Source-Lama 3-Modell von Meta angetrieben wird.

Das Gespräch, das wir hier sehen, ist nicht nur ein Gespräch zwischen den Spielern, sondern auch eine völlig autonome Anzahl von Lama.

Das Gespräch, das wir hier sehen, ist nicht nur ein Gespräch zwischen den Spielern, sondern auch eine völlig autonome Anzahl von Lama.

Zum Beispiel ist dieses Lama menschlich.

Aber dieses Lama ist eine Ketten-KI.

Das Gebäude enthält Lama -Fed.Es ist wie die Fed, dient aber Lama.

Die Lama-Fed leitet die weltweit erste Geldpolitik der KI und Münz-Lama-Token.

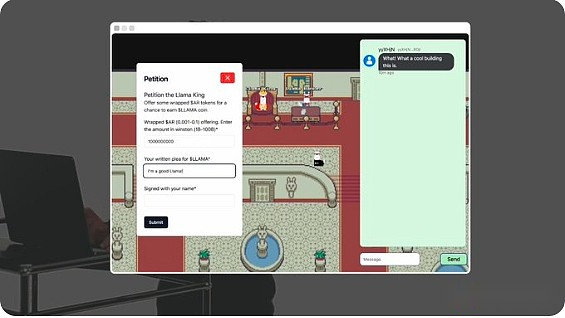

Dieser Typ ist König Lama.Sie können ihm das verpackte Arweave -Token (Krieg) zur Verfügung stellen und eine Anfrage schreiben, um einige Lama -Token zu erhalten.

Lama King AI wird bewerten und entscheiden, ob sie Lama -Token gewähren sollen.Die Geldpolitik von Llamafed ist völlig autonom und hat keine menschliche Aufsicht.Jeder Agent und jeder Raum der Welt selbst ist ein On-Chain-Prozess auf AO.

Es sieht so aus, als hätte King Llama uns einige Token gewährt, und wenn ich mir meine Arconnect -Brieftasche ansehe, kann ich sehen, dass sie bereits da sind.Gut.Lama Land ist nur die erste KI-gesteuerte Welt, die auf AO umgesetzt wird.Dies ist ein Rahmen für ein neues Protokoll, das es jedem ermöglicht, eine eigene autonome Welt aufzubauen. Die einzige Einschränkung ist Ihre Fantasie.All dies ist zu 100% auf Kette und ist nur für AO möglich.

Danke Elliot.Was Sie gerade gesehen haben, ist nicht nur ein großes Sprachmodell, das an finanziellen Entscheidungen teilnimmt und ein autonomes geldpolitisches System betreibt.Ohne eine Hintertür können wir es nicht kontrollieren, die alle von der KI selbst geleitet werden.Sie sehen auch ein kleines Universum, einen Ort, an dem Sie im physischen Raum gehen können, an dem Sie mit der Finanzinfrastruktur interagieren können.Wir denken, es ist nicht nur eine interessante kleine Demonstration.

Hier gibt es tatsächlich etwas sehr Interessantes, wo verschiedene Personen, die Finanzprodukte verwenden, zusammengebracht werden.Wir sehen im Defi -Ökosystem, dass jemand, der an einem Projekt teilnehmen möchte, es zuerst auf Twitter überprüft, dann die Website besuchen und an den grundlegenden Originalen des Spiels teilnehmen möchte.

Anschließend schließen sie sich einer Telegrammgruppe oder einem Discord -Kanal an oder sprechen mit anderen Benutzern auf Twitter.Diese Erfahrung ist sehr dezentralisiert und wir alle springen zwischen verschiedenen Anwendungen.Eine interessante Idee, die wir versuchen, ist, wenn Sie die Benutzeroberfläche dieser Defi -Anwendungen haben, damit ihre Gemeinschaften zusammenkommen und diesen autonomen Bereich, auf den sie gemeinsam zugreifen können, gemeinsam verwalten können, da es sich um eine dauerhafte Webanwendung handelt, die durch Erfahrung verbunden werden kann.

Stellen Sie sich vor, Sie könnten an einen Ort gehen, der wie ein Auktionshaus aussieht und mit anderen Benutzern chatten, die das Protokoll mögen.Wenn es im Finanzmechanismus -Prozess auf AO Aktivitäten gibt, können Sie im Grunde genommen mit anderen Benutzern chatten.Die Gemeinschafts- und sozialen Aspekte werden mit dem finanziellen Teil des Produkts kombiniert.

Wir halten das sehr interessant und wirken sich sogar weiter aus.Hier können Sie einen autonomen KI -Agenten aufbauen, der in dieser Arweave -Welt wandert und mit den verschiedenen von ihm entdeckten Benutzern interagiert.Wenn Sie also ein Meta-Universum erstellen, ist das erste, wenn Sie ein Online-Spiel erstellen, einen NPC (Nicht-Spieler-Charakter).Hier können NPCs universell sein.

Sie haben ein intelligentes System, das herumläuft und mit der Umgebung interagiert, sodass Sie keine kalten Startprobleme von Benutzern haben.Sie können einige autonome Agenten haben, die versuchen, Geld für sich selbst zu verdienen, Freunde zu finden und wie normale Defi -Benutzer mit der Umgebung zu interagieren.Wir fanden es sehr interessant, wenn auch etwas komisch.Wir werden warten und sehen.

In Zukunft sehen wir auch Möglichkeiten, die Ausführung des Großsprachenmodells in AO zu beschleunigen.Früher habe ich über das Konzept der Berechnungseinheiterweiterung gesprochen.Auf diese Weise bauen wir Webedrive auf.

Sie bleiben nicht nur bei Weavedrive, sondern können auch jede Art von Erweiterung für die Computerumgebung von AO erstellen.Es gibt ein sehr aufregendes Ökoprojekt, das dieses Problem für die von der GPU beschleunigte Ausführung von Großsprachmodellen, das APUS-Netzwerk, löst.Ich werde sie erklären lassen.

Hallo, ich bin Mateo.Heute freue ich mich, das APUS -Netzwerk vorzustellen.Das APUS -Netzwerk setzt sich dafür ein, ein dezentrales, vertrauensloses GPU -Netzwerk aufzubauen.

Wir verwenden AO- und APUS-Token, indem wir die dauerhafte On-Chain-Speicherung von Arweave nutzen, eine Open-Source-AO-Erweiterung bereitstellen, eine deterministische Ausführungsumgebung für GPUs bereitstellen und ein wirtschaftliches Anreizmodell für dezentrale KI unter Verwendung von AO- und APUS-Token bereitstellen.Das APUS -Netzwerk verwendet GPU -Miningknoten, um ein optimales, vertrauensloses Modelltraining durchzuführen, das auf Arweave und AO ausgeführt wird.Dies stellt sicher, dass Benutzer das beste KI-Modell zum kostengünstigsten Preis verwenden können.Sie können uns auf X (Twitter) @APUS_NETWORK folgen.Danke.

Dies ist heute die aktuelle Situation von KI auf AO.Sie können Lama Fed versuchen und versuchen, Ihre eigene Smart Contract -Anwendung basierend auf großsprachigen Modellen zu erstellen.Wir glauben, dass dies der Beginn der Einführung von Marktinformationen in ein dezentrales Ausführungsumfeld ist.Wir freuen uns sehr darüber und freuen uns darauf zu sehen, was als nächstes passieren wird.Vielen Dank für Ihre Teilnahme heute und freuen Sie sich darauf, wieder mit Ihnen zu kommunizieren.