Autor: Kyle_13, Fuente: Autor Twitter @kylewmi

Gracias por su llegada hoy.Tenemos una serie de desarrollos súper emocionantes sobre la tecnología AO para compartir con usted.Primero haremos una demostración, y luego Nick y yo intentaremos construir un agente de IA aquí que use un modelo de idioma grande en un contrato inteligente, compra y venta en función del sentimiento de chat que está a punto de escuchar en el sistema .Hoy lo construiremos desde cero en el sitio y esperamos que todo salga bien.

Sí, verá cómo hacerlo todo por su cuenta.

Los avances tecnológicos aquí realmente hacen que AO supere a otros sistemas de contratos inteligentes.Esto ya era cierto antes, y ahora se está volviendo cada vez más como una supercomputadora descentralizada que una red tradicional de contratos inteligentes.Pero tiene todas las características de una red de contratos inteligentes.Por lo tanto, estamos muy emocionados de compartir todo esto contigo.Sin más preámbulos, comencemos la demostración, y tendremos una discusión, y construiremos algo en el sitio juntos.

Hola a todos, gracias por su llegada hoy.Estamos muy emocionados de anunciar tres actualizaciones técnicas principales para el acuerdo AO.Juntos, logran un gran objetivo de apoyar modelos de idiomas grandes que se ejecutan en entornos descentralizados como parte de los contratos inteligentes.Estos no son solo modelos de juguetes, modelos pequeños o modelos compilados en sus propios archivos binarios.

Este es un sistema completo que le permite ejecutar casi todos los modelos principales actualmente de código abierto y disponibles.Por ejemplo, Llama 3 se ejecuta en la cadena en contratos inteligentes, lo mismo es cierto para GPT, así como los modelos de Apple, etc.Este es el resultado de los esfuerzos conjuntos de todo el ecosistema, y tres principales avances tecnológicos también forman parte de este sistema.Por lo tanto, estoy muy emocionado de presentarte todo esto.

La situación general es que LLM (modelo de idioma grande) ahora puede ejecutarse en contratos inteligentes.Es posible que haya oído hablar de las criptomonedas descentralizadas de IA y IA muchas veces.De hecho, a excepción de un sistema que vamos a discutir hoy, casi todos estos sistemas son AIS como oráculos, es decir, ejecute la IA fuera de la cadena y luego coloque los resultados de la ejecución en la cadena para algunos fines aguas abajo.

No estamos hablando de esto.Estamos hablando del razonamiento del modelo de idioma grande como parte de la ejecución del estado de contrato inteligente.Todo esto es gracias al disco duro AO que tenemos y al mecanismo de procesamiento hiperparalelo de AO, lo que significa que puede ejecutar muchos cálculos sin afectar los diferentes procesos que estoy usando.Creemos que esto nos permitirá crear un sistema financiero de agencia autónomo descentralizado muy rico.

Hasta ahora, en finanzas descentralizadas (DEFI), básicamente hemos podido hacer la ejecución de transacciones originales sin confianza.Las interacciones en diferentes juegos económicos, como los préstamos y el intercambio, no requieren confianza.Este es solo un aspecto del problema.Si considera los mercados financieros globales.

Sí, hay una variedad de diferentes originales económicos que funcionan de diferentes maneras.Hay bonos, acciones, productos y derivados, etc.Pero cuando realmente hablamos del mercado, no es solo eso, en realidad es la capa inteligente.Es la persona quien decide comprar, vender, pedir prestado o participar en varios juegos financieros.

Hasta ahora, en el ecosistema financiero descentralizado, hemos transferido con éxito todos estos originales a un estado confiable.Por lo tanto, puede intercambiar en UNISWAP sin confiar en los operadores de UNISWAP.De hecho, fundamentalmente, no hay operadores.La capa inteligente del mercado se queda atrás.Entonces, si desea participar en inversiones de criptomonedas y no quiere hacer toda su investigación y compromiso usted mismo, debe encontrar un fondo.

Puede confiar en sus fondos, y luego van y realizan decisiones inteligentes y las pasan aguas abajo a la ejecución original básica de la red en sí.Creemos que en AO, en realidad tenemos la capacidad de transferir la parte inteligente del mercado, es decir, la inteligencia que conduce a la toma de decisiones, a la red misma.Entonces, una forma simple de entenderlo podría ser imaginarlo.

Un fondo de cobertura o una aplicación de gestión de cartera en la que puede confiar puede ejecutar un conjunto de instrucciones inteligentes dentro de la red, lo que transfiere la confianza de la red al proceso de toma de decisiones.Esto significa que una cuenta anónima, como el Yolo 420 Trader número uno (un comerciante informal y audaz), puede crear una estrategia nueva e interesante e implementarla en la red, donde puede poner capital en ella sin confianza real.

Ahora puede construir agentes autónomos que interactúen con grandes modelos estadísticos.El modelo estadístico grande más común es el modelo de lenguaje grande que puede procesar y generar texto.Esto significa que puede poner estos modelos en contratos inteligentes como parte de una estrategia desarrollada por alguien con ideas novedosas y ejecutarlos de manera inteligente en la red.

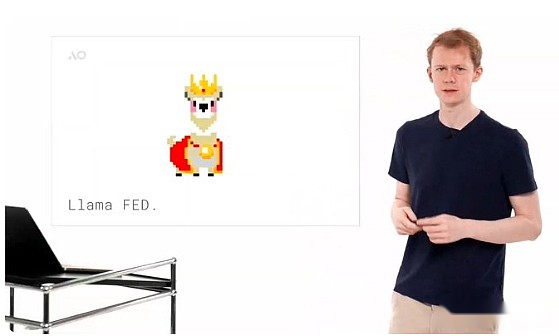

Puedes imaginar hacer un análisis básico de sentimientos.Por ejemplo, si lee las noticias, decide que este es un buen momento para comprar y vender este derivado.Este es un buen momento para hacer uno u otro.Puede tomar decisiones similares a los humanos que funcionan de manera confiable.Esto no es solo una teoría.Creamos una interesante Meme Coin llamada Llama Fed.Básicamente, la idea es que es un simulador de moneda fiduciaria donde el modelo LLAMA 3 representa un montón de llamas (alpacas).

Son como una combinación de Llama y el Presidente de la Fed, puede ir a buscarlos y pedirles que emitan algunos tokens y evaluarán su solicitud.Los modelos de lenguaje grande operan políticas monetarias, completamente autónomas y sin confianza.Lo construimos, pero no pudimos controlarlo.Operan políticas monetarias y determinan quién debe obtener los tokens y quién no debería.Esta es una pequeña aplicación muy interesante de esta tecnología y, con suerte, inspira todas las otras aplicaciones posibles en el ecosistema.

Para lograr esto, debemos crear tres nuevas capacidades básicas para AO, algunas en la capa de protocolo base y otras en la capa de aplicación.Esto no solo es útil para la ejecución de modelos de idiomas grandes, sino que es más extenso y emocionante para los desarrolladores de AO.Así que me alegra presentarlos hoy.

El primero de estas nuevas tecnologías es el soporte de 64 bits de ensamblaje web.Suena un poco como un término técnico, pero tengo una manera de hacer que todos entiendan lo que significa.Fundamentalmente, el soporte del ensamblaje web 64 permite a los desarrolladores crear aplicaciones que usan más de 4 GB de memoria.Presentaremos las nuevas restricciones más adelante, son bastante sorprendentes.

Si no es un desarrollador, puede entenderlo de esta manera: alguien le pidió que escribiera un libro y está entusiasmado con la idea, pero dicen que solo puede escribir 100 páginas.No más o menos.Puede expresar las ideas en el libro, pero no se puede hacer de manera natural y normal, porque hay restricciones externas y debe atender a él y cambiar la forma en que escribe para que se ajuste.

Si no es un desarrollador, puede entenderlo de esta manera: alguien le pidió que escribiera un libro y está entusiasmado con la idea, pero dicen que solo puede escribir 100 páginas.No más o menos.Puede expresar las ideas en el libro, pero no se puede hacer de manera natural y normal, porque hay restricciones externas y debe atender a él y cambiar la forma en que escribe para que se ajuste.

En el ecosistema de contrato inteligente, esto es más que un límite de 100 páginas.Diría que es un poco como construir en versiones anteriores de AO.Ethereum tiene un límite de memoria de 48 kb, al igual que alguien le pidió que escribiera un libro que tenga solo una oración de largo, y solo puede usar las 200 palabras en inglés más populares.Construir una aplicación realmente emocionante en este sistema es extremadamente difícil.

Luego está Solana, donde puede acceder a 10 MB de memoria de trabajo.Obviamente, esto es una mejora, pero básicamente estamos hablando de una página.ICP, protocolo informático de Internet, permite soporte para 3GB de memoria.Está completo en teoría, pero tuvieron que bajarlo a 3GB.Ahora con 3GB de memoria, puede ejecutar muchas aplicaciones diferentes, pero ciertamente no puede ejecutar grandes aplicaciones de IA.Requieren cargar grandes cantidades de datos en la memoria principal para un acceso rápido.Esto no se puede implementar de manera efectiva en 3GB de memoria.

Cuando lanzamos AO en febrero de este año, también tuvimos un límite de memoria de 4 GB, que en realidad se originó en el ensamblaje web 32.Ahora, este límite de memoria ha desaparecido por completo a nivel de protocolo.En cambio, el límite de memoria a nivel de protocolo es 18EB (Exabytes).Esta es una gran cantidad de almacenamiento.

Tomará bastante tiempo hasta que esto se use en la memoria para los cálculos en lugar de los medios de almacenamiento a largo plazo.En el nivel de implementación, la unidad informática en la red AO, ahora tiene acceso a 16 GB de memoria, pero en el futuro será relativamente fácil reemplazarla con una memoria de mayor capacidad sin cambiar el protocolo.16GB es suficiente para ejecutar cálculos de modelos de idiomas grandes, lo que significa que puede descargar y ejecutar modelos de 16 GB en AO hoy.Por ejemplo, la versión no cuantitativa de Falcon 3 de Llama 3 y muchos otros modelos.

Este es un componente central necesario para construir un sistema informático básico para lenguajes inteligentes.Ahora que es totalmente compatible en la cadena como parte de un contrato inteligente, creemos que es muy, muy emocionante.

Esto elimina una importante limitación computacional de AO y sistemas de contratos inteligentes posteriores.Cuando lanzamos AO en febrero de este año, puede notar que mencionamos muchas veces en el video que tiene potencia informática ilimitada, pero hay un límite, es decir, no puede exceder los 4 GB de memoria.Este es el levantamiento de esa restricción.Creemos que este es un avance muy emocionante, y 16 GB es suficiente para ejecutar casi todos los modelos que desee ejecutar en el campo AI actual.

Pudimos aumentar el límite de 16 GB sin cambiar el protocolo, lo que será relativamente fácil en el futuro, un gran paso en comparación con la ejecución inicial de Web Websembly 64.Por lo tanto, esta es una gran mejora en las capacidades del sistema.La segunda tecnología importante que permite que los grandes modelos de idiomas se ejecuten en AO es Weavedrive.

Weavedrive le permite acceder a los datos de Arweave en AO como un disco duro local.Esto significa que puede abrir cualquier ID de transacción en el AO que sea autenticado por la unidad de programación y cargarla en la red.Por supuesto, puede acceder a estos datos y leerlos en su programa, al igual que un archivo en su disco duro local.

Todos sabemos que hay alrededor de 6 mil millones de datos transaccionales almacenados en Arweave en la actualidad, por lo que este es un gran punto de partida del conjunto de datos.Esto también significa que en el futuro, la motivación para cargar datos a Arweave aumenta, ya que estos datos también se pueden usar en los programas AO.Por ejemplo, cuando obtenemos un modelo de lenguaje grande que se ejecute en Arweave, cargamos un modelo con un valor de aproximadamente $ 1,000 a la red.Pero esto es solo el comienzo.

Con una red de contrato inteligente con un sistema de archivos local, la cantidad de aplicaciones que puede construir es enorme.Entonces, es muy emocionante.Aún mejor, creamos un sistema que le permite transmitir datos al entorno de ejecución.Es un matiz técnico, pero puedes imaginar volver a la analogía del libro.

Alguien te dijo que quiero acceder a uno de los datos de tu libro.Quiero obtener una tabla de este libro.En un sistema simple, incluso en la red actual de contratos inteligentes, esta sería una gran mejora y usted daría todo el libro.Sin embargo, esto es obviamente ineficiente, especialmente si ese libro es un modelo estadístico grande con miles de páginas.

Esto es extremadamente ineficiente.En cambio, lo que hacemos en AO es que puedes leer bytes directamente.Usted va directamente a la posición del gráfico en el libro, simplemente copie la tabla en su aplicación y ejecute.Esto mejora enormemente la eficiencia del sistema.Este no es solo un producto mínimamente viable (MVP), es un mecanismo de acceso de datos completamente funcional y bien construido.Por lo tanto, tiene un sistema informático infinito y un disco duro infinito, combínelos y tendrá una supercomputadora.

Esto nunca antes se ha construido y ahora está disponible para todos al menor costo.Ahí es donde está AO y estamos muy entusiasmados con eso.La implementación de este sistema también está en el nivel del sistema operativo.Por lo tanto, convertimos Weavedrive en un subprotocolo de AO, que es una extensión de la unidad informática que cualquiera puede cargar.Esto es interesante porque esta es la primera extensión de este tipo.

AO siempre ha tenido la capacidad de agregar escala a su entorno de ejecución.Al igual que tiene una computadora, desea enchufar más memoria o insertar una tarjeta gráfica, coloca físicamente una unidad en el sistema.Puedes hacer esto en la unidad de cómputo de AO, y eso es lo que hacemos aquí.Entonces, a nivel del sistema operativo, ahora tiene un disco duro que solo representa el sistema de archivos que almacenamiento de datos.

Esto significa que no solo puede acceder a estos datos en AO, creando la aplicación de la manera habitual, sino que puede acceder a él desde cualquier aplicación que se traiga a la red.Por lo tanto, esta es una capacidad ampliamente aplicable a la que pueden acceder todas las personas construidas en el sistema, independientemente del lenguaje en el que estén escritos, óxido, c, señuelo, solidez, etc., como si fueran características nativas del sistema.En el proceso de construcción de este sistema, también nos obliga a crear protocolos de subprotocolos, crear métodos para otras extensiones de la unidad informática para que otros puedan construir cosas emocionantes en el futuro.

Ahora tenemos la capacidad de ejecutar cálculos en una memoria centralizada de cualquier tamaño y cargar datos de la red en procesos dentro de AO.

Dado que elegimos construir AO en el ensamblaje web como su máquina virtual principal, es relativamente fácil compilar y ejecutar el código existente en ese entorno.Dado que construimos Weavedrive para exponerlo a un sistema de archivos a nivel de sistema operativo, en realidad es relativamente fácil ejecutar llama.cpp (un motor de inferencia de modelo de lenguaje grande de código abierto) en el sistema.

Esto es muy emocionante porque significa que puede ejecutar no solo este motor de razonamiento, sino también muchos otros fácilmente.Por lo tanto, el último componente que hace que un modelo de lenguaje grande se ejecute dentro de AO es el motor de inferencia de modelos de lenguaje grande.Portamos un sistema llamado Llama.CPP, que suena un poco misterioso, pero en realidad es el entorno de ejecución de modelos de código abierto líder en la actualidad.

Al ejecutar directamente dentro del contrato inteligente AO, en realidad es relativamente fácil una vez que tenemos la capacidad de tener tantos datos como tenemos en el sistema y luego cargando tantos datos de Arweave.

Para lograr esto, también trabajamos con una extensión de computación llamada SIMD (instrucción única de múltiples datos) que le permite ejecutar estos modelos más rápido.Así que también habilitamos esta función.Esto significa que estos modelos se ejecutan actualmente en la CPU, pero son bastante rápidos.Si tiene cálculos asíncronos, debe ser adecuado para su escenario de uso.Al igual que leer una señal de noticias y luego decidir qué transacciones ejecutar, funciona bien bajo el sistema actual.Pero también tenemos algunas actualizaciones emocionantes que se discutirán pronto, con respecto a otros mecanismos de aceleración, como el uso de GPU para acelerar la inferencia del modelo de lenguaje grande.

Llama.cpp le permite cargar no solo el modelo LLAMA 3 líder de Meta, sino también muchos otros modelos, que en realidad son aproximadamente el 90% o más de los modelos que puede descargar desde el sitio web de modelos de código abierto que abraza la cara puede ejecutarse dentro del sistema, desde GPT-2 Si lo desea, a 253 y Monet, el propio sistema de modelos de idiomas de Apple y muchos otros modelos.Por lo tanto, ahora tenemos el marco para cargar cualquier modelo desde Arweave, utilizando el disco duro para cargar el modelo que quiero ejecutar en el sistema.Los sube, son solo datos normales, y luego puede cargarlos en el proceso AO y ejecutarlos, obtener los resultados y trabajar de la manera que desee.Creemos que este es un paquete que hace posible las aplicaciones que no fueron posibles en el ecosistema de contrato inteligente anterior, e incluso si es posible ahora, el número de cambios arquitectónicos en los sistemas existentes como Solana es simplemente impredecible y no en su ruta En la imagen.Entonces, para mostrarte esto y hacerlo real y comprensible, creamos un emulador, Llama Fed.La idea básica es que obtenemos un comité miembro de la Fed, son LLAMA, tanto en el modelo Meta Llama 3 como en el Presidente de la Fed.

También les decimos que son llamas, como Alan Greenspan o el presidente de la Fed.Puede ingresar a este pequeño entorno.

Algunas personas estarán familiarizadas con este entorno, y en realidad es como la reunión que trabajamos hoy, puede hablar con Llama y pedirles que le den algunas fichas para un proyecto muy interesante, y decidirán si le darán en función de tu solicitud.Por lo tanto, quema algunas fichas de Arweave, fichas de guerra (proporcionadas por el equipo de AOX) y le darán fichas en función de si su propuesta se considera buena.Por lo tanto, esta es una moneda de memes, y la política monetaria es completamente autónoma e inteligente.Si bien esta es una forma simple de inteligencia, sigue siendo divertido.Evaluará sus propuestas y las propuestas de otros y ejecutará una política monetaria.Todo esto ahora se puede lograr dentro de un contrato inteligente analizando los titulares de noticias y tomando decisiones inteligentes o interactuando con la atención al cliente y el valor de retorno.Elliot ahora te lo mostrará.

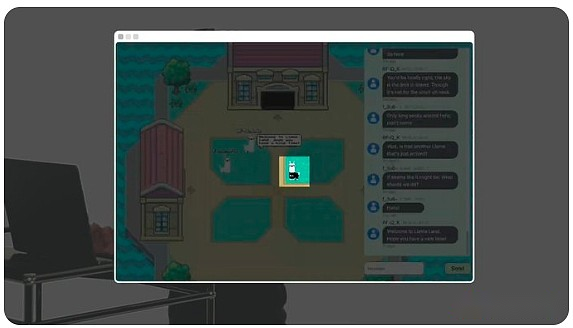

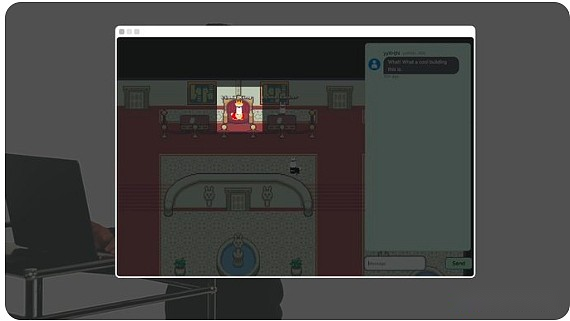

Hola a todos, soy Elliot, y hoy te voy a mostrar Llama Land, un mundo autónomo en la cadena que se ejecuta en AO, impulsado por el modelo de código abierto 3 de Meta’s Open Llama.

La conversación que vemos aquí no es solo una conversación entre jugadores, sino también una llama de número completamente autónomo.

La conversación que vemos aquí no es solo una conversación entre jugadores, sino también una llama de número completamente autónomo.

Por ejemplo, esta llama es humana.

Pero esta llama está en la cadena AI.

El edificio contiene llamas alimentadas.Es como el Fed, pero sirve a la llama.

Llama Fed dirige las primeras tokens de política monetaria de IA y Mints Llama de la IA.

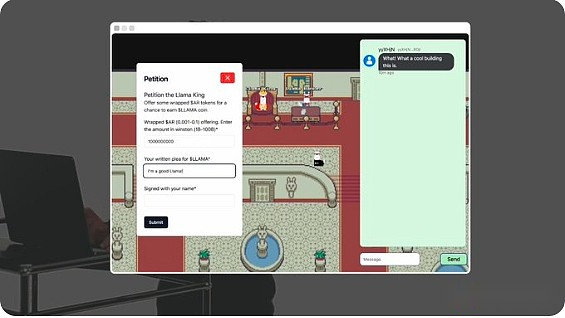

Este tipo es King Llama.Puede proporcionarle la ficha de Arweave (guerra) empaquetada y escribir una solicitud para obtener algunos tokens de llama.

Llama King Ai evaluará y decidirá si otorgará tokens de llama.La política monetaria de Llamafed es completamente autónoma y no tiene una supervisión humana.Cada agente y cada habitación del mundo en sí es un proceso en la cadena en AO.

Parece que King Llama nos ha otorgado algunas fichas y si miro mi billetera Arconnect, puedo ver que ya están allí.bien.Llama Land es solo el primer mundo impulsado por la IA que se implementa en AO.Este es un marco para un nuevo protocolo que permite a cualquiera construir su propio mundo autónomo, la única limitación es su imaginación.Todo esto es 100% en la cadena y solo es posible en AO.

Gracias Elliot.Lo que acaba de ver no es solo un modelo de lenguaje grande que participa en la toma de decisiones financieras y la ejecución de un sistema de política monetaria autónoma.Sin una puerta trasera, no podemos controlarlo, todos los cuales son administrados por la propia IA.También ves un pequeño universo, un lugar donde puedes caminar en el espacio físico, donde puedes ir para interactuar con la infraestructura financiera.Creemos que no es solo una pequeña demostración interesante.

En realidad, hay algo muy interesante aquí, donde se unen diferentes personas que usan productos financieros.Vemos en el ecosistema Defi que si alguien quiere participar en un proyecto, primero lo revise en Twitter, luego visite el sitio web y participe en los originales básicos del juego.

Luego se unen a un grupo de telegrama o un canal de discordia o hablan con otros usuarios en Twitter.Esta experiencia está muy descentralizada y todos saltamos entre diferentes aplicaciones.Una idea interesante que estamos intentando es que si tiene la interfaz de usuario de estas aplicaciones Defi, para que sus comunidades puedan unirse y administrar conjuntamente este espacio autónomo al que acceden colectivamente, porque es una aplicación web permanente a la que la experiencia puede unirse.

Imagine que podría ir a un lugar que se parece a una casa de subastas y charlar con otros usuarios que les gusta el protocolo.Cuando hay actividad en el proceso de mecanismo financiero que ocurre en AO, básicamente puede chatear con otros usuarios.La comunidad y los aspectos sociales se combinan con la parte financiera del producto.

Creemos que esto es muy interesante e incluso tiene un impacto más amplio.Aquí puede construir un agente de IA autónomo que deambule por este mundo de Arweave, interactuando con las diferentes aplicaciones y usuarios que descubre.Entonces, si está construyendo un meta universo, cuando crea un juego en línea, lo primero es crear un NPC (personaje que no sea jugador).Aquí, los NPC pueden ser universales.

Tiene un sistema inteligente que deambula e interactúa con el entorno, por lo que no tiene problemas de inicio de frío de los usuarios.Puede tener algunos agentes autónomos que intentan ganar dinero para usted, tratando de hacer amigos e interactuar con el entorno como los usuarios de Defi normales.Pensamos que era muy interesante, aunque un poco extraño.Esperaremos y veremos.

En el futuro, también vemos oportunidades para acelerar la ejecución del modelo de idioma grande en AO.Anteriormente hablé sobre el concepto de extensión de la unidad informática.Así es como usamos para construir Weavedrive.

No solo permanecer en Weavedrive, puede construir cualquier tipo de extensión para el entorno informático de AO.Hay un proyecto ecológico muy emocionante que está resolviendo este problema para la ejecución acelerada de GPU de modelos de idiomas grandes, que es la red APUS.Dejaré que expliquen.

Hola, soy Mateo.Hoy estoy emocionado de presentar la red APUS.APUS Network se compromete a construir una red de GPU descentralizada y confiable.

Utilizamos los tokens AO y APUS aprovechando el almacenamiento permanente en cadena de Arweave, proporcionando una extensión AO de código abierto, proporcionando un entorno de ejecución determinista para las GPU y proporcionando un modelo de incentivo económico para la IA descentralizada, utilizando tokens AO y APUS.APUS Network utilizará nodos mineros de GPU para competir para realizar un entrenamiento de modelos óptimo y sin confianza que se ejecuta en Arweave y AO.Esto asegura que los usuarios puedan usar el mejor modelo de IA al precio más rentable.Puede seguirnos en X (Twitter) @apus_network.Gracias.

Esta es la situación actual de AI en AO hoy.Puede probar Llama Fed e intentar construir su propia aplicación de contrato inteligente basada en modelos de idiomas grandes.Creemos que este es el comienzo de la introducción de inteligencia de mercado a un entorno de ejecución descentralizado.Estamos muy entusiasmados con esto y esperamos ver lo que sucederá después.Gracias por su participación hoy y espero comunicarse con usted nuevamente.